Stabilizer IL/NAI - nbep11 v0.114

Verwandte Schlüsselwörter & Tags

Empfohlene Prompts

<lora:noobai_ep11_stabilizer_v0.114_fp16:0.8>1girl, fox ears, masterpiece

Empfohlene Parameter

samplers

steps

cfg

resolution

other models

Tipps

Dieses LoRA zuerst im LoRA-Stack laden wegen dynamischer Patch-Gewichtsberechnung in der DoRA-Architektur.

Als feingetuntes Basismodell verwenden, indem es mit voller Stärke auf ein vortrainiertes Basismodell geladen wird (empfohlen).

Vermeide die Kombination dieses LoRA mit inkompatiblen Basismodellen, um Qualitätsverluste bei Bildern zu verhindern.

Das Teilen von Merges mit diesem Modell ist verboten; es enthält versteckte Triggerwörter für unsichtbare Wasserzeichen.

Bei Übersättigung oder Kontrastproblemen in Basismodellen können ergänzende LoRAs wie Contrast Controller oder Dark verwendet werden.

Dieses Modell ist ohne Standardstil-Bias konzipiert und erlaubt volle Stilkontrolle über Prompts oder zusätzliche LoRAs.

Ersteller-Sponsoren

Schau dir die Stabilizer kompatible LoRA-Sammlung für flexiblere Stilgestaltung an.

Probiere den Contrast Controller für stabile Kontrastkontrolle.

Entdecke Dark LoRA zum Beheben von Helligkeits-Bias in manchen Basismodellen.

Finde die neuesten Modelle bei Neta Lumina und Lumina 2.

Trete der Community auf TensorArt bei.

Was du siehst, ist was du bekommst. Titelbilder sind der rohe Output des vortrainierten Modells in 1MP-Auflösung. Es gibt keinen magischen Plug-in, keine Hochskalierung, keine Korrekturen von Händen/Gesichtern durch Inpainting, nicht einmal einen Negativ-Prompt. Einige Nutzer gaben an, dass sie es nicht reproduzieren können, das ist ein Fertigkeitsproblem. (Falsches Basismodell oder zu viele "Optimierungen" hinzugefügt)

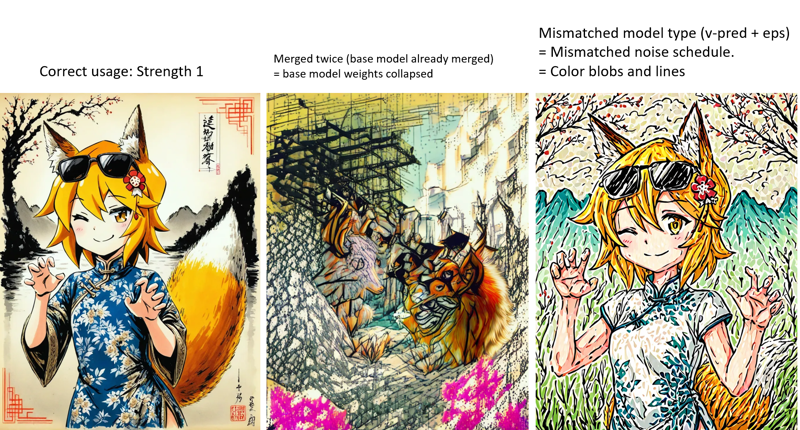

Wenn es dein Basismodell selbst bei niedriger Stärke (z.B. <0,5) zerstört hat, liegt das an deinem Basismodell. Dein Basismodell hat dieses LoRA bereits integriert (und du hast es zweimal integriert). Die Modellgewichte wurden multipliziert und sind kollabiert. Achte auf gefälschte Basismodell-Ersteller, auch bekannt als Diebe. Manche "Creators" machen kein eigenes Training, sie übernehmen nur Modelle anderer, mischen sie, löschen alle Metadaten und Credits und verkaufen sie als eigene Basismodelle.

Angeheftete Notiz:

(27.9.2025): Zeit nach vorne zu blicken...

Dieses Modell wird nicht weiter aktualisiert.

SDXL ist einfach zu ... veraltet, es wurde vor zwei Jahren veröffentlicht (Juni 2023). Neue Modelle sind dank der neuen Architektur wesentlich effizienter.

Beim Verfassen probierte ich Neta Lumina (Lumina 2) und Chroma (Flux.1) aus.

Lumina 2 wurde im Januar 2025 veröffentlicht, nur 1,25x größer als SDXL, aber in allen Aspekten besser aufgrund der neuen Modellarchitektur. NetaYume Lumina und Neta Lumina sind auf Danbooru und e621 trainierte Anime-Stil-Modelle.

Ich habe ein "Enhancement Bundle" LoRA für NetaYume Lumina trainiert. Wie dieser "Stabilizer" liefert es bessere Details und weniger Rauschen. Und wurde in einen weniger irreführenden Namen geändert. Du kannst es probieren, wenn du Comfyui hast.

Chroma vielleicht später...

Neue Modelle werden auf neuen Seiten veröffentlicht. Diese Seite wird nicht mehr aktualisiert.

Außerdem denke ich nicht, dass sie diese Modelle unterstützen werden. Ich bin auf TensorArt gewechselt. Du findest mich hier. Versuch auch Lumina 2 Modelle.

Stabilizer

Ein großes kleinmaßstäblich feingetuntes Modell mit 7k Bildern.

Fokus auf Kreativität statt auf einen festen Stil. Der Datensatz ist sehr vielfältig. Dieses Modell hat daher keinen Standardstil (Bias), der seine Kreativität einschränkt.

Nur natürliche Texturen, Beleuchtung und feinste Details. Kein plastisch-glänzender KI-Stil. Ich habe jedes einzelne Bild sorgfältig ausgewählt. Training mit KI-Bildern kann verrückte Effekte verstärken, aber ich mag das nicht.

Bessere Prompt-Verständnis. Trainiert mit natürlichen Sprachbeschreibungen.

(v-pred) Bessere und ausgewogene Beleuchtung, kein Überlaufen und keine Übersättigung. Möchtest du reines Schwarz 0 und Weiß 255 im selben Bild, sogar am selben Ort? Kein Problem.

Warum keinen Standardstil?

Was ist "Standardstil": Wenn ein Modell einen Standardstil (Bias) hat, bedeutet das, dass es egal ist, was du als Prompt gibst, das Modell immer dieselben Dinge generiert (Gesichter, Hintergründe, Gefühle), die den Standardstil ausmachen.

Vorteile: Es ist einfach zu benutzen, du musst Stil nicht mehr prompten.

Nachteile: Du kannst ihn aber auch nicht überschreiben. Wenn du etwas eingibst, das nicht zum Standardstil passt, ignoriert das Modell es einfach. Wenn du mehrere Stile übereinander stapelst, wird der Standardstil immer überlappen/verschmutzen/begrenzen.

"Kein Standardstil" bedeutet kein Bias, und du musst den gewünschten Stil per Tags oder LoRAs angeben. Dann gibt es keine Stilüberlappung/-verschmutzung durch dieses Modell. Du erhältst genau den gestapelten Stil, wie er sein soll.

Warum ist das"feingetunte Basismodell" ein LoRA?

Ich bin kein Gigachad und habe keine Millionen Trainingsbilder. Das komplette Feintuning des Basismodells ist nicht nötig, ein LoRA reicht.

Ich muss nur eine winzige 40MiB-Datei hochladen, du nur herunterladen, statt einen 7GiB großen Checkpoint. Das spart 99,4% Daten und Speicher.

Also kann ich Updates spammen.Diese LoRA scheint klein zu sein, ist aber kraftvoll. Sie nutzt eine neue Nvidia-Architektur namens DoRA, die effizienter ist als traditionelle LoRA.

Wie erhalte ich dieses "feingetunte Basismodell"?

Einfach.

vortrainiertes Basismodell + dieses LoRA = das "feingetunte Basismodell"

Lade dieses LoRA mit voller Stärke auf das vortrainierte Basismodell. Dann wird das vortrainierte Basismodell zum feingetunten Basismodell. Siehe unten "Anwendung".

Das Teilen von Merges mit diesem Modell ist verboten. Es gibt versteckte Triggerwörter für unsichtbare Wasserzeichen. Ich habe Wasserzeichen und Detektor selbst programmiert. Ich will es nicht benutzen, aber ich kann.

Dieses Modell ist nur auf Civitai und TensorArt veröffentlicht. Wenn du "mich" und diesen Satz auf anderen Plattformen siehst, sind das Fälschungen und die Plattform ist ein Piratenportal.

Bitte gib Feedback im Kommentarbereich ab, damit alle es sehen können. Schreibe kein Feedback im Civitai-Bewertungssystem, das ist so schlecht gestaltet, dass niemand die Bewertungen findest.

Anwendung

Neueste Versionen:

nbvp10 v0.271 (für NoobAI v-pred v1.0).

Genauere Farben und feinste Details. Das bisher beste Modell.

Es ist ein v-pred LoRA, es funktioniert NUR mit NoobAI v-pred v1.0. Funktioniert NICHT mit eps-Modellen.

nbep10 v0.273 (für NoobAI eps v1.0).

Weniger Sättigung und Kontrast im Vergleich zu v-pred Modellen. Aufgrund eines "kleinen Designsfehlers" in der Standard-Epsilon- (eps) Vorhersage. Das begrenzt die Farbpalette des Modells. Deshalb gibt es später v-pred.

illus01 v1.198 (trainiert auf Illustrious v0.1).

Alte Version, nicht mehr empfohlen.

Beachte, dass die meisten (90%) Anime-Basismodelle, die heute als "illustrious" gekennzeichnet sind, tatsächlich NoobAI sind. Verwende also besser die NoobAI-Versionen oben. Mismatches zwischen LoRA und Basismodell verschlechtern die Bildqualität.

Lade dieses LoRA immer zuerst in deinem LoRA-Stack.

Dieses LoRA verwendet die neue Nvidia-Architektur DoRA, die effizienter ist als traditionelle LoRA. Im Gegensatz zu herkömmlichen LoRA, die statische Patch-Gewichte haben, werden bei DoRA-Patch-Gewichte dynamisch basierend auf dem aktuell geladenen Basismodell-Gewicht berechnet (das sich beim Laden von LoRAs ändert). Um unerwartete Änderungen zu minimieren, lade dieses LoRA zuerst.

Zwei Möglichkeiten dieses Modell zu verwenden:

1). Als feingetuntes Basismodell verwenden (empfohlen):

Für feinste und natürliche Details und um den gewünschten Stil mit voller Kontrolle zu kombinieren.

Lade dieses LoRA mit voller Stärke zuerst auf das vortrainierte Basismodell. Dann wird das vortrainierte Basismodell zu meinem feingetunten Basismodell, das alle Coverbilder erzeugt hat.

2). Als LoRA auf anderen feingetunten Basismodellen verwenden.

Es ist schließlich eine LoRA.

Datensatz

Neueste oder aktuelle Versionen

~7k Bilder insgesamt. Nicht riesig (verglichen mit Gigachads, die mit Millionen Bildern finetunen), aber nicht klein. Jedes Bild wurde von mir persönlich ausgewählt.

Nur normale, ansprechende Motive. Kein verrückter Kunststil, der sich nicht beschreiben lässt.

Keine KI-Bilder. Nicht unter meiner Aufsicht.

Nur hochauflösende Bilder. Der durchschnittliche Datensatz hat 3,37 MP, ca. 1800x1800 Pixel.

Alle Bilder besitzen natürliche Beschreibungen von Google LLM.

Andere Werkzeuge

Einige Ideen, die Teil des Stabilizer werden sollten oder waren. Jetzt sind es separate LoRAs für mehr Flexibilität. Sammlung hier: https://civitai.com/collections/8274233.

Dark: Ein LoRA, das dunkler Umgebungen bevorzugt. Nützlich, um hohe Helligkeits-Bias in manchen Basismodellen zu korrigieren. Trainiert auf Bildern mit geringer Helligkeit. Kein Stil-Bias, daher keine Stilverschmutzung.

Contrast Controller: Handgefertigtes LoRA. Steuert den Kontrast wie ein Slider auf deinem Monitor. Anders als andere "Kontrast-Verbesserer" ist die Wirkung dieses LoRA stabil, mathematisch linear und ohne Stil-Einfluss.

Nützlich, wenn dein Basismodell Übersättigung hat oder du mehr Farbe willst.

Beispiel:

Style Strength Controller: Oder Überanpassungsreduzierer. Kann alle Arten von Überanpassung (Bias auf Objekte, Helligkeit etc.) mathematisch reduzieren. Oder verstärken, falls gewünscht.

Unterschiede zum Stabilizer:

Unterschiede zum Stabilizer:

Stabilizer wurde mit realen Daten trainiert. Er kann nur Überanpassung an Textur, Details und Hintergründe "reduzieren", indem er sie zurückgibt.

Style Controller ist kein Trainingsergebnis. Er wirkt wie ein "Rückgängig" für das Basismodelltraining, wodurch es weniger überangepasst wird. Kann mathematisch alle Überanpassungen reduzieren, wie Bias auf Helligkeit oder Objekte.

Alte Versionen:

Mehr Infos findest du im "Update-Log". Beachte, dass alte Versionen stark unterschiedliche Effekte haben können.

Hauptzeitstrahl:

Jetzt ~: Natürliche Details und Texturen, stabiles Prompt-Verstehen und mehr Kreativität. Nicht mehr nur auf reinen 2D-Anime-Stil begrenzt.

illus01 v1.23 / nbep11 0.138 ~: Besserer Anime-Stil mit lebendigen Farben.

illus01 v1.3 / nbep11 0.58 ~: Besserer Anime-Stil.

Update-Log

(31.8.2025) NoobAI ep10 v0.273

Diese Version ist von Anfang an auf NoobAI eps v1.0 trainiert.

Im Vergleich zu vorheriger illus01 v1.198:

Bessere und ausgeglichene Helligkeit in extremen Bedingungen. (wie nbvp v0.271)

Bessere Texturen und Details. Hat mehr Trainingsschritte für hohe SNR-Timesteps. (illus01 Versionen übersprangen diese Timesteps für bessere Kompatibilität. Da jetzt alle Basismodelle NoobAI sind, ist das nicht mehr nötig.)

(24.8.2025) NoobAI v-pred v0.271:

Im Vergleich zu vorherigem v0.264:

Bessere und ausgewogene Beleuchtung in Extremsituationen, weniger Bias.

Hoher Kontrast, reines Schwarz 0 und Weiß 255 im selben Bild, sogar am selben Ort, ohne Überlaufen und Übersättigung. Jetzt kannst du alle gleichzeitig haben.

(Altes v0.264 versuchte das Bild zwischen 10~250 zu begrenzen, um Überlaufen zu verhindern, hatte aber noch sichtbare Bias-Probleme, insgesamt war das Bild vielleicht zu dunkel oder hell)

Wie v0.264, bevorzugt hohe oder volle Stärke (0,9~1).

(17.8.2025) NoobAI v-pred v0.264:

Erste Version, die auf NoobAI v-pred trainiert wurde.

Bietet bessere Beleuchtung, weniger Überlaufen.

Hinweis: Bevorzuge hohe oder volle Stärke (0,9~1).

(28.7.2025) illus01 v1.198

Hauptsächlich im Vergleich zu v1.185c:

Ende der "c" Version. Obwohl "visuell beeindruckend" gut ist, gab es Kompatibilitätsprobleme. Z.B. wenn dein Basismodell bereits Kontrastverbesserung hat. Zwei Kontrastverstärker übereinander sind sehr schlecht. Kein verrücktes Nachbearbeitungseffekt mehr (hoher Kontrast und Sättigung etc.).

Stattdessen mehr Texturen und Details. Kino-Beleuchtung. Bessere Kompatibilität.

Diese Version änderte vieles, inklusive Komplettüberarbeitung des Datensatzes, daher anders als vorherige Versionen.

Wer wieder v1.185c verrückte Effekte will: Reine und dedizierte Kunststile findest du auf dieser Seite. Wenn der Datensatz für ein LoRA groß genug ist, könnte ich eines trainieren.

(21.6.2025) illus01 v1.185c:

Im Vergleich zu v1.165c.

+100% Klarheit und Schärfe.

-30% Bilder, die zu chaotisch sind (nicht gut beschreibbar). Deshalb liefert diese Version keinen extrem hohen Kontrast mehr, ist aber stabiler für normale Anwendungsfälle.

(10.6.2025): illus01 v1.165c

Das ist eine Spezialversion. Kein Update von v1.164. "c" steht für "colorful", "creative", manchmal „chaotisch“.

Der Datensatz enthält sehr visuell beeindruckende Bilder, die aber manchmal schwer zu beschreiben sind: Sehr bunt. Hoher Kontrast. Komplexe Lichtverhältnisse. Objekte und Muster überall.

Du bekommst "visuell beeindruckend", aber auf Kosten von "natürlich". Auswirkungen auf weichfarbige Stile und so. Z.B. erzeugt diese Version keine "Bleistiftzeichnung"-Textur so perfekt wie v1.164.

(4.6.2025): illus01 v1.164

Besseres Prompt-Verständnis. Jedes Bild hat jetzt 3 natürliche Beschreibungen aus verschiedenen Perspektiven. Danbooru-Tags wurden vom LLM geprüft, nur wichtige Tags ausgewählt und in die natürliche Beschreibung integriert.

Anti-Überbelichtung. Bias hinzugefügt, um Ausgaben bei #ffffff reinem Weiß zu verhindern. Meist bedeutet #ffffff Überbelichtung, viele Details gehen verloren.

Trainingssettings angepasst, bessere Kompatibilität mit NoobAI e-pred und v-pred.

(19.5.2025): illus01 v1.152

Weitere Verbesserungen bei Beleuchtung, Texturen und Details.

5k mehr Bilder, mehr Trainingsschritte, stärkere Wirkung.

(9.5.2025): nbep11 v0.205:

Schnelle Korrektur bei Helligkeits- und Farbproblemen in v0.198. Jetzt sollten Helligkeit und Farben nicht mehr so stark variieren wie bei echten Fotos. v0.198 war nicht schlecht, nur zu kreativ.

(7.5.2025): nbep11 v0.198:

Mehr dunkle Bilder hinzugefügt. Weniger deformierte Körper und Hintergründe in dunkler Umgebung.

Farb- und Kontrast-Verbesserung entfernt, da nicht mehr nötig. Stattdessen Contrast Controller verwenden.

(25.4.2025): nbep11 v0.172.

Gleiches neues wie in illus01 v1.93 ~ v1.121. Zusammenfassung: Neuer Fotodatensatz "Touching Grass". Bessere natürliche Texturen, Hintergründe, Beleuchtung. Schwächere Charaktereffekte für bessere Kompatibilität.

Bessere Farbgenauigkeit und Stabilität. (gegenüber nbep11 v0.160)

(17.4.2025): illus01 v1.121.

Rollback auf illustrious v0.1. Von v1.0 und neuer wurden AI-Bilder absichtlich ins Training aufgenommen (ca. 30% des Datensatzes), was für LoRA-Training nicht ideal ist. Das fiel mir erst beim Lesen des Papers auf.

Geringerer Charaktersileneffekt, zurück auf v1.23 Niveau. Durch dieses LoRA erhalten Charaktere weniger Details, aber bessere Kompatibilität. Ein Kompromiss.

Andere Details wie unten (v1.113).

(10.4.2025): illus11 v1.113 ❌.

Update: Diese Version nur verwenden, wenn dein Basismodell auf Illustrious v1.1 basiert. Sonst illus01 v1.121 verwenden.

Trainiert auf Illustrious v1.1.

Neuer Datensatz "Touching Grass" hinzugefügt. Bessere natürliche Textur, Beleuchtung und Tiefenunschärfe. Stabilere Hintergrundstruktur. Weniger deformierte Hintergründe wie Räume, Gebäude.

Volle natürliche Sprachbeschreibungen vom LLM.

(30.3.2025): illus01 v1.93.

v1.72 war zu stark trainiert. Daher wurde die Gesamststärke reduziert. Bessere Kompatibilität.

(22.3.2025): nbep11 v0.160.

Dasselbe wie in illus v1.72.

(15.3.2025): illus01 v1.72

Dasselbe neue Textur- und Beleuchtungstraining wie im ani40z v0.4 unten. Mehr natürliche Beleuchtung und Texturen.

Kleiner ~100 Bilder umfassender Datensatz für Hände-Enhancement, speziell Hände in verschiedenen Aktionen wie Glas halten.

Alle "einfache Hintergrund"-Bilder entfernt (-200 Bilder).

Trainings-Tool von kohya auf onetrainer gewechselt. LoRA-Architektur auf DoRA geändert.

(4.3.2025) ani40z v0.4

Trainiert auf Animagine XL 4.0 ani40zero.

~1k Bilder hinzugefügt, Fokus auf natürliche dynamische Beleuchtung und reale Texturen.

Mehr natürliche Beleuchtung und Texturen.

ani04 v0.1

Initialversion für Animagine XL 4.0. Hauptsächlich um Animagine 4.0 Helligkeitsprobleme zu beheben. Bessere und höhere Kontraste.

illus01 v1.23

nbep11 v0.138

Einige Furry/nichtmenschliche/andere Bilder hinzugefügt, um den Datensatz auszugleichen.

nbep11 v0.129

schlechte Version, Wirkung zu schwach, einfach ignorieren

nbep11 v0.114

"Full Range Colors" implementiert. Das balanciert automatisch alles in Richtung "normal und ansehnlich". Denk daran wie den "Ein-Klick-Foto-Auto-Enhance"-Button der meisten Fotobearbeitungstools. Ein Nachteil: Hohe Bias wird verhindert. Z.B. willst du 95% vom Bild schwarz und 5% hell, statt 50/50.

Ein bisschen realistischere Daten hinzugefügt. Lebendigere Details, Beleuchtung, weniger flache Farben.

illus01 v1.7

nbep11 v0.96

Mehr Trainingsbilder.

Dann nochmal Feintuning mit kleinem "Wallpaper" Dataset (echte Spiel-Wallpaper, von bester Qualität, ca. 100 Bilder). Verbesserungen bei Details (besonders Haut, Haar) und Kontrast.

nbep11 v0.58

Mehr Bilder. Trainingsparameter so nah wie möglich am NoobAI Basismodell angepasst.

illus01 v1.3

nbep11 v0.30

Mehr Bilder.

nbep11 v0.11: Trainiert auf NoobAI epsilon pred v1.1.

Verbesserte Datensatz-Tags. Verbesserte LoRA-Struktur und Gewichtung. Stabiler, weniger Einfluss auf Bildkomposition.

illus01 v1.1

Trainiert auf illustriousXL v0.1.

nbep10 v0.10

Trainiert auf NoobAI epsilon pred v1.0.

Modell-Details

Diskussion

Bitte log in um einen Kommentar zu hinterlassen.

Modellsammlung - Stabilizer IL/NAI

Stabilizer IL/NAI - illus01 v1.23

Stabilizer IL/NAI - illus01 v1.121

Stabilizer IL/NAI - illus01 v1.185c

Stabilizer IL/NAI - nbep11 v0.138

Stabilizer IL/NAI - illus01 v1.152

Stabilizer IL/NAI - illus01 v1.165c

Stabilizer IL/NAI - nbep11 v0.205

Stabilizer IL/NAI - illus01 v1.72

Stabilizer IL/NAI - illus01 v1.198