Stabilizer IL/NAI - nbep11 v0.205

Verwandte Schlüsselwörter & Tags

Empfohlene Prompts

masterpiece

Empfohlene Parameter

samplers

steps

cfg

resolution

other models

Tipps

Lade dieses LoRA zuerst in deinem LoRA-Stack, um unerwartete Änderungen zu minimieren.

Verwende es als feinabgestimmtes Basismodell, indem du es mit voller Stärke auf ein vortrainiertes Basismodell lädst für beste natürliche Details und Stilkontrolle.

Bei Nutzung eines „illustrious“ Basismodells prüfe das zugrunde liegende vortrainierte Basismodell, um Qualitätsverluste zu vermeiden.

Dieses Modell kann keine natürlichen Details zu Basismodellen mit Überanpassung an AI-Stile hinzufügen.

Passe andere Gewichte bei Stapelung mehrerer LoRAs vorsichtig an, um keine unerwünschten Effekte zu erzeugen.

Hinterlasse Feedback im Kommentarbereich, damit es sichtbar ist, nicht im Civitai-Bewertungssystem.

Vermeide die Weitergabe von Merge-Dateien mit diesem Modell aufgrund eingebauter unsichtbarer Wasserzeichen-Trigger.

Ersteller-Sponsoren

Neueste Aktualisierung:

(07.09.2025) Du findest mich auf TensorArt.

Neueste Aktualisierung:

(07.09.2025) Du findest mich auf TensorArt.

Stabilizer

Dies ist mein feinabgestimmtes Basismodell, aber in Form eines LoRA.

Dieses feinabgestimmte Basismodell:

Fokussiert auf Kreativität, statt auf einen festen Stil. Der Datensatz ist sehr vielfältig. Daher hat dieses Modell keinen Standardstil (Bias), der seine Kreativität einschränkt.

Nur natürliche Texturen, Beleuchtung und feinste Details. Kein plastikartiger AI-Stil. (Gleiche AI-Gesichter, Frisuren, glatte Oberflächen ohne Textur usw.). Ich habe alle Bilder im Datensatz handverlesen. Null AI-Bilder im Datensatz.

Weniger verzerrte Bilder. Logischer. Besserer Hintergrund und Komposition.

Besseres Prompt-Verständnis. Trainiert mit natürlichsprachlichen Beschreibungen.

(v-pred) Bessere und ausgewogene Beleuchtung, hoher Kontrast. Reines Schwarz 0 und Weiß 255 können im selben Bild und sogar am selben Ort vorkommen, ohne Überlaufen und Übersättigung.

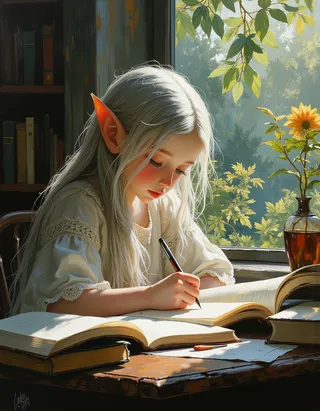

Coverbilder sind die Roh-Ausgaben in der Standardauflösung von 1MP. Kein Upscale, keine Plugins, keine Inpainting-Korrekturen. Enthalten Metadaten, 100 % reproduzierbar.

Die Stile in den Coverbildern stammen vom vortrainierten Basismodell, ausgelöst durch den Prompt. Sie sind nicht in meinem Datensatz enthalten. Du kannst sehen, dass das vortrainierte Modell diese Stile kennt, sie aber nicht richtig generieren kann, weil es auf Anime-Daten überangepasst ist. Dieses Modell behebt das Überanpassungsproblem. Siehe Abschnitt „Wie und warum es funktioniert“ weiter unten.

Warum kein Standardstil?

Was ist "Standardstil": Wenn ein Modell einen Standardstil (Bias) hat, bedeutet das, dass es unabhängig vom Prompt stets die gleichen Dinge (Gesichter, Hintergründe, Stimmungen) erzeugt, die den Standardstil ausmachen.

Vorteile: Es ist einfach zu nutzen, du musst den Stil nicht mehr angeben.

Nachteile: Du kannst den Standardstil aber auch nicht überschreiben. Wenn du etwas angibst, das nicht zum Standardstil passt, ignoriert das Modell es. Wenn du mehrere Stile kombiniert, überschreibt oder beeinträchtigt der Standardstil stets andere Stile.

„Kein Standardstil“ bedeutet keine Voreingenommenheit, und du musst den gewünschten Stil durch Tags oder LoRAs angeben. Dadurch gibt es keine Stilüberschneidungen oder -beeinträchtigungen durch dieses Modell. Du kannst genau den Stil erhalten, den du kombiniert hast.

Warum ist dieses "feinabgestimmte Basismodell" ein LoRA?

Ich bin kein Gigachad und habe keine Millionen Trainingsbilder. Die Feinabstimmung des gesamten Basismodells ist nicht nötig, ein LoRA reicht aus.

Ich spare enorm VRAM ein, sodass ich größere Batch-Größen verwenden kann.

Du musst nur eine kleine 40 MiB Datei herunterladen, statt eines 7 GiB schweren Checkpoints, was 99,4 % an Daten und Speicher spart.

Deshalb kann ich es häufig updaten.Dieses LoRA mag klein erscheinen, es ist trotzdem leistungsstark. Denn es nutzt eine neue Architektur namens DoRA von Nvidia, die effizienter ist als traditionelle LoRA.

Wie erhalte ich dieses "feinabgestimmte Basismodell"?

Ganz einfach.

Vortrainiertes Basismodell + Dieses LoRA = das "feinabgestimmte Basismodell"

Lade einfach dieses LoRA mit voller Stärke auf das vortrainierte Basismodell. Dann wird dieses vortrainierte Basismodell zum feinabgestimmten Basismodell. Siehe unten „Wie benutzen“.

Teilen von Merge-Dateien mit diesem Modell ist untersagt. Zur Info: Es sind versteckte Trigger-Wörter eingebaut, die ein unsichtbares Wasserzeichen erzeugen. Ich habe das Wasserzeichen und den Detektor selbst programmiert. Ich möchte es nicht einsetzen, kann es aber.

Dieses Modell wird nur auf Civitai und TensorArt veröffentlicht. Wenn du „mich“ und diesen Text auf anderen Plattformen siehst, sind das alles Fälschungen und die Plattform, die du nutzt, ist eine Piratenplattform.

Bitte hinterlasse Feedback im Kommentarfeld, damit es jeder sehen kann. Schreibe es nicht ins Civitai-Bewertungssystem, das ist so schlecht gestaltet, dass niemand die Bewertungen findet oder sieht.

Wie benutzen

Neueste Versionen:

nbvp10 v0.271 (trainiert auf NoobAI v-pred v1.0).

Exakte Farben und feinste Details. Das bisher beste Modell.

nbep10 v0.273 (trainiert auf NoobAI eps v1.0). Eingestellt.

Weniger Sättigung und Kontrast im Vergleich zu v-pred-Modellen. Aufgrund eines „kleinen Designfehlers“ bei der Standard-Epsilon (eps) Vorhersage. Sie begrenzt den Farbbereich. Deshalb gibt es später v-pred.

illus01 v1.198 (trainiert auf Illustrious v0.1). Eingestellt.

Einfach zu alt...

Hinweis: Lade dieses LoRA zuerst in deinem LoRA-Stack.

Dieses LoRA verwendet eine neue Architektur namens DoRA von Nvidia, die effizienter als traditionelle LoRA ist. Anders als traditionelle LoRA mit statischem Patch-Gewicht wird das Patch-Gewicht bei DoRA dynamisch basierend auf dem aktuell geladenen Basisgewicht berechnet (das sich ändert, wenn du LoRAs lädst). Um unerwartete Änderungen zu minimieren, lade dieses LoRA zuerst.

Zwei Möglichkeiten, dieses Modell zu verwenden:

1). Verwende es als feinabgestimmtes Basismodell (Empfohlen):

Wenn du die feinsten und natürlichsten Details sowie volle Stilkontrolle haben möchtest.

Lade dieses LoRA einfach zuerst mit voller Stärke auf das vortrainierte Basismodell. Dann wird das vortrainierte Basismodell zum feinabgestimmten Basismodell.

2). Nutze es als LoRA auf anderen feinabgestimmten Basismodellen.

Weil es eben ein LoRA ist.

Zu beachten:

Wichtig: Falls du ein "illustrious" Basismodell nutzt. Prüfe, auf welchem vortrainierten Basismodell es tatsächlich basiert. Die beliebtesten "illustrious" Anime-Basismodelle basieren oft auf (oder nahe bei) NoobAI, nicht illustrious. Mehr dazu in der Diskussion. Das LoRA muss mit dem vortrainierten Basismodell übereinstimmen. Mismatch verschlechtert die Bildqualität.

Du möchtest zwei Basismodelle mergen. Wenn dein Basismodell bereits einen starken Standardstil hat, fügt einfaches Zuschalten dieses LoRA nicht die erwartete Wirkung hinzu. Möglicherweise musst du andere Gewichte (LoRAs, U-net Blöcke usw.) anpassen.

Dieses Modell kann keine natürlichen Details zu Basismodellen mit AI-Stil hinzufügen (trainiert mit AI-Bildern, bei denen alles glatt, glänzend, ohne Textur, plastikartig wirkt). Manche wählen dieses Modell, um die Glätte des AI-Stils ihres Basismodells loszuwerden. Leider funktioniert das nicht, denn der AI-Stil ist extrem überangepasst (du kannst sofort sehen, was du getan hast, genauso wie das AI-Modell, wenn es mit AI-Bildern trainiert wird). Da AI-Bilder weniger Details als reale Bilder haben, lernt das Modell auch, Details zu unterdrücken. Das ist problematisch. Einmal AI-Stil drin, ist er nicht mehr loszuwerden.

Dieses Modell ist kein magisches Tool, das dir gestattet, mehr LoRAs ohne Probleme zu stapeln. Der Name kann irreführend sein.

Warum und wie das funktioniert:

Das Problem der Überanpassung (Overfitting):

Anime-Modelle wurden auf Anime-Bildern trainiert. Anime-Bilder sind einfach und enthalten nur abstrakte, hohe "Konzepte". Keine Hintergründe, Details oder Texturen.

Wir wollen, dass das Modell nur die hohen "Konzepte" lernt. Tatsächlich lernt das Modell aber, was es sieht, nicht was du willst.

Nach 10+ Millionen einfachen abstrakten Anime-Bildern lernt das Modell: 1) Es muss keine Details generieren, da es das nie gezeigt bekam. 2) Stattdessen muss es einfache Bilder mit abstrakten Konzepten generieren, auch ohne Verständnis. Das führt zu verzerrten Bildern, also Überanpassung.

Die Lösung:

Trainiere das Modell mit Anime- und Realwelt-Bildern. So lernt es Konzepte und behält natürliche Details und Texturen, also weniger Overfitting.

NoobAI machte das durch Mischung einiger Real-Cosplay-Bilder im Datensatz (soweit ich mich erinnere, wurde das von den Entwicklern erwähnt).

Dieses Modell geht weiter, trainiert auf „ein bisschen von allem“: Architektur, Alltagsgegenstände, Kleidung, Landschaften ... Auch mit vollen, mehrstufigen natürlichsprachlichen Beschreibungen, um das ursprüngliche SDXL-Training zu imitieren.

Das Resultat:

Siehe Vergleich ohne: 1 (Künstlerstile), 2 (generelle Stile)

Weniger Überanpassung, weniger verzerrte Bilder. Natürlichere Texturen, Beleuchtung und Details. Jetzt kannst du tausende eingebaute Stil-Tags (Danbooru, e621) sowie allgemeine Styles, die SDXL versteht, verwenden und erhältst ein sauberes, detailliertes Bild – egal ob 2D, 3D, abstrakt oder realistisch.

Maximale Kreativität durch den vielfältigen Datensatz. Kein Standardstil. Es limitiert weder das vortrainierte Modell noch andere Stil-LoRAs in ihrer Kreativität.

Datensatz

Neueste oder aktuelle Versionen

~7k Bilder insgesamt. Nicht riesig (im Vergleich zu Gigachads mit Millionen Bildern), aber auch nicht klein. Und jedes Bild ist von mir handverlesen.

Nur normale, gut aussehende Dinge. Kein verrückter Kunststil, der sich nicht beschreiben lässt. Keine AI-Bilder, keine Wasserzeichen etc.

Nur hochauflösende Bilder. Durchschnittlich 3,37MP, ~1800x1800 Pixel.

Alle Bilder haben natürliche Beschreibungen vom neuesten Google LLM.

Alle Anime-Charaktere werden zuerst vom wd tagger v3, dann vom Google LLM getaggt.

Enthält Natur, Außenbereich, Innenräume, Tiere, Alltagsgegenstände, vieles, außer echte Menschen.

Alle Helligkeitsbedingungen sind abgedeckt. Sehr dunkel, sehr hell, sehr dunkel und sehr hell zugleich.

Andere Werkzeuge

Einige Ideen, die Teil des Stabilizers werden sollten oder waren, sind jetzt getrennte LoRAs für mehr Flexibilität. Sammlung: https://civitai.com/collections/8274233.

Dark: Ein LoRA, der auf dunklere Umgebungen ausgerichtet ist. Hilfreich, um die Helligkeitsvoreingenommenheit mancher Basismodelle zu korrigieren. Trainiert auf Bildern mit geringer Helligkeit. Kein Stil-Bias, also keine Stilverschmutzung.

Contrast Controller: Handgefertigtes LoRA. Steuert den Kontrast wie ein Regler am Monitor. Anders als andere "Kontrastverstärker" ist die Wirkung stabil, mathematisch linear und hat keine Nebenwirkungen auf den Stil.

Hilfreich, wenn dein Basismodell Übersättigung hat oder du etwas sehr farbenfrohes möchtest.

Beispiel:

Style Strength Controller: Oder Überanpassung-Effekt-Reduzierer. Kann alle Arten von Überanpassung (Bias bei Objekten, Helligkeit usw.) mathematisch reduzieren. Oder verstärken, wenn gewünscht.

Unterschiede zum Stabilizer:

Unterschiede zum Stabilizer:

Stabilizer wurde mit Realwelt-Daten trainiert. Es „reduziert“ Überanpassung bei Texturen, Details und Hintergründen, indem es diese zurückgibt.

Style Controller ist kein Training, sondern ähnelt einem „Undo“ des Trainings für das Basismodell, um es weniger überangepasst zu machen. Kann Überanpassungen bei Helligkeit, Objekten mathematisch reduzieren.

Alte Versionen:

Weitere Infos findest du im „Update-Log“. Beachte, dass alte Versionen sehr unterschiedliche Effekte haben können.

Hauptzeitstrahl:

Jetzt ~: Natürliche Details und Texturen, stabiles Prompt-Verständnis und mehr Kreativität. Nicht mehr auf reinen 2D-Anime-Stil beschränkt.

illus01 v1.23 / nbep11 0.138 ~: Besserer Anime-Stil mit lebendigen Farben.

illus01 v1.3 / nbep11 0.58 ~: Besserer Anime-Stil.

Update-Log

(31.08.2025) NoobAI ep10 v0.273

Diese Version wurde von Anfang an auf NoobAI eps v1.0 trainiert.

Im Vergleich zu vorherigem illus01 v1.198:

Bessere und ausgewogene Helligkeit bei extremen Bedingungen (wie nbvp v0.271).

Bessere Texturen und Details. Mehr Training auf hohen SNR-Timesteps (illus01-Versionen übersprangen diese für bessere Kompatibilität. Jetzt keine Notwendigkeit, da alle Basismodelle NoobAI sind).

(24.08.2025) NoobAI v-pred v0.271:

Im Vergleich zu vorherigem v0.264:

Bessere und ausgewogene Beleuchtung in Extremsituationen, weniger Bias.

Hoher Kontrast, reines Schwarz 0 und Weiß 255 im selben Bild und Ort, kein Überlaufen und Übersättigung. Jetzt alles gleichzeitig möglich.

(Altes v0.264 versuchte, die Werte zwischen 10~250 zu begrenzen, um Überlaufen zu vermeiden, hatte dennoch Bias-Probleme, Bild war oft zu dunkel oder hell.)

Wie v0.264, bevorzugt hohe oder volle Stärke (0.9~1).

(17.08.2025) NoobAI v-pred v0.264:

Erste Version auf NoobAI v-pred trainiert.

Bessere Beleuchtung, weniger Überlaufen.

Hinweis: bevorzugt hohe oder volle Stärke (0.9~1).

(28.07.2025) illus01 v1.198

Verglichen mit v1.185c:

Ende der "c"-Version. Visuell beeindruckend, aber Kompatibilitätsprobleme (z.B. bei schon vorhandenem Kontrast-Enhancement). Zwei Kontrastverstärker stapeln sich schlecht. Also keine verrückten Posteffekte mehr (hoher Kontrast & Sättigung usw.).

Dafür mehr Texturen und Details. Kino-ähnliche Beleuchtung. Bessere Kompatibilität.

Die Version hat viele Änderungen, inkl. Datensatz-Überarbeitung, daher wirkt sie anders als vorherige.

Wer die verrückten Effekte von v1.185c zurückhaben will, findet reine Kunststile auf dieser Seite. Wenn der Datensatz groß genug für ein LoRA ist, könnte ich eines trainieren.

(21.06.2025) illus01 v1.185c:

Verglichen mit v1.165c:

+100 % Klarheit und Schärfe.

-30 % chaotische Bilder (schwer beschreibbar). Daher liefert diese Version keinen extrem hohen Kontrastlevel mehr, ist aber stabiler im Normalbetrieb.

(10.06.2025): illus01 v1.165c

Eine spezielle Version. Kein Update von v1.164. "c" steht für "colorful", "creative", manchmal "chaotic".

Der Datensatz enthält visuell auffällige, aber teilweise schwer beschreibbare Bilder. Z.B. sehr farbintensiv, hoher Kontrast, komplexe Lichtbedingungen, viele Objekte und Muster.

Du bekommst also "auffällig", aber auf Kosten von "natürlich". Betroffen sind z.B. Stile mit weichen Farben. Zum Beispiel kann diese Version keine „Bleistiftgrafik“-Textur wie v1.164 perfekt erzeugen.

(04.06.2025): illus01 v1.164

Besseres Prompt-Verständnis. Jedes Bild hat jetzt 3 natürliche Beschreibungen aus unterschiedlichen Perspektiven. Danbooru-Tags werden vom LLM geprüft, nur wichtige Tags werden in die natürliche Beschreibung integriert.

Anti-Überbelichtung. Hinzugefügt wurde ein Bias, der verhindert, dass Modell-Ausgaben #ffffff (reines Weiß) erreichen. Meist bedeutet #ffffff Überbelichtung und Detailverlust.

Änderung einiger Trainingsparameter für bessere Kompatibilität mit NoobAI, sowohl e-pred als auch v-pred.

(19.05.2025): illus01 v1.152

Weiter verbesserte Beleuchtung, Texturen und Details.

5.000 zusätzliche Bilder, mehr Trainingsschritte, daher stärkere Wirkung.

(09.05.2025): nbep11 v0.205:

Kurze Korrektur von Helligkeits- und Farbproblemen aus v0.198. Nun ändert sich Helligkeit und Farbe nicht mehr dramatisch wie bei einem echten Foto. v0.198 war nicht schlecht, nur zu kreativ.

(07.05.2025): nbep11 v0.198:

Mehr dunkle Bilder. Weniger verzerrte Körper und Hintergründe in dunkler Umgebung.

Farb- und Kontrastverbesserung entfernt. Nicht mehr nötig. Nutze stattdessen den Contrast Controller.

(25.04.2025): nbep11 v0.172.

Die gleichen Neuerungen wie in illus01 v1.93 ~ v1.121. Zusammenfassung: Neuer Fotodatensatz "Touching Grass". Bessere natürliche Textur, Hintergrund, Beleuchtung. Weniger starke Charakterwirkungen für bessere Kompatibilität.

Bessere Farbgenauigkeit und Stabilität (im Vergleich zu nbep11 v0.160).

(17.04.2025): illus01 v1.121.

Zurückgesetzt auf illustrious v0.1. illustrious v1.0 und neuer trainierten absichtlich mit AI-Bildern (vermutlich 30 % des Datensatzes), was für LoRA-Training nicht ideal ist. Habe ich erst nach Lesen des Papers bemerkt.

Weniger Charakterstil-Effekt. Zurück auf v1.23-Niveau. Charaktere haben weniger Details durch dieses LoRA, aber bessere Kompatibilität. Ein Kompromiss.

Sonst gleich wie unten (v1.113).

(10.04.2025): illus11 v1.113 ❌.

Update: Nutze diese Version nur, wenn dein Basismodell auf Illustrious v1.1 basiert. Ansonsten illus01 v1.121 verwenden.

Trainiert auf Illustrious v1.1.

Neuer Datensatz "Touching Grass" hinzugefügt. Bessere natürliche Textur, Beleuchtung und Tiefenschärfe. Bessere strukturelle Stabilität des Hintergrunds. Weniger verzerrte Hintergründe wie deformierte Räume oder Gebäude.

Vollständige natürlichsprachliche Beschreibungen vom LLM.

(30.03.2025): illus01 v1.93.

v1.72 wurde zu stark trainiert. Habe die Gesamteffektstärke reduziert. Sollte bessere Kompatibilität bringen.

(22.03.2025): nbep11 v0.160.

Die gleichen Verbesserungen wie illus v1.72.

(15.03.2025): illus01 v1.72

Wie bereits erwähnt, neuer Textur- und Beleuchtungsdatensatz im unteren Abschnitt ani40z v0.4. Natürlichere Beleuchtung und Texturen.

Kleiner zusätzlicher Hand-Datensatz von ca. 100 Bildern für Hand-Verbesserung, z.B. Hände, die ein Glas oder einen Becher halten.

Alle „einfachen Hintergrund“-Bilder aus dem Datensatz entfernt. -200 Bilder.

Trainingswerkzeug von kohya auf onetrainer gewechselt. LoRA-Architektur auf DoRA geändert.

(04.03.2025) ani40z v0.4

Trainiert auf Animagine XL 4.0 ani40zero.

~1.000 Bilder zugefügt, Fokus auf natürliche dynamische Beleuchtung und reale Textur.

Mehr natürliche Beleuchtung und Texturen.

ani04 v0.1

Startversion für Animagine XL 4.0. Hauptsächlich zur Behebung von Helligkeitsproblemen in Animagine 4.0. Besserer und höherer Kontrast.

illus01 v1.23

nbep11 v0.138

Einige furry/nicht-menschliche/andere Bilder hinzugefügt, um den Datensatz auszubalancieren.

nbep11 v0.129

Schlechte Version, Effekt zu schwach, einfach ignorieren.

nbep11 v0.114

„Vollfarbenspektrum“ implementiert. Balanciert automatisch die Dinge in Richtung „normal und gut aussehend“. Das ist wie der „Ein-Klick-Foto-Autoverbesserer“ in den meisten Bildbearbeitungsprogrammen. Nachteil: Es verhindert starke Bias. Z.B. wenn 95 % des Bildes schwarz und 5 % hell sein sollen statt 50/50 %.

Ein bisschen realistischere Daten hinzugefügt. Lebendigere Details, Beleuchtung, weniger flache Farben.

illus01 v1.7

nbep11 v0.96

Mehr Trainingsbilder.

Dann nochmal feinabgestimmt mit kleinem „Wallpaper“-Datensatz (echte Spiel-Wallpaper, beste Qualität, ca. 100 Bilder). Mehr Details (sichtbar an Haut, Haaren) und mehr Kontrast.

nbep11 v0.58

Mehr Bilder. Trainingsparameter näher an NoobAI Basismodell angepasst.

illus01 v1.3

nbep11 v0.30

Mehr Bilder.

nbep11 v0.11: Trainiert auf NoobAI epsilon pred v1.1.

Verbesserte Datensatz-Tags. Verbesserte LoRA-Struktur und Gewichtsverteilung. Stabiler und weniger Einfluss auf Bildkomposition.

illus01 v1.1

Trainiert auf illustriousXL v0.1.

nbep10 v0.10

Trainiert auf NoobAI epsilon pred v1.0.

Modell-Details

Diskussion

Bitte log in um einen Kommentar zu hinterlassen.

Modellsammlung - Stabilizer IL/NAI

Stabilizer IL/NAI - illus01 v1.23

Stabilizer IL/NAI - illus01 v1.121

Stabilizer IL/NAI - illus01 v1.185c

Stabilizer IL/NAI - nbep11 v0.138

Stabilizer IL/NAI - illus01 v1.152

Stabilizer IL/NAI - illus01 v1.165c

Stabilizer IL/NAI - nbep11 v0.205

Stabilizer IL/NAI - illus01 v1.72

Stabilizer IL/NAI - illus01 v1.198