Stabilizer IL/NAI - nbep11 v0.205

Palabras Clave y Etiquetas Relacionadas

Prompts Recomendados

masterpiece

Parámetros Recomendados

samplers

steps

cfg

resolution

other models

Consejos

Carga esta LoRA primero en tu pila de LoRAs para minimizar cambios inesperados.

Úsalo como modelo base afinado cargándolo sobre un modelo base preentrenado con fuerza completa para obtener los mejores detalles naturales y control de estilo.

Si usas un modelo base "illustrious", verifica su modelo base preentrenado para evitar degradación de calidad.

Este modelo no puede añadir detalles naturales a modelos base con sobreajuste de estilo IA.

Ajusta otros pesos cuidadosamente al apilar múltiples LoRAs para evitar romper los resultados.

Deja retroalimentación en la sección de comentarios para mayor visibilidad, no en el sistema de reseñas de Civitai.

Evita compartir merges usando este modelo debido a disparadores de marca de agua invisible incorporados.

Patrocinadores del Creador

Última actualización:

(7/9/2025) Puedes encontrarme en TensorArt.

Última actualización:

(7/9/2025) Puedes encontrarme en TensorArt.

Stabilizer

Este es mi modelo base afinado, pero en forma de LoRA.

Este modelo base afinado:

Se enfoca en la creatividad, en lugar de en un estilo fijo. El conjunto de datos es muy diverso. Así que este modelo no tiene un estilo por defecto (sesgo) que limite su creatividad.

Sólo texturas naturales, iluminación y los detalles más finos. No estilo de IA plástico. (Mismas caras de IA, estilos de cabello, superficies lisas sin textura, etc.). Seleccioné cuidadosamente cada imagen del conjunto de datos. Cero imágenes generadas por IA en el conjunto.

Menos imágenes deformadas. Más lógico. Mejor fondo y composición.

Mejor comprensión del prompt. Entrenado con descripciones en lenguaje natural.

(v-pred) Mejor iluminación balanceada y alto contraste. Negro puro 0 y blanco 255 pueden estar en la misma imagen, incluso en el mismo lugar, pero sin desbordamiento ni sobresaturación.

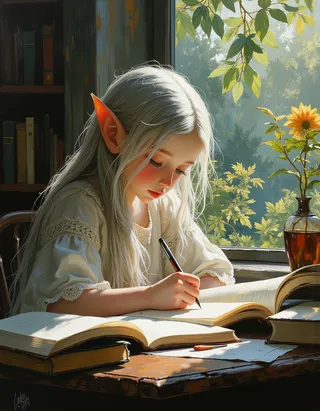

Las imágenes de portada son las salidas en crudo, a resolución predeterminada de 1MP. Sin ampliación, sin plugins, sin correcciones mediante repintado. Incluyen metadatos, 100% reproducibles.

Los estilos en las imágenes de portada provienen del modelo base preentrenado, activados mediante el prompt. No están en mi conjunto de datos. Puedes ver que el modelo preentrenado conoce esos estilos, pero no puede generarlos adecuadamente porque está sobreajustado a datos de anime. Este modelo arregla ese problema de sobreajuste. Ver sección "cómo y por qué funciona" abajo.

¿Por qué no hay estilo por defecto?

¿Qué es "estilo por defecto"?: Si un modelo tiene un estilo por defecto (sesgo), significa que no importa lo que uses en el prompt, el modelo debe generar las mismas cosas (caras, fondos, sensaciones) que forman ese estilo por defecto.

Pros: Es fácil de usar, ya no tendrás que especificar estilo en el prompt.

Contras: Pero tampoco puedes anularlo. Si pones algo que no encaja con el estilo por defecto, el modelo simplemente lo ignorará. Si combinas más estilos, el estilo por defecto siempre se superpondrá/contaminará/limitará a otros estilos.

"Sin estilo por defecto" significa sin sesgo, y necesitas especificar el estilo que quieres, mediante etiquetas o LoRAs. Pero no habrá superposición ni contaminación de estilo de este modelo. Obtendrás el estilo que combines exactamente como debe ser.

¿Por qué este "modelo base afinado" es una LoRA?

No soy un gigachad y no tengo millones de imágenes para entrenamiento. Afinar todo el modelo base no es necesario, una LoRA es suficiente.

Puedo ahorrar mucho VRAM y usar tamaños de lote más grandes.

Solo necesito subir, y tú solo necesitas descargar, un archivo pequeño de 40MiB, en lugar de un checkpoint grande de 7GiB, lo que ahorra 99.4% en datos y almacenamiento.

Así puedo actualizarlo frecuentemente.Esta LoRA puede parecer pequeña, pero es poderosa. Porque usa una arquitectura nueva llamada DoRA de Nvidia, que es más eficiente que la LoRA tradicional.

Entonces, ¿cómo obtengo este "modelo base afinado"?

Sencillo.

modelo base preentrenado + esta LoRA = el "modelo base afinado"

Solo carga esta LoRA sobre el modelo base preentrenado con fuerza completa. Entonces el modelo base preentrenado se convertirá en el modelo base afinado. Ver "Cómo usar" abajo.

Está prohibido compartir merges usando este modelo. Para tu información, hay palabras clave ocultas para imprimir marcas de agua invisibles. Yo mismo codifiqué la marca de agua y el detector. No quiero usarlo, pero puedo.

Este modelo solo está publicado en Civitai y TensorArt. Si ves "a mí" y esta frase en otras plataformas, todas son falsas y la plataforma que usas es pirata.

Por favor, deja comentarios en la sección de comentarios para que todos los vean. No escribas comentarios en el sistema de reseñas de Civitai, está tan mal diseñado que nadie puede encontrar ni ver las reseñas.

Cómo usar

Versiones más recientes:

nbvp10 v0.271 (entrenado en NoobAI v-pred v1.0).

Colores precisos y detalles finos. Este es el mejor modelo hasta ahora.

nbep10 v0.273 (entrenado en NoobAI eps v1.0). Descontinuado.

Menos saturación y contraste comparado con modelos v-pred. Debido a un "pequeño fallo de diseño" en la predicción estándar epsilon (eps). Limita el rango de color alcanzable por el modelo. Por eso tenemos v-pred luego.

illus01 v1.198 (entrenado en Illustrious v0.1). Descontinuado.

Simplemente muy antiguo...

Nota: carga esta LoRA primero en tu pila de LoRAs.

Esta LoRA usa una nueva arquitectura llamada DoRA de Nvidia, que es más eficiente que la LoRA tradicional. Sin embargo, a diferencia de la LoRA tradicional que tiene un peso estático, el peso del parche de DoRA se calcula dinámicamente basado en el peso del modelo base cargado actualmente (que cambia cuando cargas LoRAs). Para minimizar cambios inesperados, carga esta LoRA primero.

Dos formas de usar este modelo:

1). Úsalo como modelo base afinado (Recomendado):

Si quieres los detalles y texturas naturales más finos y construir la combinación de estilos que deseas, con control total.

Sólo carga esta LoRA primero sobre el modelo base preentrenado con fuerza completa. Entonces el modelo base preentrenado se convertirá en el modelo base afinado.

2). Úsalo como LoRA sobre otro modelo base afinado.

Porque ¿por qué no? Al fin y al cabo es una LoRA.

Cosas a tener en cuenta:

Importante: Si usas un modelo base "illustrious". Debes verificar en qué modelo base preentrenado está basado realmente tu modelo base. Y los modelos base "illustrious" de anime más populares están basados (o cerca) en NoobAI, no en illustrious. Lee más (por qué esos modelos base están mal etiquetados y cómo probar tu modelo base) en "Discusión". La LoRA debe coincidir con el modelo base preentrenado. Un modelo base incorrecto degrada la calidad de imagen.

Vas a fusionar dos modelos base. Si tu modelo base ya tiene un estilo por defecto muy fuerte, simplemente añadir esta LoRA usualmente no te dará lo que esperas. Puede que necesites balancear otros pesos (LoRAs, bloques U-net, etc.).

Este modelo no puede añadir detalles naturales a modelos base con estilos IA (entrenados con imágenes AI, donde todo se siente liso, brillante, sin textura y parece plástico). Sé que algunos eligen este modelo para deshacerse de la suavidad del estilo IA en su modelo base actual. Desafortunadamente no funcionará, porque el estilo IA está extremadamente sobreajustado (puedes aprender al instante lo que acabas de hacer, igual que el modelo IA si lo entrenas con imágenes AI). Y porque las imágenes AI carecen de detalles comparado con imágenes reales, el modelo también aprendió a suprimir detalles. Lo cual es realmente problemático. Una vez que el estilo IA está presente, no puedes deshacerte de él.

Este modelo no es una herramienta mágica que te permite apilar más LoRAs sobre un modelo base sin romperlo. Sé que el nombre del modelo puede ser confuso.

Por qué y cómo funciona:

El problema del sobreajuste:

Los modelos de anime se entrenan con imágenes de anime. Las imágenes de anime son simples y sólo contienen "conceptos" de alto nivel, a menudo muy abstractos. No tienen fondos, detalles ni texturas.

Queremos que el modelo aprenda sólo los "conceptos" de alto nivel. La realidad es que el modelo aprende lo que ve, no lo que quieres.

Después de ver más de 10 millones de imágenes abstractas simples de anime, el modelo aprenderá que 1) no necesita generar detalles porque nunca se le dijo que los generara; 2) en cambio, debe generar imágenes simples con conceptos abstractos aunque no los comprenda. Esto lleva a imágenes deformadas, es decir, "sobreajuste".

La solución:

Entrenar el modelo con imágenes de anime y del mundo real. Así puede aprender conceptos mientras mantiene detalles y texturas naturales, es decir, menos sobreajuste.

NoobAI hizo esto mezclando algunas imágenes reales de cosplay en su conjunto de datos. (si no recuerdo mal, sus desarrolladores lo mencionaron en algún lugar)

Este modelo va más allá, se entrenó con un poco de todo: arquitectura, objetos cotidianos, ropa, paisajes... También con descripciones en lenguaje natural a varios niveles, para imitar la configuración original de entrenamiento de SDXL.

El resultado:

Ver comparaciones sin (w/o): 1 (estilos de artistas), 2 (estilos generales)

Menos sobreajuste, menos imágenes deformadas. Más texturas, iluminaciones y detalles naturales. Ahora puedes usar miles de etiquetas de estilos incorporadas (etiquetas Danbooru, e621), así como estilos generales que el SDXL original comprende, y obtener una imagen limpia y detallada como debe ser, ya sea 2D, 3D, abstracta o realista.

Creatividad máxima. Debido a la diversidad del conjunto de datos. No hay un estilo por defecto, por lo que no limita la creatividad del modelo preentrenado ni de otras LoRAs de estilo.

Conjunto de datos

última versión o versiones recientes

~7k imágenes en total. No es muy grande (comparado con gigachads que entrenan con millones de imágenes), pero no es pequeño. Y cada imagen fue seleccionada por mí.

Sólo cosas normales y bonitas. Sin estilos de arte locos que no se puedan describir. Sin imágenes AI, sin marcas de agua, etc.

Sólo imágenes en alta resolución. El promedio de píxeles del conjunto es 3.37 MP, ~1800x1800.

Todas las imágenes tienen descripciones naturales generadas por el último LLM de Google.

Todos los personajes de anime están etiquetados primero por wd tagger v3 y luego por LLM de Google.

Contiene naturaleza, exteriores, interiores, animales, objetos diarios, muchas cosas, excepto humanos reales.

Contiene todo tipo de condiciones de brillo. Muy oscuro, muy brillante, muy oscuro y muy brillante.

Otras herramientas

Algunas ideas que iban a ser, o solían ser, parte de Stabilizer. Ahora son LoRAs separadas para mayor flexibilidad. Enlace a la colección: https://civitai.com/collections/8274233.

Dark: Una LoRA sesgada a entornos más oscuros. Útil para corregir el sesgo de brillo en algunos modelos base. Entrenado con imágenes de baja luminosidad. Sin sesgo de estilo, por lo que sin contaminación de estilo.

Contrast Controller: Una LoRA hecha a mano. Controla el contraste como si usaras un deslizador en tu monitor. A diferencia de otros "mejoradores de contraste" entrenados, el efecto de esta LoRA es estable, matemáticamente lineal y sin efectos secundarios sobre el estilo.

Útil cuando tu modelo base tiene problemas de sobresaturación o quieres algo realmente colorido.

Ejemplo:

Style Strength Controller: O reductor de efecto de sobreajuste. Puede reducir todo tipo de efectos de sobreajuste (sesgo en objetos, brillo, etc.), matemáticamente. O amplificarlo, si quieres.

Diferencias con Stabilizer:

Diferencias con Stabilizer:

Stabilizer fue entrenado con datos del mundo real. Sólo puede "reducir" efectos de sobreajuste en texturas, detalles y fondos, añadiéndolos de nuevo.

Style Controller no viene del entrenamiento. Más bien "deshace" el entrenamiento para el modelo base, para hacerlo menos sobreajustado. Puede reducir matemáticamente todo tipo de efectos de sobreajuste, como sesgo en brillo, objetos.

Versiones antiguas:

Puedes encontrar más información en "Registro de actualizaciones". Ten en cuenta que las versiones antiguas pueden tener efectos muy diferentes.

Línea principal de tiempo:

Ahora ~: Detalles y texturas naturales, comprensión estable del prompt y más creatividad. Ya no limitado al estilo puro de anime 2D.

illus01 v1.23 / nbep11 0.138 ~: Mejor estilo anime con colores vivos.

illus01 v1.3 / nbep11 0.58 ~: Mejor estilo anime.

Registro de actualizaciones

(31/8/2025) NoobAI ep10 v0.273

Esta versión se entrenó desde el principio en NoobAI eps v1.0.

Comparado con la anterior illus01 v1.198:

Mejor brillo y balance en condiciones extremas. (igual que nbvp v0.271)

Mejores texturas y detalles. Tiene más pasos de entrenamiento en timesteps con alta SNR. (las versiones illus01 omitían esos timesteps para mejor compatibilidad. Ahora todos los modelos base son NoobAI, no es necesario omitirlos.)

(24/8/2025) NoobAI v-pred v0.271:

Comparado con la anterior v0.264:

Mejor iluminación balanceada en condiciones extremas, menos sesgo.

Alto contraste, negro puro 0 y blanco 255 en la misma imagen, incluso en el mismo lugar, sin desbordamiento ni sobresaturación. Ahora puedes tenerlos todos a la vez.

(la antigua v0.264 intentaba limitar la imagen entre 10~250 para evitar desbordamiento, y aún así tenía problemas de sesgo, la imagen podría ser demasiado oscura o clara)

Como en v0.264, se prefiere fuerza alta o completa (0.9~1).

(17/8/2025) NoobAI v-pred v0.264:

Primera versión entrenada en NoobAI v-pred.

Ofrece mejor iluminación, menos desbordamiento.

Nota: se prefiere fuerza alta o completa (0.9~1).

(28/7/2025) illus01 v1.198

Comparado principalmente con v1.185c:

Fin de la versión "c". Aunque "visualmente impactante" es bueno, tenía problemas de compatibilidad. Por ejemplo, si tu modelo base ya tiene mejora de contraste similar. Apilar dos mejoras de contraste es muy malo. Así que, no más efectos locos de postprocesado (alto contraste y saturación, etc.).

En cambio, más texturas y detalles. Iluminación cinematográfica. Mejor compatibilidad.

Esta versión cambió muchas cosas, incluido el conjunto de datos, así que el efecto es bastante diferente a versiones anteriores.

Para quienes quieran los efectos locos de v1.185c. Puedes encontrar estilos de arte puros y dedicados en esta página. Si el conjunto de datos es lo suficientemente grande para un LoRA, puedo entrenar uno.

(21/6/2025) illus01 v1.185c:

Comparado con v1.165c.

+100% nitidez y claridad.

-30% imágenes demasiado caóticas (difíciles de describir). Por lo que esta versión no ofrece niveles locos de alto contraste, pero es más estable en casos normales.

(10/6/2025): illus01 v1.165c

Esta es una versión especial. No es una mejora de v1.164. La "c" significa "colorido", "creativo" y a veces "caótico".

El conjunto de datos contiene imágenes muy visualmente impactantes, pero a veces difíciles de describir, p. ej.: muy coloridas, alto contraste, iluminación compleja, objetos y patrones complejos por doquier.

Así que obtendrás imágenes "visualmente impactantes" pero a costa de naturalidad. Puede afectar estilos que tienen colores suaves, etc. Por ejemplo, esta versión no puede generar textura de "arte a lápiz" perfectamente como v1.164.

(4/6/2025): illus01 v1.164

Mejor comprensión del prompt. Ahora cada imagen tiene 3 descripciones naturales desde distintas perspectivas. Las etiquetas Danbooru se verifican con LLM, solo se seleccionan las importantes y se fusionan en la descripción natural.

Anti-sobreexposición. Se añadió un sesgo para evitar que el output alcance el blanco puro #ffffff. La mayoría de veces #ffffff significa sobreexposición, que pierde muchos detalles.

Cambios en configuraciones de entrenamiento. Más compatible con NoobAI, tanto e-pred como v-pred.

(19/5/2025): illus01 v1.152

Mejorando continuamente la iluminación, texturas y detalles.

5K imágenes adicionales, más pasos de entrenamiento, resultado: efecto más fuerte.

(9/5/2025): nbep11 v0.205:

Corrección rápida de brillo y color en v0.198. Ahora no debería cambiar brillo y colores tan drásticamente como una foto real. v0.198 no era malo, solo muy creativo, pero demasiado creativo.

(7/5/2025): nbep11 v0.198:

Más imágenes oscuras. Menos deformación del cuerpo y fondo en entornos oscuros.

Eliminada mejora de color y contraste. Ya no es necesaria. Usa Contrast Controller en su lugar.

(25/4/2025): nbep11 v0.172.

Mismas novedades en illus01 v1.93 ~ v1.121. Resumen: nuevo conjunto de fotografías "Touching Grass". Mejor textura natural, fondo e iluminación. Menor efecto en personajes para mejor compatibilidad.

Mejor precisión y estabilidad del color. (Comparado con nbep11 v0.160)

(17/4/2025): illus01 v1.121.

Revertido a illustrious v0.1. illustrious v1.0 y versiones posteriores fueron entrenadas a propósito con imágenes AI (quizá 30% del conjunto). Lo cual no es ideal para entrenar LoRA. No me di cuenta hasta leer su paper.

Menor efecto de estilo en personajes. Vuelto al nivel v1.23. Los personajes tendrán menos detalles con esta LoRA, pero mejor compatibilidad. Es un compromiso.

Otros cambios iguales a la versión v1.113 abajo.

(10/4/2025): illus11 v1.113 ❌.

Actualización: usa esta versión solo si sabes que tu modelo base se basa en Illustrious v1.1. Si no, usa illus01 v1.121.

Entrenado en Illustrious v1.1.

Se añadió nuevo conjunto "Touching Grass". Mejor textura natural, iluminación y efecto de profundidad de campo. Mejor estabilidad estructural del fondo. Menos deformación del fondo, como habitaciones o edificios deformados.

Descripciones completas en lenguaje natural por LLM.

(30/3/2025): illus01 v1.93.

v1.72 fue entrenada demasiado intensamente. Así que reduje su fuerza general. Debe tener mejor compatibilidad.

(22/3/2025): nbep11 v0.160.

Mismas características que illus v1.72.

(15/3/2025): illus01 v1.72

Mismo nuevo conjunto de texturas e iluminación que se menciona en ani40z v0.4 abajo. Más iluminación natural y texturas naturales.

Añadido un pequeño conjunto de ~100 imágenes centrado en mejora de manos, enfocándose en una o varias manos con diferentes tareas, como sostener un vaso o taza.

Eliminadas todas las imágenes de "fondo simple" del conjunto. -200 imágenes.

Cambiada la herramienta de entrenamiento de kohya a onetrainer. Cambiada la arquitectura de LoRA a DoRA.

(4/3/2025) ani40z v0.4

Entrenado en Animagine XL 4.0 ani40zero.

Añadido conjunto de datos ~1k centrado en iluminación dinámica natural y texturas del mundo real.

Más iluminación natural y texturas naturales.

ani04 v0.1

Versión inicial para Animagine XL 4.0. Principalmente para corregir problemas de brillo de Animagine 4.0. Mejor contraste y más alto.

illus01 v1.23

nbep11 v0.138

Añadidas algunas imágenes furry/no humanas/otras para balancear el conjunto.

nbep11 v0.129

Versión mala, efecto demasiado débil, ignóralo.

nbep11 v0.114

Implementado "Colores rango completo". Balancea automáticamente las cosas hacia "normal y bonito". Puedes considerarlo como el botón de "mejora automática de foto" de un clic en muchas herramientas de edición. Un punto en contra es que impide sesgos altos. Por ejemplo, no puedes tener 95% de la imagen negra y 5% brillante, sino más equilibrado.

Añadidos datos un poco más realistas. Más detalles vivos, iluminación, menos colores planos.

illus01 v1.7

nbep11 v0.96

Más imágenes para entrenamiento.

Luego afinado nuevamente en un pequeño conjunto "wallpaper" (Papel tapiz real de juegos, la más alta calidad que encontré, ~100 imágenes). Mejora en detalles (notable en piel, cabello) y contraste.

nbep11 v0.58

Más imágenes. Cambié parámetros de entrenamiento para acercarse más al modelo base NoobAI.

illus01 v1.3

nbep11 v0.30

Más imágenes.

nbep11 v0.11: Entrenado en NoobAI epsilon pred v1.1.

Mejoradas las etiquetas del conjunto de datos. Mejorada la estructura y distribución de pesos de LoRA. Más estable y menos impacto en la composición de imagen.

illus01 v1.1

Entrenado en illustriousXL v0.1.

nbep10 v0.10

Entrenado en NoobAI epsilon pred v1.0.

Detalles del Modelo

Tipo de modelo

Modelo base

Versión del modelo

Hash del modelo

Creador

Discusión

Por favor log in para dejar un comentario.

Colección de Modelos - Stabilizer IL/NAI

Stabilizer IL/NAI - illus01 v1.23

Stabilizer IL/NAI - illus01 v1.121

Stabilizer IL/NAI - illus01 v1.185c

Stabilizer IL/NAI - nbep11 v0.138

Stabilizer IL/NAI - illus01 v1.152

Stabilizer IL/NAI - illus01 v1.165c

Stabilizer IL/NAI - nbep11 v0.205

Stabilizer IL/NAI - illus01 v1.72

Stabilizer IL/NAI - illus01 v1.198