SDXL - Effet Lenticulaires (Un Peu) - v1.0

Prompts négatifs recommandés

SDXL_TI_my_eyes_are_bleeding_2.0

Paramètres recommandés

samplers

steps

cfg

resolution

other models

Conseils

Ajoutez « lentclr_effect » en début de prompt pour restaurer le style lenticulaire si perdu.

Un nombre d'étapes plus bas (500-1000) permet une meilleure fusion de deux images, mais c’est surtout efficace sur les modèles Base XL.

Mélangez différentes LoRA et modèles pour expérimenter et trouver les résultats artistiques idéaux.

V1.0

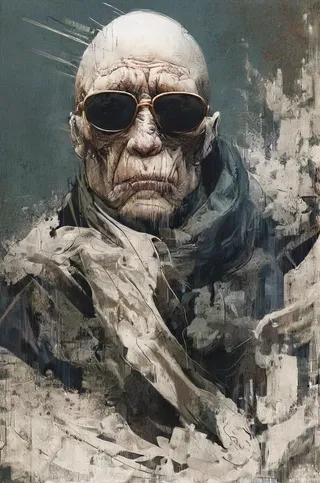

Effet lenticulaire (pas l'original, juste basé sur l'idée)

C'est essentiellement juste 2 images ou plus superposées, généralement avec du contenu différent, qui changent selon l'angle de vue. Pencher complètement d'un côté donne une image 1, de l'autre côté l'image 2. Je suppose que Google peut l'expliquer un peu mieux et plus en profondeur si vous êtes intéressé. Je ne savais même pas qu'il y avait un nom particulier pour ça, pour moi c'était toujours un hologramme.

C'est en gros ce qui arrive quand on a une poussée de nostalgie ou qu'on se souvient de quelque chose et qu'on essaie d'en faire une LoRA juste pour voir ce que ça donne, en sachant que ça ne peut pas marcher parce que plusieurs facteurs ne sont pas corrects ou manquants... dans ce cas principalement la préparation d'un dataset dans Photoshop qui soit au moins cohérent dans sa réalisation et le manque de mouvement.

Je ne comptais pas vraiment le publier, je m'amusais juste un peu parce que ça me sert un peu, surtout pour des tests.

Je visais la partie médiane, où les deux images se fondent l'une dans l'autre, comme si c'était laminé sous plastique ou autre. Bien sûr, sans mouvement, il est inutile de chercher l'effet réel, d'autres méthodes sont plus simples pour cela. C'est juste une transition d'une image à une autre. Mais il y a toujours quelque chose qui attire mon attention. Pour chaque image que j'ai publiée jusqu'à présent sur Civit, je pourrais probablement expliquer pourquoi je l'ai choisie. Pour la plupart, je ne me soucie pas de la qualité, ni de la mode ou du côté sophistiqué. Positions étranges, expressions, ambiance, lumières, inattendu, composition, choses stupides ou juste être accroché à un thème pour voir où ça mène sont à mon avis mon principal centre d'intérêt. J'ai passé assez de temps à étudier l'art, l'anatomie, les formes, les gestes et tout ce qui est ennuyeux pour savoir si quelque chose ne semble pas juste ou est décalé et, oh là là, beaucoup de mes images sont loin d'être parfaites... L'IA doit faire n'importe quoi pour m'intéresser. Cela ne veut pas dire que je n'apprécie pas une belle image, surtout si quelqu'un d'autre l'a faite, mais l'art sous toutes ses formes reste la chose la plus subjective qui soit, ce qui ajoute à la diversité par elle-même.

Bon...

J'ai aimé l'effet (profondeur, un peu de détails, inachevé, esquisses, coups de pinceau picturaux)

Il produit un chaos et un hasard à forte intensité parfois difficile à prévoir (sauf si le prompt le domine), ce qui est un grand + pour moi, mais il faut ajouter plus d'images. Malheureusement, choisir et préparer le dataset prend du temps, car même des images chaotiques non taguées sont prises en compte par l'entraînement et il y a un biais que je veux éviter/éliminer. Qualité et diversité doivent être prises en compte selon moi, même si c'est difficile à discerner après la magie de Photoshop. Il existe clairement un biais vers certaines images même si j'ai évité d'ajouter trop de choses que je tends à demander dans les prompts. La plupart des images sont des humains en positions artistiques ou des paysages, quelques créatures et animaux etc. J'ai toujours essayé de combiner 2 images ayant un thème et un style artistique différents, mais certaines étaient clairement plus visibles/distingables que d'autres, donc l'effet tend à privilégier ces images.

Le Base SDXL déteste ça avec passion à haute intensité. Un modèle bien entraîné ou fusionné est probablement mieux si vous voulez créer quelque chose d'« agréable à regarder ». Certains modèles annulant presque totalement l'effet, et si vous voulez le récupérer, ajouter lentclr_effect en début de prompt devrait aider.

Tests et passages sporadiques sur différents modèles pour voir ce qui arrive. Pour la démonstration, je n'ai utilisé que Base XL (parfois en combo avec mon embedding pour réduire le désordre). J'ai aussi été un peu paresseux et réutilisé quelques anciens prompts, surtout pour voir ce que ça donne et que les autres sachent ce qu'il se passe. Pendant l'entraînement, j'ai remarqué que les versions avec un nombre d'étapes plus bas (de 500 à 1000) étaient en fait plus proches de l'effet où deux images se fondent ensemble, mais cela n'a d'impact que sur des modèles proches de Base XL, tous les autres modèles fusionnés ou entraînés ignorant presque la LoRA à faible nombre d'étapes, donc 3000 étapes c'est ce qu'il faut. J'ai déjà posté d'autres images dans ma galerie faites avec une version plus ancienne et différents modèles.

Comme toujours, mélange LoRA/Model jusqu'à ce que moi ou quelqu'un d'autre trouve le Graal, qui est quelque part... enterré... très profondément... sur Mars... sous une montagne.

Fin de cette longue explication qui n'aide pas vraiment.

Détails du modèle

Type de modèle

Modèle de base

Version du modèle

Hash du modèle

Créateur

Discussion

Veuillez vous log in pour laisser un commentaire.