Stabilizer IL/NAI - nbep11 v0.114

Mots-clés et tags associés

Prompts recommandés

<lora:noobai_ep11_stabilizer_v0.114_fp16:0.8>1girl, fox ears, masterpiece

Paramètres recommandés

samplers

steps

cfg

resolution

other models

Conseils

Chargez ce LoRA en premier dans votre pile de LoRAs en raison du calcul dynamique du poids de patch dans l'architecture DoRA.

Utilisez-le comme modèle de base finement ajusté en le chargeant à pleine intensité sur un modèle de base pré-entraîné (recommandé).

Évitez de combiner ce LoRA avec des modèles de base incompatibles pour prévenir une dégradation de la qualité d’image.

Le partage des merges utilisant ce modèle est interdit ; il contient des mots déclencheurs cachés pour imprimer des filigranes invisibles.

Pour les problèmes de sursaturation ou de contraste dans les modèles de base, envisagez d’utiliser des LoRAs complémentaires comme Contrast Controller ou Dark.

Ce modèle est conçu sans biais de style par défaut, permettant un contrôle total du style via les prompts ou des LoRAs additionnels.

Sponsors du créateur

Découvrez la collection LoRA compatible Stabilizer pour un style plus flexible.

Essayez Contrast Controller pour un contrôle stable du contraste.

Explorez Dark LoRA pour corriger le biais de luminosité dans certains modèles de base.

Trouvez les derniers modèles sur Neta Lumina et Lumina 2.

Rejoignez la communauté sur TensorArt.

Ce que vous voyez est ce que vous obtenez. Les images de couverture sont des sorties brutes du modèle pré-entraîné, à une résolution de 1MP. Il n'y a aucun plugin magique, pas de suréchantillonnage, pas de correction de mains/visages, pas même de prompt négatif. Certains utilisateurs ont dit ne pas pouvoir reproduire les résultats, c'est une question de compétence. (Modèle de base non compatible ou trop d'"optimisations" ajoutées)

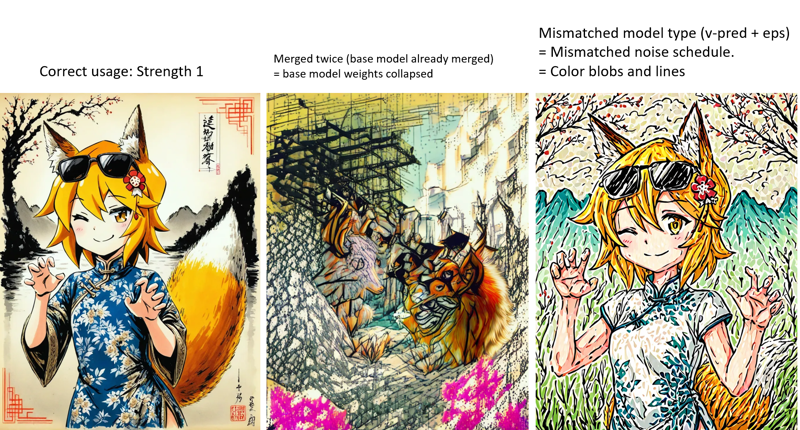

Si cela a détruit votre modèle de base même à faible intensité (par exemple <0.5), c'est un problème de votre modèle de base. Votre modèle de base a déjà fusionné ce LoRA (et vous l'avez fusionné deux fois). Les poids du modèle ont été multipliés et effondrés. Méfiez-vous des créateurs de modèles de base faux, alias. voleurs. Certains "créateurs" ne font jamais l'entraînement, ils se contentent de prendre les modèles des autres, les fusionnent, effacent toutes les métadonnées et crédits, et les vendent comme leurs propres modèles de base.

Note épinglée :

(27/09/2025) : Il est temps de regarder vers l'avenir...

Ce modèle ne sera plus mis à jour.

SDXL est tout simplement trop ... vieux, il a été publié il y a deux ans (juin 2023). Les nouveaux modèles sont beaucoup plus efficaces grâce à la nouvelle architecture.

Au moment où j'écris ceci, j'essayais Neta Lumina (Lumina 2) et Chroma (Flux.1).

Lumina 2 a été publié en janvier 2025, seulement 1,25x plus grand que SDXL, mais bien meilleur que SDXL dans tous les aspects grâce à la nouvelle architecture du modèle. NetaYume Lumina et Neta Lumina sont des modèles finement ajustés de style anime, entraînés sur les datasets danbooru et e621.

J'ai entraîné un "Enhancement bundle" LoRA pour NetaYume Lumina. Comme ce "stabilizer", il vous offre de meilleurs détails, moins de bruit. Et j'ai changé pour un nom moins trompeur. Vous pouvez l'essayer si vous avez Comfyui.

Chroma, peut-être plus tard...

Les nouveaux modèles seront publiés sur de nouvelles pages. Cette page ne sera pas mise à jour.

De plus, je ne pense pas qu'ils prendront en charge ces modèles. Je suis passé à TensorArt. Vous pouvez me trouver ici. Et essayez les modèles Lumina 2.

Stabilizer

Un modèle grand à petite échelle finement ajusté avec 7 000 images.

Focus sur la créativité, plutôt que sur un style fixe. Le dataset est très diversifié. Donc ce modèle n'a pas de style par défaut (biais) qui limite sa créativité.

Seulement des textures naturelles, un éclairage et des détails les plus fins. Pas de style IA plastique brillant. J'ai sélectionné chaque image à la main. Je sais que l'entraînement avec des images IA peut amplifier certains effets fous. Mais je ne suis pas fan de cela.

Meilleure compréhension des prompts. Entraîné avec des légendes en langage naturel.

(v-pred) Éclairage meilleur et équilibré, sans débordement ni sursaturation. Vous voulez un noir pur 0 et un blanc pur 255 dans la même image, même au même endroit ? Pas de problème.

Pourquoi pas de style par défaut ?

Qu'est-ce que le "style par défaut" : Si un modèle a un style par défaut (biais), cela signifie que peu importe ce que vous indiquez dans le prompt, le modèle doit générer les mêmes choses (visages, arrière-plans, ambiances) qui composent ce style par défaut.

Avantages : C'est facile à utiliser, vous n'avez plus à décrire le style.

Inconvénients : Mais vous ne pouvez pas non plus le remplacer. Si vous demandez quelque chose qui ne correspond pas au style par défaut, le modèle l'ignorera. Si vous empilez plusieurs styles, le style par défaut chevauchera/contaminera/limitera toujours les autres styles.

"pas de style par défaut" signifie pas de biais, et vous devez spécifier le style que vous souhaitez, par tags ou LoRA. Mais il n'y aura pas de chevauchement/contamination de style venant de ce modèle. Vous obtenez le style empilé exactement comme il devrait être.

Pourquoi ce "modèle de base finement ajusté" est un LoRA ?

Je ne suis pas un géant et je n'ai pas des millions d'images d'entraînement. Affiner tout le modèle de base n'est pas nécessaire, un LoRA suffit.

Je n'ai qu'à uploader, et vous n'avez qu'à télécharger, un petit fichier de 40 Mo, au lieu d'un checkpoint énorme de 7 Go, ce qui économise 99,4 % de données et d'espace de stockage.

Donc je peux le mettre à jour souvent.Ce LoRA peut sembler petit, il est quand même puissant. Parce qu'il utilise une nouvelle architecture appelée DoRA de Nvidia, qui est plus efficace que le LoRA traditionnel.

Alors comment obtenir ce "modèle de base finement ajusté" ?

C'est simple.

modèle de base pré-entraîné + ce LoRA = le "modèle de base finement ajusté"

Chargez simplement ce LoRA sur le modèle de base pré-entraîné avec la pleine intensité. Le modèle de base pré-entraîné deviendra alors le modèle de base finement ajusté. Voir ci-dessous "Comment utiliser".

Le partage des merges utilisant ce modèle est interdit. Pour info, il y a des mots déclencheurs cachés pour imprimer un filigrane invisible. J'ai codé moi-même le filigrane et le détecteur. Je ne veux pas l'utiliser, mais je peux.

Ce modèle est uniquement publié sur Civitai et TensorArt. Si vous voyez "moi" et cette phrase sur d'autres plateformes, ce sont tous des faux et la plateforme que vous utilisez est une plateforme pirate.

Veuillez laisser vos commentaires dans la section des commentaires. Ainsi tout le monde peut les voir. Ne laissez pas de commentaires dans le système d'avis de Civitai, il est mal conçu, littéralement personne ne peut trouver ou voir les avis.

Comment utiliser

Dernières versions :

nbvp10 v0.271 (pour NoobAI v-pred v1.0).

Couleurs précises et détails les plus fins. C'est le meilleur modèle jusqu'à présent.

C'est un LoRA v-pred, il NE FONCTIONNE QUE avec NoobAI v-pred v1.0. Il NE FONCTIONNE PAS avec les modèles eps.

nbep10 v0.273 (pour NoobAI eps v1.0).

Moins de saturation et de contraste comparé aux modèles v-pred. En raison d'"un petit défaut de conception" dans la prédiction epsilon standard (eps). Cela limite la plage de couleurs du modèle. C'est pourquoi nous avons ensuite le v-pred.

illus01 v1.198 (entraîné sur Illustrious v0.1).

Ancienne version. Plus recommandée.

Méfiez-vous que la plupart (90 %) des modèles de base anime étiquetés "illustrious" de nos jours sont en réalité NoobAI. Vous devriez donc utiliser les versions NoobAI ci-dessus. Une incompatibilité LoRA et modèle de base dégrade la qualité de l'image.

Chargez ce LoRA en premier dans votre pile de LoRAs.

Ce LoRA utilise une nouvelle architecture appelée DoRA de Nvidia, qui est plus efficace que le LoRA traditionnel. Cependant, contrairement au LoRA traditionnel qui a un poids de patch statique, le poids du patch de DoRA est calculé dynamiquement en fonction du poids actuel du modèle de base chargé (qui change lorsque vous chargez des LoRAs). Pour minimiser les changements inattendus, chargez ce LoRA en premier.

Deux façons d'utiliser ce modèle :

1). Utilisez-le comme un modèle de base finement ajusté (recommandé) :

Si vous voulez les détails les plus fins et naturels et construire la combinaison de styles que vous souhaitez, avec un contrôle total.

Chargez simplement ce LoRA en premier sur le modèle de base pré-entraîné avec la pleine intensité. Le modèle de base pré-entraîné deviendra alors mon modèle de base finement ajusté qui a généré toutes les images de couverture.

2). Utilisez-le comme LoRA sur un autre modèle de base finement ajusté.

Après tout, c'est un LoRA.

Dataset

dernière version ou versions récentes

Environ 7 000 images au total. Pas très grand (comparé aux géants qui aiment affiner les modèles avec des millions d'images), mais pas petit. Et chaque image est choisie à la main par moi.

Seulement des choses belles et normales. Pas de style artistique fou indescriptible.

Aucune image IA. Pas sous ma surveillance.

Seulement des images en haute résolution. La moyenne du dataset est de 3,37 MP, environ 1800x1800.

Toutes les images ont des légendes naturelles générées par Google LLM.

Autres outils

Quelques idées qui allaient faire partie du Stabilizer ou qui en faisaient partie. Maintenant, ce sont des LoRAs séparés. Pour une meilleure flexibilité. Lien de la collection : https://civitai.com/collections/8274233.

Dark: Un LoRA qui est biaisé vers des environnements plus sombres. Utile pour corriger le biais de haute luminosité dans certains modèles de base. Entraîné sur des images à faible luminosité. Pas de biais de style, donc pas de contamination de style.

Contrast Controller: Un LoRA fait main. Contrôle le contraste comme un curseur sur votre moniteur. Contrairement à d'autres "améliorateurs de contraste" entraînés, l'effet de ce LoRA est stable, linéaire mathématiquement, et n'a aucun effet secondaire sur le style.

Utile quand votre modèle de base a des problèmes de sursaturation ou si vous voulez quelque chose de vraiment coloré.

Exemple :

Style Strength Controller : Ou réducteur d'effet de sur-apprentissage. Peut réduire tous types d'effets de sur-apprentissage (biais sur objets, luminosité, etc.), mathématiquement. Ou les amplifier, si vous voulez.

Différences avec Stabilizer :

Différences avec Stabilizer :

Stabilizer a été entraîné sur des données du monde réel. Il peut seulement "réduire" les effets de sur-apprentissage sur la texture, les détails et les arrière-plans, en les rajoutant.

Style Controller n'est pas issu de l'entraînement. C'est plus comme "annuler" l'entraînement pour le modèle de base, donc il sera moins sur-appris. Peut mathématiquement réduire tous les effets de sur-apprentissage, comme le biais sur la luminosité ou les objets.

Anciennes versions :

Vous pouvez trouver plus d'infos dans le "Journal des mises à jour". Attention, les anciennes versions peuvent avoir des effets très différents.

Chronologie principale :

Maintenant ~ : Détails et textures naturels, compréhension stable des prompts et plus de créativité. Plus limité au style anime 2D pur.

illus01 v1.23 / nbep11 0.138 ~ : Meilleur style anime avec des couleurs vives.

illus01 v1.3 / nbep11 0.58 ~ : Meilleur style anime.

Journal des mises à jour

(31/08/2025) NoobAI ep10 v0.273

Cette version est entraînée depuis le début sur NoobAI eps v1.0.

Comparé à l'ancien illus01 v1.198 :

Meilleure luminosité équilibrée dans des conditions extrêmes. (comme nbvp v0.271)

Meilleures textures et détails. Plus d'étapes d'entraînement sur les timesteps à haut rapport signal/bruit. (les versions illus01 évitaient ces timesteps pour meilleure compatibilité, maintenant tous les modèles de base sont NoobAI, pas besoin de les éviter.)

(24/08/2025) NoobAI v-pred v0.271 :

Comparé à l'ancien v0.264 :

Éclairage meilleur et équilibré dans des conditions extrêmes, moins de biais.

Contraste élevé, noir pur 0 et blanc pur 255 dans la même image, même au même endroit, sans débordement ni sursaturation. Maintenant vous pouvez tout avoir en même temps.

(l'ancien v0.264 essayait de limiter l'image entre 10~250 pour éviter le débordement, mais avait toujours un biais visible, l'image globale pouvait être trop sombre ou trop claire)

Comme pour v0.264, préférez une intensité élevée ou maximale (0.9~1).

(17/08/2025) NoobAI v-pred v0.264 :

Première version entraînée sur NoobAI v-pred.

Elle offre un meilleur éclairage, moins de débordement.

Note : préférez une intensité élevée ou maximale (0.9~1).

(28/07/2025) illus01 v1.198

Principalement par rapport à v1.185c :

Fin de la version "c". Même si "visuellement marquante" est bien, elle a des problèmes de compatibilité. Par exemple, quand votre modèle de base a déjà une amélioration similaire du contraste. Empiler deux améliorations du contraste est vraiment mauvais. Donc plus d'effets post-traitement fous (contraste et saturation élevés, etc.).

À la place, plus de textures et de détails. Éclairage de niveau cinématographique. Meilleure compatibilité.

Cette version a beaucoup changé, y compris le dataset, donc l'effet est assez différent des versions précédentes.

Pour ceux qui veulent retrouver les effets fous de la v1.185c. Vous pouvez trouver des styles d'art purs et dédiés sur cette page. Si le dataset est assez grand pour un LoRA, je pourrais en entraîner un.

(21/06/2025) illus01 v1.185c :

Comparé à v1.165c.

+100 % de clarté et netteté.

-30 % d’images trop chaotiques (indescriptibles). Donc vous constaterez que cette version ne peut plus donner un contraste très élevé, mais devrait être plus stable dans les cas d’utilisation normaux.

(10/06/2025) : illus01 v1.165c

C’est une version spéciale. Ce n’est pas une amélioration de la v1.164. "c" signifie "coloré", "créatif", parfois "chaotique".

Le dataset contient des images très visuellement marquantes, mais parfois difficiles à décrire par exemple : très colorées, contraste élevé, conditions d’éclairage complexes. Objets et motifs complexes partout.

Vous obtenez donc un "visuellement marquant", mais au prix du "naturel". Peut affecter les styles avec des couleurs douces, etc. Cette version ne peut pas générer parfaitement une texture "dessin au crayon" comme la v1.164.

(04/06/2025) : illus01 v1.164

Meilleure compréhension des prompts. Maintenant chaque image a 3 légendes naturelles, de perspectives différentes. Les tags Danbooru sont vérifiés par LLM, seuls les tags importants sont sélectionnés et fusionnés dans la légende naturelle.

Anti surexposition. Ajout d’un biais pour éviter que la sortie du modèle atteigne le blanc pur #ffffff. La plupart du temps, #ffffff == surexposition, ce qui fait perdre beaucoup de détails.

Changement de certains paramètres d’entraînement. Plus compatible avec NoobAI, à la fois e-pred et v-pred.

(19/05/2025) : illus01 v1.152

Amélioration continue de l’éclairage, des textures et des détails.

5 000 images en plus, plus d’étapes d’entraînement, donc effet renforcé.

(09/05/2025) : nbep11 v0.205 :

Correction rapide des problèmes de luminosité et de couleur dans la v0.198. Maintenant l’image ne devrait plus changer de façon dramatique comme une vraie photo. La v0.198 n’est pas mauvaise, juste trop créative.

(07/05/2025) : nbep11 v0.198 :

Ajout d’images sombres. Moins de corps déformés, arrière-plan en environnement sombre.

Suppression de l’amélioration de couleur et de contraste. Ce n’est plus nécessaire. Utilisez Contrast Controller à la place.

(25/04/2025) : nbep11 v0.172.

Mêmes nouveautés que illus01 v1.93 ~ v1.121. Résumé : nouveau dataset photographique "Touching Grass". Meilleures textures naturelles, arrière-plan, éclairage. Effets de personnage réduits pour meilleure compatibilité.

Meilleure précision et stabilité des couleurs. (Comparé à nbep11 v0.160)

(17/04/2025) : illus01 v1.121.

Retour à illustrious v0.1. Les versions illustrious v1.0 et suivantes ont été entraînées avec des images IA délibérément (environ 30 % du dataset), ce qui n’est pas idéal pour l’entraînement LoRA. Je ne l’ai remarqué qu’après avoir lu leur papier.

Effet de style personnage réduit. Retour au niveau v1.23. Moins de détails pour les personnages avec ce LoRA, mais meilleure compatibilité. C’est un compromis.

Autres éléments identiques à ci-dessous (v1.113).

(10/04/2025) : illus11 v1.113 ❌.

Mise à jour : n’utilisez cette version que si votre modèle de base est basé sur Illustrious v1.1. Sinon, utilisez illus01 v1.121.

Entraîné sur Illustrious v1.1.

Nouveau dataset "Touching Grass" ajouté. Meilleure texture naturelle, éclairage et profondeur de champ. Meilleure stabilité structurelle des arrière-plans. Moins d’arrière-plans déformés, comme les pièces ou bâtiments.

Légendes en langage naturel complètes par LLM.

(30/03/2025) : illus01 v1.93.

v1.72 était trop entraîné. J’ai donc réduit son intensité globale. Devrait avoir une meilleure compatibilité.

(22/03/2025) : nbep11 v0.160.

Mêmes contenus que illus v1.72.

(15/03/2025) illus01 v1.72

Même nouveau dataset de textures et éclairage naturels mentionné dans ani40z v0.4 ci-dessous. Éclairage plus naturel et textures naturelles.

Ajout d’un petit dataset d’environ 100 images pour l’amélioration des mains, focalisé sur les mains dans différentes tâches, comme tenir un verre ou une tasse.

Suppression de toutes les images avec "arrière-plans simples" du dataset. -200 images.

Changement de l’outil d’entraînement de kohya à onetrainer. Changement de l’architecture LoRA vers DoRA.

(04/03/2025) ani40z v0.4

Entraîné sur Animagine XL 4.0 ani40zero.

Ajout d’un dataset d’environ 1 000 images focalisé sur un éclairage naturel dynamique et des textures du monde réel.

Éclairage plus naturel et textures naturelles.

ani04 v0.1

Version initiale pour Animagine XL 4.0. Principalement pour corriger les problèmes de luminosité d’Animagine 4.0. Meilleur contraste.

illus01 v1.23

nbep11 v0.138

Ajout d’images furry/non-humaines/autres pour équilibrer le dataset.

nbep11 v0.129

Mauvaise version, effet trop faible, ignorez-la.

nbep11 v0.114

Implémenté "Couleurs en gamme complète". Il équilibrera automatiquement les choses vers le "normal et esthétique". Pensez à ce bouton "amélioration photo automatique" d’un clic dans la plupart des outils de retouche photo. Un inconvénient de cette optimisation : elle empêche un biais élevé. Par exemple, vous voulez que 95 % de l’image soit noire et 5 % lumineuse, au lieu de 50/50 %.

Ajout de données un peu réalistes. Détails plus vifs, éclairage, couleurs moins plates.

illus01 v1.7

nbep11 v0.96

Plus d’images d’entraînement.

Puis affiné de nouveau sur un petit dataset "wallpaper" (fonds d’écran de jeux réels, la meilleure qualité que j’ai trouvée, environ 100 images). Améliorations des détails (notables sur la peau, les cheveux) et du contraste.

nbep11 v0.58

Plus d’images. Modification des paramètres d’entraînement pour s’approcher le plus possible du modèle de base NoobAI.

illus01 v1.3

nbep11 v0.30

Plus d’images.

nbep11 v0.11 : Entraîné sur NoobAI epsilon pred v1.1.

Meilleurs tags de dataset. Amélioration de la structure et de la distribution des poids de LoRA. Devrait être plus stable et avoir moins d’impact sur la composition d’image.

illus01 v1.1

Entraîné sur illustriousXL v0.1.

nbep10 v0.10

Entraîné sur NoobAI epsilon pred v1.0.

Détails du modèle

Type de modèle

Modèle de base

Version du modèle

Hash du modèle

Créateur

Discussion

Veuillez vous log in pour laisser un commentaire.

Collection de modèles - Stabilizer IL/NAI

Stabilizer IL/NAI - illus01 v1.23

Stabilizer IL/NAI - illus01 v1.121

Stabilizer IL/NAI - illus01 v1.185c

Stabilizer IL/NAI - nbep11 v0.138

Stabilizer IL/NAI - illus01 v1.152

Stabilizer IL/NAI - illus01 v1.165c

Stabilizer IL/NAI - nbep11 v0.205

Stabilizer IL/NAI - illus01 v1.72

Stabilizer IL/NAI - illus01 v1.198