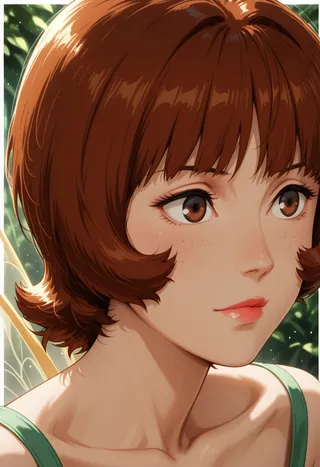

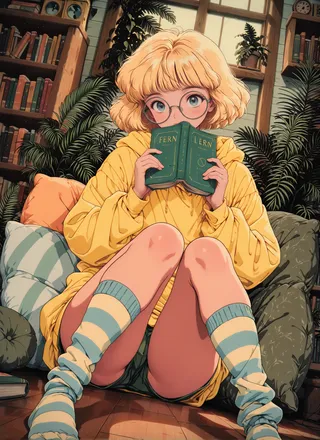

SPO-SDXL_4k-p_10ep_LoRA_webui - v1.0

Wskazówki

Ten model to punkt kontrolny dostrojony metodą LoRA.

Trening obejmował 4 000 promptów przez 10 epok.

Krokowa Optymalizacja Preferencji pozwala na drobne wizualne ulepszenia na każdym kroku, efektywnie poprawiając estetykę.

Estetyczne modele dyfuzji po treningu oparte na ogólnych preferencjach z Krokową Optymalizacją Preferencji

Streszczenie

Generowanie wizualnie atrakcyjnych obrazów jest istotne dla nowoczesnych modeli przekształcających tekst na obraz. Potencjalnym rozwiązaniem dla poprawy estetyki jest bezpośrednia optymalizacja preferencji (DPO), która została zastosowana w modelach dyfuzji w celu ulepszenia ogólnej jakości obrazu, w tym zgodności z promptem i estetyki. Popularne metody DPO propagują etykiety preferencji z czystych par obrazów na wszystkie pośrednie kroki wzdłuż dwóch trajektorii generacji. Jednak etykiety preferencji w istniejących zbiorach danych są mieszanką preferencji dotyczących układu i estetyki, co może nie odpowiadać rzeczywistym preferencjom estetycznym. Nawet jeśli etykiety estetyczne byłyby dostępne (za znaczne koszty), metody oparte na dwóch trajektoriach miałyby trudności w uchwyceniu niuansów wizualnych na różnych etapach.

Aby poprawić estetykę ekonomicznie, ten artykuł wykorzystuje istniejące ogólne dane preferencji i wprowadza krokową optymalizację preferencji (SPO), która odrzuca strategię propagacji i pozwala oceniać drobne detale obrazu. Konkretne, na każdym etapie odszumiania: 1) próbkujemy pulę kandydatów poprzez odszumianie z wspólnego szumu latentnego, 2) używamy modelu preferencji uwzględniającego krok, by znaleźć odpowiednią parę wygrywający-przegrywający do nadzoru modelu dyfuzji, oraz 3) losowo wybieramy jeden z puli do inicjalizacji następnego etapu odszumiania. Ta strategia zapewnia, że modele dyfuzji skupiają się na subtelnych, drobnych różnicach wizualnych zamiast na aspekcie układu. Stwierdzamy, że estetyka może być znacznie ulepszona poprzez kumulację tych drobnych usprawnień.

Podczas dostrajania Stable Diffusion v1.5 i SDXL, SPO przynosi znaczące poprawy estetyki w porównaniu z istniejącymi metodami DPO, nie poświęcając zgodności obrazu z tekstem, w porównaniu z modelami bazowymi. Co więcej, SPO konwerguje znacznie szybciej niż metody DPO dzięki etapowemu wyrównywaniu drobnych wizualnych szczegółów. Kod i model: https://rockeycoss.github.io/spo.github.io/

Opis modelu

Model ten jest dostrojony z stable-diffusion-xl-base-1.0. Był trenowany na 4 000 promptach przez 10 epok. Ten checkpoint to punkt kontrolny LoRA. Aby uzyskać więcej informacji, odwiedź tę stronę

Cytowanie

Jeśli uważasz naszą pracę za przydatną, prosimy o wystawienie gwiazdki i cytowanie naszej pracy.

@article{liang2024step,

title={Estetyczne modele dyfuzji po treningu oparte na ogólnych preferencjach z krokową optymalizacją preferencji},

author={Liang, Zhanhao and Yuan, Yuhui and Gu, Shuyang and Chen, Bohan and Hang, Tiankai and Cheng, Mingxi and Li, Ji and Zheng, Liang},

journal={arXiv preprint arXiv:2406.04314},

year={2024}

}Szczegóły modelu

Dyskusja

Proszę się log in, aby dodać komentarz.