Colossus Project Flux - V12 "Hephaistos" FP8_UNET

Verwandte Schlüsselwörter & Tags

Empfohlene Negative Prompts

blurry

Empfohlene Parameter

samplers

steps

cfg

resolution

vae

Tipps

Verwendet etwa 20-30 Schritte mit 2.2 CFG für hochwertige Ergebnisse.

Bevorzugte Sampler sind Euler mit Simple Scheduler; auch DPM++ 2M und Heun funktionieren gut.

Fügt den negativen Prompt 'blurry' hinzu, um unerwünschte Artefakte zu reduzieren.

Beim experimentellen v2.1 Modell schaltet die Flux Guidance Scale aus und verwendet stattdessen CFG Scale.

Die FP4-Version ist nur für Nvidia 50xx Serie; Int4-Version funktioniert mit 40xx und älteren GPUs.

Ladet erforderliche Clip_L Dateien herunter, damit UNET-only Versionen richtig funktionieren.

Probiert verschiedene Sampler- und CFG-Einstellungen innerhalb der empfohlenen Bereiche für unterschiedliche Ergebnisse aus.

Versions-Highlights

WORKFLOW: https://civitai.com/articles/17163

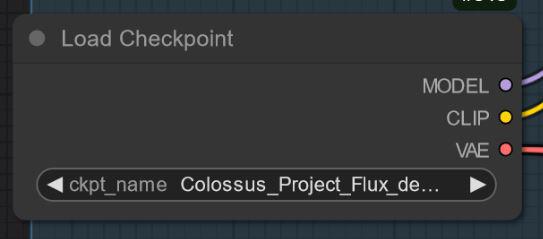

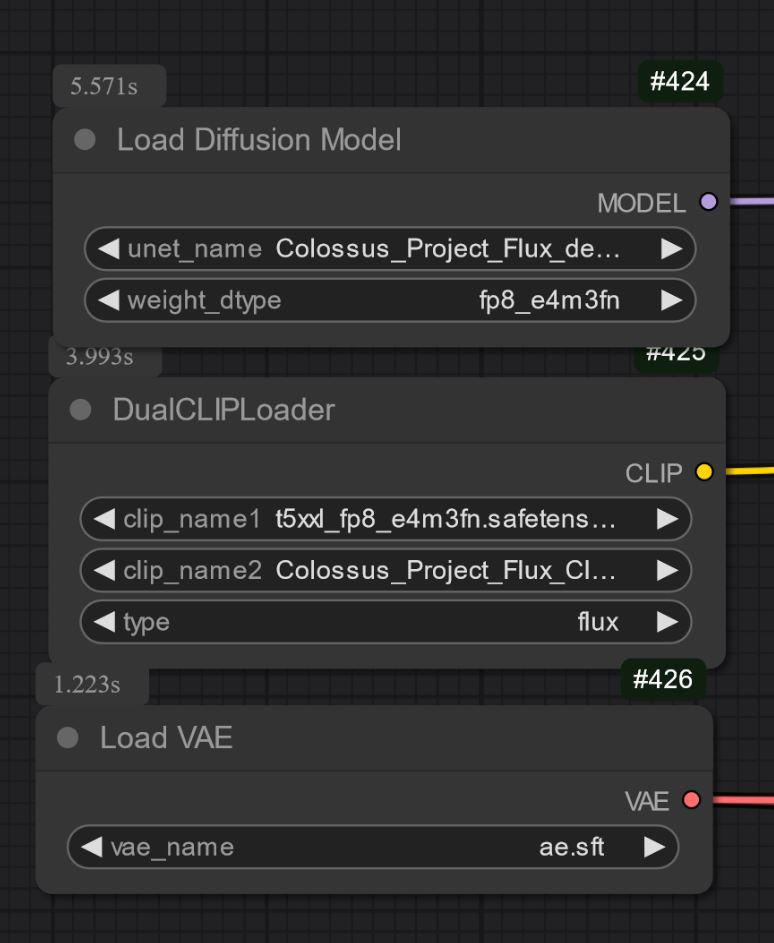

FP8_unet Version von V12: Verwendet dafür diesen clip_l:

https://civitai.com/models/833086?modelVersionId=1985466

Verwendet außerdem das t5xxl_fp8_e4m3fn mit diesem unet.

Version V12 "Hephaistos"

Die Veröffentlichung dieses Checkpoints macht mich gleichzeitig glücklich und traurig.. V12 wird der letzte Checkpoint dieser Serie sein.. Der Hauptgrund sind die kommenden EU-KI-Gesetze... Ein weiterer Grund ist die Lizenz, die Flux .1 DEV hat. Vielen Dank an alle für die Unterstützung!

Wie auch immer.. Ich werde diese Serie auf einem Höhepunkt beenden...

V12 basiert auf V10B "BOB" und enthält im Grunde die besten Teile dieser Serie, blockverschmolzen in einem Checkpoint. (Das Ergebnis einer neuen Zusammenführungsmethode, die etwa 1:30 Stunden dauerte und meinen gesamten 128GB RAM beanspruchte). Ich habe außerdem die Gesichts- und Hauttexturen im Vergleich zu V10 verbessert. Die Augen wirken viel realistischer und lebendiger als zuvor.

Testet es selbst und gebt mir Feedback zu V12. Dank meiner langsamen Internetverbindung werde ich zuerst die FP8_UNET hochladen. Danach die FP8 "all in one" Version und anschließend die FP16_unet und FP16_BEHEMOTH. Ich werde auch versuchen, sie in int4 und fp4 zu konvertieren (wünscht mir Glück).

Wie immer: Gebt mir Feedback zu V12..

Ersteller-Sponsoren

Wenn euch dieses Modell gefällt, unterstützt den Ersteller auf Ko-fi.

Schaut euch die Installations- und Workflow-Anleitungen für eine einfachere Einrichtung an:

- https://civitai.com/articles/17313

- https://civitai.com/articles/17358

- https://civitai.com/articles/17163

- https://civitai.com/articles/15610

Weitere Workflows und Showcase-Bilder verfügbar hier.

Tief unter einem Berg lebt ein schlafender Riese, der entweder der Menschheit helfen oder Zerstörung anrichten kann...

Ein Koloss erhebt sich...

Nach meiner SDXL-Reihe ist es Zeit für die FLUX-Serie dieses Projekts... Diesmal habe ich dieses Modell von Grund auf trainiert. Für das Training habe ich meine eigenen Bilder verwendet. Ich habe sie mit meinem schnellen Flux-Modell DemonFlux/Colossus Project schnell + meinem SDXL Colossus Project 12 als Verfeinerer erstellt.

Dieses SD Flux-Checkpoint kann nahezu alles erzeugen.. Colossus ist sehr gut darin, extrem realistische Bilder, Anime und Kunst zu erstellen.

Wenn es euch gefällt, gebt gerne Feedback. Wenn ihr mich unterstützen wollt, könnt ihr das hier tun. Ich habe einiges investiert, um einen Computer zusammenzustellen, der tatsächlich in der Lage ist, Flux-Modelle zu trainieren.. Training und Testen kosten ebenfalls viel Zeit und Strom..

https://ko-fi.com/afroman4peace

Version V12 "Hephaistos"

Die Veröffentlichung dieses Checkpoints macht mich gleichzeitig glücklich und traurig.. V12 wird der letzte Checkpoint dieser Serie sein.. Der Hauptgrund sind die kommenden EU-KI-Gesetze... Ein weiterer Grund ist die Lizenz von Flux .1 DEV selbst. Vielen Dank an alle für die Unterstützung! Ich habe im letzten Jahr viel Zeit in dieses Projekt investiert. Nun ist es Zeit, ein anderes Projekt anzugehen.

Wie auch immer.. Ich werde diese Serie auf einem Höhepunkt beenden...

V12 basiert auf V10B "BOB" und enthält im Grunde die besten Teile dieser Serie, blockverschmolzen in diesem einen Checkpoint. (Das Ergebnis einer neuen Zusammenführungsmethode, die etwa 1:30 Stunden dauerte und meinen gesamten 128GB RAM beanspruchte). Ich habe außerdem die Gesichts- und Hauttexturen im Vergleich zu V10 verbessert. Die Augen wirken viel realistischer und lebendiger als zuvor.

Testet es selbst und gebt mir Feedback zu V12. Dank meiner langsamen Internetverbindung werde ich zuerst die FP8_UNET hochladen. Danach die FP8 "all in one" Version und anschließend die FP16_unet und FP16_BEHEMOTH. Ich werde auch versuchen, sie in int4 und fp4 zu konvertieren (wünscht mir Glück).

Wie immer: Gebt mir Feedback zu V12..

Version V12 "Behemoth" (AIO)

Dieses "all in one" Modell ist das Beste meiner V12-Serie.. und natürlich das größte in der Größe :-)

Der Behemoth hat ein kundenspezifisches T5xxl und Clip_l, die im Modell integriert sind. Wenn ihr Qualität der Quantität vorzieht, ist dies der Checkpoint für euch!

Version V12 FP4/int4

Dank Muyang Li von Nunchakutech, der die Quantifizierung von V12 durchgeführt hat. https://huggingface.co/nunchaku-tech und ihr fantastischer Nunchaku!

Diese Version ist wirklich beeindruckend. Sie kombiniert Qualität mit bisher nie gesehener Geschwindigkeit.

ACHTUNG!

Es gibt zwei Versionen FP4 und int4. FP4 ist nur für Nvidia 50xx Grafikkarten! Int4 funktioniert mit 40xx und älteren Karten. (Mindestens eine 20xx-Serie wird benötigt)

Ihr könnt beide Versionen hier direkt herunterladen: https://huggingface.co/nunchaku-tech/nunchaku-flux.1-dev-colossus

INSTALLATIONSANLEITUNG und WORKFLOW

Hier ist eine schnelle Installationsanleitung und ein WIP-Workflow.

https://civitai.com/articles/17313

AUSFÜHRLICHE ANLEITUNG für den Workflow

https://civitai.com/articles/17358

Ich arbeite noch an meinen neuen Workflows für Nunchaku.. daher ist der folgende Workflow noch sehr im WIP-Stadium (Work in Progress). Am Wochenende werde ich einen ausführlichen Artikel hinzufügen.

Version V12 FP16_B_Variante

Dank eines kleinen Fehlers, den ich spät nachts (2 Uhr) gemacht habe, habe ich den "falschen" Checkpoint umbenannt und hochgeladen. Das ist ein sehr experimenteller Checkpoint, der nie veröffentlicht werden sollte. Er wurde nicht ausgiebig getestet, hat aber bei der Showcase-Erstellung sehr gut abgeschnitten. Möglicherweise ist er besser als die Standardversion.

Er tendiert mehr zu asiatischen Gesichtern.. Das liegt daran, dass ich etwas testen wollte, um es mit einem Nebenprojekt zu mischen, an dem ich noch arbeite. Erzählt mir eure Erfahrungen mit diesem Checkpoint :-)

Version V12 AIO FP8

Diese Version ist eine All-in-One-Version von V12. Das bedeutet, dass alle Clips darin integriert sind. Die Ausgabe entspricht der FP8_unet mit meinem kundenspezifischen clip_l.

Version V12 GGUF Q5_1

Diese Version wurde angefragt. Die Qualität ist nicht schlecht..

Version V10B "BOB"

Dies ist eine alternative Version von V10. Ich habe sie erstellt, um die FP8 Version von V10 zu verbessern. Im Allgemeinen ist die FP8 Version präziser und die Farben besser. Leider habe ich momentan nicht viel Zeit.. (RL geht vor). Deshalb hat das so lange gedauert.. Lasst mich wissen, wenn ihr diese Version bevorzugt. Ich habe auch eine FP16 Version von "BOB". Abhängig vom Feedback erwäge ich auch, eine int4 Version zu veröffentlichen.

WORKFLOW:

Hier ist der Workflow für V12 und V10: https://civitai.com/articles/17163

Version V10_int4_SVDQ "Nunchaku"

Erstmal danke an theunlikely https://huggingface.co/theunlikely, der den FP16_Unet in int4_SVDQ konvertiert hat. Besucht seine Seite und hinterlasst ein Like.

Diese Version ist mehr oder weniger gleichwertig mit der FP8 Version. Selbst im normalen Modus meines Workflows ist dieses Modell etwa 2-3x schneller als das reguläre Modell.. Mit dem "schnellen Modus" des Workflows kann ich ein 2MP-Bild in ca. 19 Sekunden mit meiner 3090ti rendern.

Was ist SVDQ "Nunchaku"?

Diese neue Quantifizierungsmethode erlaubt es, Flux-Modelle (in diesem Fall ein natives FP16 Modell) von 24GB auf etwa 6,7GB zu verkleinern. Aber das ist nicht alles: Man kann Generationen schneller als je zuvor ausführen, ohne zu viel Qualität zu verlieren. Sicher wird man einen kleinen Unterschied zu meinem 32GB_Behemoth bemerken, aber für diese Version benötigt man deutlich mehr VRAM/RAM, um sie überhaupt auszuführen.

Für mehr Informationen besuche: https://github.com/mit-han-lab/ComfyUI-nunchaku?tab=readme-ov-file

Installation: Bitte besuche meine Workflow/Installationsanleitung: https://civitai.com/articles/15610

Version V10 "Behemoth" (FP16_AIO)

Diese Version ist noch experimentell. Der Hauptfokus lag darauf, realistischere Ergebnisse zu erzielen. Außerdem habe ich versucht, einige "Flux-Linien" zu reduzieren. Dieses Modell basiert auf Colossus Project V5.0_Behemoth, V9.0 und einem weiteren Projekt, das ich "Ouroborus Project" nenne.

Die FP16 Version ist sehr stabil. Bald werde ich auch eine FP8 Version veröffentlichen. Diese ist auch sehr gut, jedoch nicht so stabil..

Ich lasse euch gern damit experimentieren.. Sagt mir, was ihr von dieser Version haltet.

Viel Spaß beim Erstellen :-)

Version V9.0:

Ich muss viel erklären.. Erstmal: Warum ist es überhaupt V9.0?

Ich bin kürzlich in eine neue Wohnung gezogen und wegen Fehler des Internetanbieters hatte ich keine richtige Internetverbindung.. Während dem Umziehen lief mein Computer durchgehend. Das Ergebnis war, dass ich viele (meist fehlerhafte) Checkpoints erstellt habe. Ich habe aber einige sehr gute V8 Versionen, die ich eventuell auch veröffentlichen werde..

Was hat sich geändert?

Ich habe neue Gesichts- und Hauttexturen trainiert, indem ich im Wesentlichen die besten Ergebnisse von V5.0 verwendet habe. Außerdem bekam das Modell ein Training für Füße/Beine für bessere Anatomie. Die V5.0 Versionen haben manchmal Kopf und Füße abgeschnitten.. Ich denke, ich habe einige dieser Probleme gelöst..

Zusätzlich habe ich es mit mehr meiner eigenen Landschaftsbilder trainiert.. Und ja, ich habe das alles während des Umzugs gemacht... Insgesamt betrug die Trainingszeit etwa 2 Wochen Rechenzeit, was nicht gerade günstig ist.. (jede Stunde kostet mich etwa 25 Cent Strom)

Ich hoffe jedenfalls, dass euch diese Version gefällt.. Wenn ihr mich unterstützen wollt: Postet schöne Bilder oder gebt mir sogar einen Tipp über Buzz oder Ko-fi..

Gebt mir euer Feedback :-)

Version 5.0:

V5.0 basiert tatsächlich auf V4.2 und V4.4 (die ebenfalls bald veröffentlicht werden). Es erhielt zusätzliches Training zu Hautdetails und zur Anatomie generell, was hauptsächlich Probleme mit Händen und Brustwarzen behob. Die Gesichtdetails sind deutlich besser. Ich habe auch versucht, einige kleinere Flux-Linien zu korrigieren..

Generell ist diese Version realistischer als V4.2 und besser bei kleinen Details.. Wie Version 4.2 ist dies auch ein hybrides de-distilled Modell. Es kann grundsätzlich mit denselben Einstellungen wie V4.2 verwendet werden.

Hier ist auch ein neuer Workflow zum Ausprobieren: https://civitai.com/articles/11950/workflow-for-colossus-project-flux-50

Lasst mich wissen, was ihr im Vergleich zu 4.2 oder V2.1 davon haltet..

Version 4.4 "Research":

Ich habe diese Version nur der Vollständigkeit halber hinzugefügt.. Sie ist etwas realistischer als V4.2 und die Basis für Version 5.0. Ihr könnt sie ausprobieren, wenn ihr möchtet. Der Workflow für V5.0 und V4.2 ist ebenfalls verwendbar..

Version 4.2:

Diese Version ist im Grunde eine Weiterentwicklung von Demoncore Flux und Colossus Project Flux. Ziel war es, ein stabileres Ergebnis mit besseren Hauttexturen, besseren Händen und vielfältigeren Gesichtern zu erzielen. Deshalb habe ich es auf einem Hybridmodell trainiert, das teilweise Demoncore Flux ist. Außerdem habe ich Brustwarzen und NSFW leicht verbessert. Sagt mir, ob ihr V4.2 der Version 2.1 vorzieht :-)

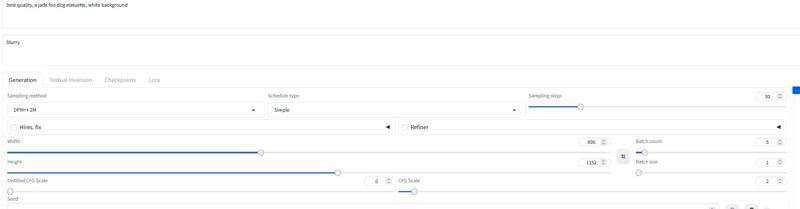

Für die Showcase-Bilder habe ich nur native Bilder mit SDXL-Auflösung oder 2MP-Auflösung verwendet (zum Beispiel 1216x1632). Dieses Modell kann auch höhere Auflösungen verarbeiten.. Ich habe diesen Checkpoint bis zu 2500x2500 getestet, empfehle aber etwa 2000x2000 als Obergrenze.

Für die Einstellungen empfehle ich etwa 30 Schritte und 2-2,5 CFG. Ich nutze meistens 2.2 oder 2.3 in meinem Workflow. Für den Showcase habe ich DPM++ 2M mit Simple Scheduler verwendet.

Ich werde bald weitere Versionen hinzufügen, habe aber vor Weihnachten nicht viel Zeit..

Einstellungen

Ich werde bald einen weiteren speziellen Comfy-Workflow hinzufügen. Fürs Erste könnt ihr die Showcase-Bilder herunterladen und öffnen..

Die "All in One" Version funktioniert auch gut mit Forge..

Grundsätzlich funktioniert sie mit denselben Einstellungen wie Version 2.1 (siehe unten)

Nehmt etwa 20-30 Schritte mit ungefähr 2.2 CFG..

Version 2.1_de-distilled_experimental (MERGE)

Diese Version ist komplett anders und funktioniert tatsächlich anders als ein normales Flux-Modell!

Es ist ein experimentelles Merge zwischen meiner Version 2.0 und einer de-distilled Version https://huggingface.co/nyanko7/flux-dev-de-distill. Das passierte eher zufällig, aber das Ergebnis ist beeindruckend. Ihr bekommt atemberaubende Details. Außerdem setzt es die Prompts extrem gut um... Das Nächste wird sein, direkt auf dem de-distilled Modell zu trainieren. Ich habe bereits einige Test-Loras damit erstellt. Das ist hochgradig experimentell, also gebt bitte Bescheid, wenn ihr Fehler findet, die unten nicht aufgelistet sind. Postet gute Bilder.. auch schlechte, das kann helfen, das Modell zu verbessern :-). Vielleicht probiere ich auch Version 2.0 aus und ihr sagt mir, welcher Checkpoint am besten für euch passt.

!Achtung!

Der normale Flux-Workflow funktioniert mit dieser Version nicht. IHR MÜSST meinen Workflow dafür herunterladen!

Ihr könnt auch selbst etwas ausprobieren, aber bitte gebt mir keine Schuld für schlechte Bilder. Das ist ein hochgradig experimentelles Modell... siehe Nachteile unten..

Vor- und Nachteile dieses Checkpoints:

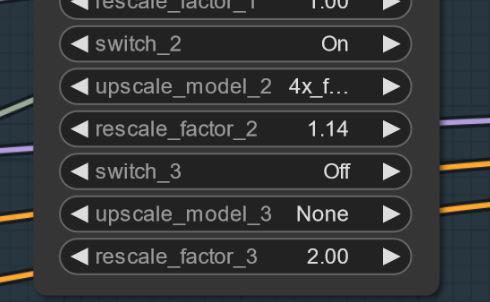

Dieser Checkpoint kann extrem detailreiche Bilder erzeugen.. Das hat seinen Preis.. Es ist langsamer als die normalen Flux-Checkpoints. Der Vorteil ist, dass ihr oft keinen zusätzlichen Upscale mehr braucht. Statt Flux Guidance verwendet dieses Modell den CFG Scale. Das bedeutet auch, dass es nicht mit Standard-Workflows funktioniert.

Man kann negative Prompts verwenden! Das hilft, unerwünschte Elemente aus dem Bild zu verbannen.

Manchmal können Artefakte auftreten.. Das lässt sich durch einen kleinen und einfachen Upscale beheben (ich arbeite daran). Hier ein Beispiel.. Das passiert seltsamerweise nicht bei jedem Seed.. UPDATE: Es ist kein Fehler am Modell selbst, sondern eher am Workflow.. Ich arbeite an einer Lösung. Wenn das passiert, versucht den ersten Upscale auf 1.14 statt 1.2 zu setzen.

Einstellungen und Workflow V2.1:

Hier findet ihr den Workflow dazu: https://civitai.com/articles/8419

Einstellungen: Anders als bei normalem Flux braucht ihr hier nicht die Flux Guidance Scale. Nutzt stattdessen den CFG Scale. Ich verwende meist 3 CFG für den Workflow.. Manche Bilder benötigen niedrigere CFG-Werte.

Das Wichtigste ist, die Flux Guidance Scale auszuschalten..

Ohne Workflow habe ich es mit 30 Schritten und 2-3 CFG getestet. Das könnte auch eine Einstellung für Forge sein. Experimentiert damit.

Ich empfehle, das Wort "blurry" in die negativen Prompts einzufügen

Sampler und Scheduler:

Ihr könnt aus einer Reihe funktionierender Sampler wählen:

Euler, Heun, DPM++2m, deis, DDIM funktionieren gut.

Ich verwende meist "simple" als Scheduler

Wenn ihr bessere Einstellungen findet, sagt Bescheid.. :-)

Für Forge empfehle ich das AIO Modell.. hier ein Beispiel für Forge-Einstellungen

Version 2.0_dev_experimental

Nun.. das ist eine experimentelle Version.. Ziel war es, ein kohärenteres und schnelleres Modell zu erschaffen. Ich habe einige zusätzliche selbst trainierte Loras integriert und die resultierenden Modelle auf eine spezielle Weise zusammengeführt (Tensor Merge). Es enthält ein kundenspezifisches T5xxl, das ich mit "Attention Seeker" modifiziert habe. Für Geschwindigkeit und zusätzliche Qualität habe ich den Hyper Flux Lora von ByteDance eingebaut. Das bedeutet, dass sich der Arbeitsbereich verschoben hat.. Ich zeige euch, was das bedeutet.. Hier ist das Haupttitelbild..

16 Schritte V 2.0

30 Schritte V 1.0

30 Schritte V 1.0

Nachteile:

Nachteile:

Zuerst: Diese Version ist etwas größer als die vorige.. Zweitens muss ich noch die Unet-only Version erstellen. Ich aktualisiere das, sobald es erledigt ist..

Einstellungen und Workflow V2.0:

Ihr könnt das Modell nun mit weniger Schritten ausführen.. 16 Schritte entsprechen 30 Schritten des alten Modells.

Ich empfehle dennoch etwa 20-30 Schritte zu verwenden, da das meist bessere Qualität liefert.

Sampler: Ich bevorzuge Euler mit Simple Scheduler. Die Guidance kann von 1.5 bis 3 eingestellt werden (ihr könnt natürlich auch außerhalb dieses Bereichs testen). Eine Guidance von 1.8 funktioniert gut für realistische Bilder. Andere Sampler wie DPM++2M und Heun funktionieren auch sehr gut.

Workflow 2.0:

Ich habe einen neuen Workflow für V2.0 und V1.0 erstellt. Dieser hat den neuen Flux Prompt Generator. Zusätzlich habe ich die zweite Upscaler-Stufe aktiviert. https://civitai.com/articles/7946

Forge:

Ich habe dieses Modell auch mit Forge getestet, und es funktionierte sehr gut.. Die Bilder können sich zwischen Comfy UI und Forge allerdings unterscheiden..

Version 1.0_dev_beta:

Dieses Modell ist mein erster Eintrag der Serie. Bitte gebt Feedback und postet Bilder. Das hilft, das Projekt weiter zu verbessern. Es gibt verschiedene Versionen zur Auswahl. Das qualitativ beste Modell ist die FP16 Version. Diese ist allerdings groß und benötigt eine starke Grafikkarte und viel RAM. Die FP8 Version ist ein guter Kompromiss zwischen Qualität und Leistung. Für eine GGUF Version ladet die Q8_0 herunter. Die GGUF Q4_0/4.1 Version wurde angefragt; sie sind klein, verlieren aber etwas Qualität.

Grundsätzlich gibt es zwei Arten Modelle: "All in One" Modelle, die nur eine Datei zum Download benötigen. Diese enthalten Clip_l, T5xxl fp8 und VAE integriert. (In euren Checkpoints-Ordner legen.)

Die anderen sind UNET-ONLY Versionen. Hier müssen alle Dateien separat geladen werden.

In jedem Fall müsst ihr meinen Clip_L herunterladen, damit diese richtig funktionieren..

Wichtig ist auch die Wahl des richtigen T5xxl Clips. Für FP8 ist das der fp8_e4m3fn t5xxl Clip. Für FP16 ist es der FP16 Clip. Achtet darauf, den Standardgewicht-Typ auszuwählen. (Unten ein Beispielbild für die FP8 Version)

Für die GGUF Version wird der GGUF Loader benötigt!

Bekannte Punkte bezüglich V1.0:

Dies ist nur das erste Modell der Serie, daher kann es bei manchen Prompts oder Stilen wie Kunst Schwierigkeiten geben. Die nächste Version erhält mehr Training. Sagt mir, was das Modell nicht kann..

Einstellungen und Workflow:

Ich habe es mit etwa 30 Schritten, Euler und Simple Scheduler getestet. Die Guidance kann von 1.5 bis 3 eingestellt werden (ihr könnt natürlich außerhalb dieses Bereichs testen).

Eine Guidance von 1.8 funktioniert gut für realistische Bilder.

Probiert diese Einstellungen aus.. Wenn ihr gute Ergebnisse erzielt, postet diese bitte.

Ich habe die Showcase-Bilder als Trainingsdaten hinzugefügt.. Darin ist der Workflow für Comfy enthalten. Hier ist der Workflow zum Download: https://civitai.com/articles/7946

"All in One" Modell:

Nur UNET:

Ihr müsst auch den Clip_L herunterladen. Die Datei ist 240MB groß.

Ihr müsst auch den Clip_L herunterladen. Die Datei ist 240MB groß.

GGUF: Ich habe den Workflow für GGUF hier hinzugefügt: https://civitai.com/articles/7946

Wichtig:

Das Dev-Modell ist nicht für kommerzielle Nutzung vorgesehen. Dafür werde ich das "schnell" Modell an einem anderen Ort veröffentlichen. Es ist eher für den persönlichen oder wissenschaftlichen Gebrauch gedacht.

LIZENZ:

https://huggingface.co/black-forest-labs/FLUX.1-dev/blob/main/LICENSE.md

Credits:

theunlikely https://huggingface.co/theunlikel (nochmals Danke)

Version 2.1/V4.2/5.0: Flux_dev_de-distill von nyanko7

https://huggingface.co/nyanko7/flux-dev-de-distill

Ab V2.0: Hyper Lora von ByteDance https://huggingface.co/ByteDance/Hyper-SD

Black Forrest für ihr großartiges Flux-Modell https://huggingface.co/black-forest-labs

Modell-Details

Modelltyp

Basismodell

Modellversion

Modell-Hash

Ersteller

Diskussion

Bitte log in um einen Kommentar zu hinterlassen.

Modellsammlung - Colossus Project Flux

Colossus Project Flux - v12_int4_SVDQ_nunchaku

Colossus Project Flux - V12 "Hephaistos" FP8_UNET

Colossus Project Flux - v10_AIO_FP8

Colossus Project Flux - v10_int4_SVDQ