SD XL - v1.0

Verwandte Schlüsselwörter & Tags

Empfohlene Parameter

resolution

Tipps

Das Modell ist für Forschungszwecke vorgesehen, einschließlich der Generierung von Kunstwerken, Bildungstools und sicherer Bereitstellung.

Es ist nicht darauf ausgelegt, faktische oder wahrheitsgetreue Darstellungen von Personen oder Ereignissen zu erzeugen.

Einschränkungen umfassen unvollkommene Fotorealität, Unfähigkeit zur Darstellung lesbaren Textes, Herausforderungen bei zusammengesetzten Prompts und mögliche falsche Gesichtsgenerierung.

Das Modell verwendet zwei vortrainierte Text-Encoder: OpenCLIP-ViT/G und CLIP-ViT/L.

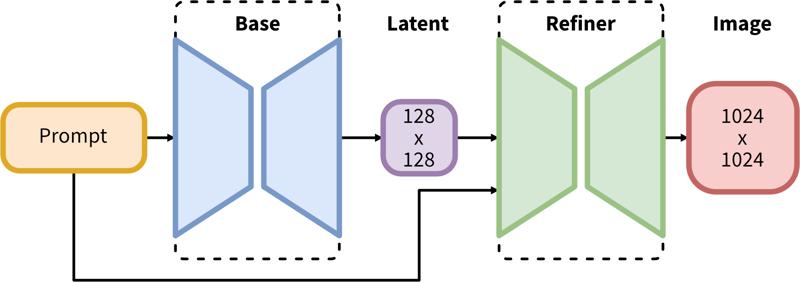

Die zweistufige Pipeline umfasst die basale Latent-Erzeugung gefolgt von einer Hochauflösungsverfeinerung mittels SDEdit (img2img).

Ersteller-Sponsoren

Ursprünglich auf Hugging Face veröffentlicht und hier mit Erlaubnis von Stability AI geteilt.

Ursprünglich auf Hugging Face veröffentlicht und hier mit Erlaubnis von Stability AI geteilt.

SDXL besteht aus einer zweistufigen Pipeline für latente Diffusion: Zuerst verwenden wir ein Basismodell, um Latents der gewünschten Ausgabengröße zu erzeugen. Im zweiten Schritt nutzen wir ein spezialisiertes Hochauflösungsmodell und wenden eine Technik namens SDEdit (https://arxiv.org/abs/2108.01073, auch bekannt als "img2img") auf die im ersten Schritt erzeugten Latents unter Verwendung desselben Prompts an.

Modellbeschreibung

Entwickelt von: Stability AI

Modelltyp: Diffusionsbasiertes Text-zu-Bild-Generativmodell

Modellbeschreibung: Dies ist ein Modell, das verwendet werden kann, um Bilder basierend auf Text-Prompts zu erzeugen und zu modifizieren. Es ist ein Latent Diffusion Model, das zwei feste, vortrainierte Text-Encoder verwendet (OpenCLIP-ViT/G und CLIP-ViT/L).

Ressourcen für weitere Informationen: GitHub Repository.

Modellquellen

Repository: https://github.com/Stability-AI/generative-models

Demo [optional]: https://clipdrop.co/stable-diffusion

Anwendungsbereiche

Direkte Verwendung

Das Modell ist ausschließlich für Forschungszwecke vorgesehen. Mögliche Forschungsgebiete und Aufgaben umfassen

Generierung von Kunstwerken und Verwendung in Design- und anderen künstlerischen Prozessen.

Anwendungen in Bildungs- oder Kreativtools.

Forschung zu generativen Modellen.

Sichere Bereitstellung von Modellen, die potenziell schädliche Inhalte erzeugen können.

Untersuchung und Verständnis der Grenzen und Verzerrungen generativer Modelle.

Ausgeschlossene Verwendungen werden unten beschrieben.

Nicht abgedeckte Verwendungen

Das Modell wurde nicht darauf trainiert, faktische oder wahrheitsgetreue Darstellungen von Personen oder Ereignissen zu erzeugen, daher liegt die Nutzung des Modells zur Erzeugung solcher Inhalte außerhalb des Anwendungsbereichs dieses Modells.

Einschränkungen und Verzerrungen

Einschränkungen

Das Modell erreicht keine perfekte Fotorealität

Das Modell kann keinen lesbaren Text darstellen

Das Modell hat Schwierigkeiten bei komplexeren Aufgaben, die Kompositionalität erfordern, wie z. B. die Darstellung eines Bildes, das „ein roter Würfel auf einer blauen Kugel“ zeigt

Gesichter und Personen im Allgemeinen werden möglicherweise nicht korrekt generiert.

Der Autoencoding-Teil des Modells ist verlustbehaftet.

Verzerrungen

Obwohl die Fähigkeiten von Bildgenerierungsmodellen beeindruckend sind, können sie soziale Vorurteile verstärken oder verschärfen.

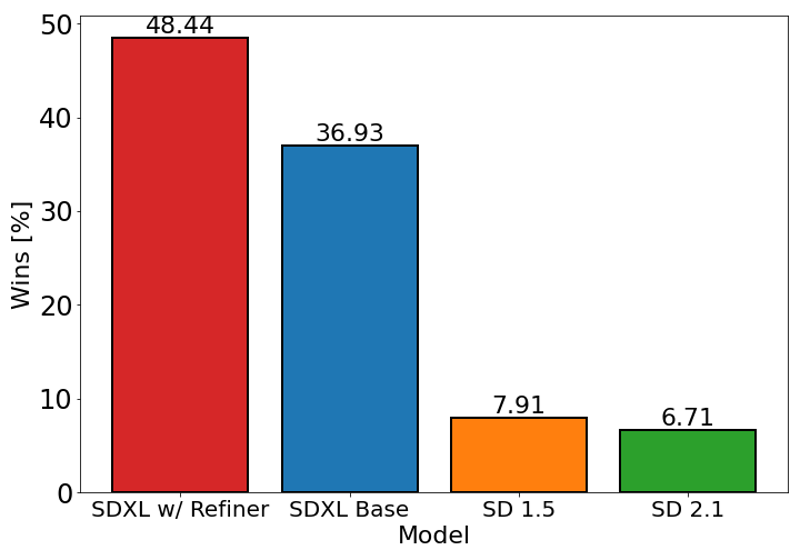

Die obige Grafik bewertet die Nutzerpräferenz für SDXL (mit und ohne Verfeinerung) gegenüber Stable Diffusion 1.5 und 2.1. Das SDXL Basismodell schneidet deutlich besser ab als die vorherigen Varianten, und das Modell in Kombination mit dem Verfeinerungsmodul erzielt die beste Gesamtleistung.

Modell-Details

Modelltyp

Basismodell

Modellversion

Modell-Hash

Diskussion

Bitte log in um einen Kommentar zu hinterlassen.