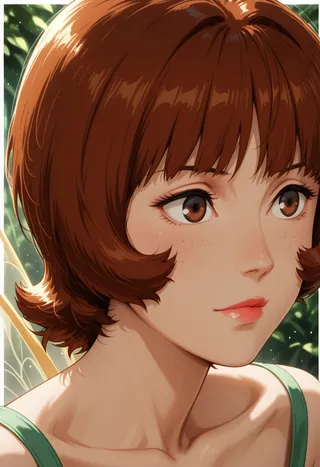

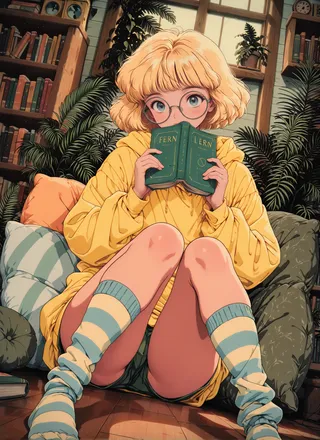

SPO-SDXL_4k-p_10ep_LoRA_webui - v1.0

Conseils

Ce modèle est un point de contrôle LoRA affiné.

L'entraînement a utilisé 4 000 prompts pendant 10 époques.

L'Optimisation des Préférences étape par étape permet des améliorations visuelles fines à chaque étape, améliorant efficacement l’esthétique.

Modèles de Diffusion Post-Entraînement Esthétiques à partir de Préférences Génériques avec Optimisation des Préférences étape par étape

Résumé

La génération d’images visuellement attrayantes est fondamentale pour les modèles modernes de génération texte-image. Une solution potentielle pour améliorer l’esthétique est l’optimisation directe des préférences (DPO), appliquée aux modèles de diffusion pour améliorer la qualité générale des images, y compris l’alignement prompt-image et l’esthétique. Les méthodes DPO populaires propagent les étiquettes de préférences de paires d’images nettes à toutes les étapes intermédiaires le long des deux trajectoires de génération. Cependant, les étiquettes de préférence fournies dans les jeux de données existants mélangent avis sur la mise en page et l’esthétique, ce qui peut être en désaccord avec la préférence esthétique. Même si des étiquettes esthétiques étaient fournies (à coût important), il serait difficile pour les méthodes à deux trajectoires de saisir les différences visuelles subtiles à différentes étapes.

Pour améliorer l’esthétique de façon économique, cet article utilise des données de préférences génériques existantes et introduit l’optimisation des préférences étape par étape (SPO) qui abandonne la stratégie de propagation et permet d’évaluer les détails fins de l’image. Plus précisément, à chaque étape de débruitage, nous 1) échantillonnons un pool de candidats en débruitant à partir d’un latent de bruit partagé, 2) utilisons un modèle de préférences sensible à l’étape pour trouver une paire gagnante-perdante adaptée supervisant le modèle de diffusion, et 3) sélectionnons aléatoirement un candidat du pool pour initialiser l’étape suivante de débruitage. Cette stratégie garantit que les modèles de diffusion se concentrent sur les différences visuelles subtiles et fines plutôt que sur l’aspect mise en page. Nous constatons que l’esthétique peut être significativement améliorée en accumulant ces différences mineures améliorées.

Lors du fine-tuning de Stable Diffusion v1.5 et SDXL, SPO produit des améliorations notables en esthétique par rapport aux méthodes DPO existantes sans sacrifier l’alignement image-texte par rapport aux modèles vanilles. De plus, SPO converge beaucoup plus rapidement que les méthodes DPO grâce à l’alignement étape par étape des détails visuels fins. Code et modèle : https://rockeycoss.github.io/spo.github.io/

Description du Modèle

Ce modèle est affiné à partir de stable-diffusion-xl-base-1.0. Il a été entraîné sur 4 000 prompts pendant 10 époques. Ce point de contrôle est un point de contrôle LoRA. Pour plus d’informations, veuillez visiter ici

Citation

Si vous trouvez notre travail utile, merci de nous attribuer une étoile et de citer notre travail.

@article{liang2024step,

title={Modèles de Diffusion Post-Entraînement Esthétiques à partir de Préférences Génériques avec Optimisation Étape par Étape des Préférences},

author={Liang, Zhanhao and Yuan, Yuhui et Gu, Shuyang et Chen, Bohan et Hang, Tiankai et Cheng, Mingxi et Li, Ji et Zheng, Liang},

journal={arXiv preprint arXiv:2406.04314},

year={2024}

}Détails du modèle

Type de modèle

Modèle de base

Version du modèle

Hash du modèle

Créateur

Discussion

Veuillez vous log in pour laisser un commentaire.