Stabilizer IL/NAI - ani40 v0.1

Mots-clés et tags associés

Prompts recommandés

<lora:ani40_stabilizer_v0.1:0.8>1girl, fox ears, upper body, masterpiece, best quality, high score, great score, [Trained by reakaakasky @civitai.com/user/reakaakasky and only published on civitai::0]

Paramètres recommandés

samplers

steps

cfg

resolution

other models

Paramètres haute résolution recommandés

upscaler

upscale

denoising strength

Conseils

Chargez d'abord le LoRA Stabilizer dans votre pile LoRA pour minimiser les changements de poids inattendus dus au poids patch dynamique de l'architecture DoRA.

Utilisez-le comme modèle de base affiné sur des modèles de base pré-entraînés (NoobAI v-pred v1.0 ou NoobAI eps v1.0) pour un meilleur détail naturel et contrôle du style.

Évitez de fusionner le LoRA Stabilizer avec d'autres modèles de base affinés déjà pollués par le style IA ou surajustés pour éviter des résultats indésirables.

Ce LoRA n'est pas un LoRA de style ; il ne fournit pas de biais de style par défaut, spécifiez donc le style via des tags ou d'autres LoRAs pour guider le modèle.

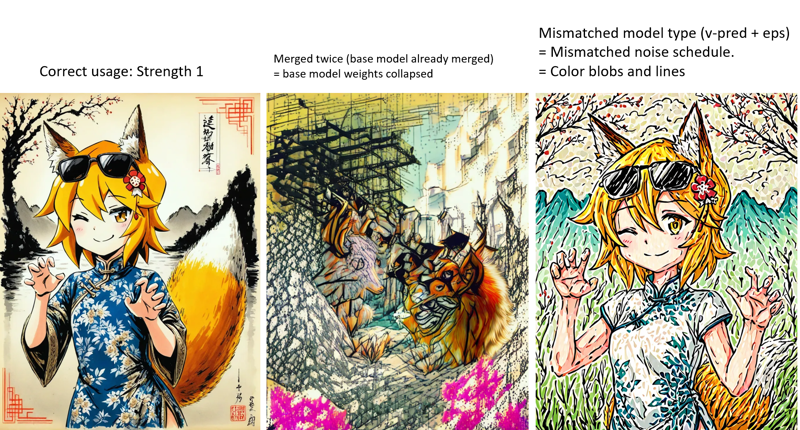

Méfiez-vous des faux modèles de base qui pourraient avoir fusionné ce LoRA deux fois, causant une dégradation du modèle et des comportements inattendus.

Utilisez des LoRAs spécialisés comme Dark, Contrast Controller et Style Strength Controller du même auteur pour des effets et contrôles d'image supplémentaires.

Sponsors du créateur

Essayez le nouveau modèle Lumina 2 avec l'architecture avancée DiT, seulement 2 milliards de paramètres, taille de modèle efficace, et un encodeur de texte supérieur (Google Gemma 2) supportant des langues variées.

- "Enhancement bundle" LoRA par l'auteur

- Accédez aux modèles Lumina 2 en ligne sur TensorArt sans installation locale.

- Accélération matérielle et optimisations : Guide Torch compile et mode FP16, TeaCache, Lightning LoRA, Modèle de base FP8 scaled.

Les images de couverture sont des sorties brutes du modèle pré-entraîné, en résolution 1MP. Ce que vous voyez est ce que vous obtenez. Il n'y a pas de mise à l'échelle, pas de retouches d'images sur les mains/visages, même pas de prompt négatif.

(21/10/2025) : Il est temps de regarder vers l'avenir...

Ce modèle ne sera pas activement mis à jour. SDXL est tout simplement trop... ancien, il a été publié il y a deux ans (juin 2023).

Pourquoi ne pas essayer de nouveaux modèles. Ils ont une architecture plus récente, de meilleures performances et peuvent être beaucoup plus efficaces. Par exemple : Lumina 2. Si vous venez d'entendre parler de Lumina 2, voici un bref aperçu :

Sorti en janvier 2025. Open source. Licence Apache 2.0.

Architecture DiT (l'archi la plus populaire actuellement, même architecture que Flux.1, etc.).

Petit et efficace. Seulement 2 milliards de paramètres. Modèle complet (fp16) de 5 Go, modèle Q8 seulement 2,5 Go, ce qui signifie que vous pouvez même le charger et l'exécuter sur une gtx1050 sans perte de qualité.

Utilise le même Flux 16ch VAE, mathématiquement 4x meilleur que le SDXL 4ch VAE.

Utilise Google Gemma 2 2b comme encodeur de texte (oui, aussi un LLM de chat entièrement fonctionnel). 10x meilleur que les anciens CLIPs dans SDXL qui ne comprenaient que les tags. En tant que LLM de chat, il comprend presque tout... anglais, chinois, japonais, fautes de frappe, argots, poésies... Par exemple vous pouvez faire cela en le promptant simplement : (Note : ceci est une image unique, pas quatre, voir l'image complète et le prompt ici, idée venant de là).

J'ai entraîné un "Enhancement bundle" LoRA. Nom changé, moins trompeur, mais le dataset est le même.

J'ai entraîné un "Enhancement bundle" LoRA. Nom changé, moins trompeur, mais le dataset est le même.

De plus, je ne pense pas que Civitai supportera Lumina 2. J'ai aussi uploadé le modèle sur TensorArt. Vous pouvez me trouver ici. Et tester les modèles Lumina 2 en ligne si vous n'avez pas d'installation locale.

Liens utiles :

Modèles :

Neta Lumina : Modèle de base, affiné dans le style anime, entraîné sur les datasets danbooru et e621.

NetaYume Lumina : Modèle de base, affiné à nouveau avec le dataset le plus récent.

Optimisations :

Accélérations matérielles : torch.compile pour les GPU récents (rtx 3xxx et plus), 30% plus rapide. Activation du mode fp16 pour les GPU plus anciens ne supportant pas bf16 (rtx 2xxx et antérieurs), 3x plus rapide, car par défaut, les anciens GPU utilisent fp32, extrêmement lent. https://civitai.com/articles/22251

TeaCache : https://github.com/spawner1145/CUI-Lumina2-TeaCache

Lightning LoRA, 2x plus rapide (expérimental) : https://civitai.com/models/2115586

Modèle de base fp8 scaled (DiT+TE), seulement 3 Go : https://civitai.com/models/2023440

Stabilizer

Qu'est-ce que c'est ?

Un modèle affiné à moyenne échelle avec 7k images.

De nombreux sous-datasets spécialisés, tels que gros plan sur vêtements, mains, éclairage ambiant complexe, arts traditionnels ...

Seulement des textures naturelles, éclairage et détails les plus fins. Pas de style IA plastique brillant. Car aucune image IA dans le dataset. J'ai sélectionné manuellement chaque image. Pas fan de l'entraînement sur images IA. C'est comme jouer au "téléphone arabe" ; entraîner une IA avec des images IA ne fait que faire perdre des informations aux images, les rendant pires (plastique, brillant).

Meilleure compréhension des prompts. Entraîné avec des légendes en langage naturel.

Concentré sur la créativité, plutôt que sur un style fixe. Le dataset est très diversifié. Donc ce modèle n'a pas de style par défaut (biais) qui limite sa créativité.

(v-pred) Éclairage meilleur et équilibré, pas de débordement ni de sursaturation. Vous voulez un noir pur 0 et un blanc pur 255 dans la même image, même au même endroit ? Pas de problème.

Pourquoi pas de style par défaut ?

Qu'est-ce que le "style par défaut" : Si un modèle a un style par défaut (biais), cela signifie que peu importe ce que vous prompt, le modèle doit générer les mêmes choses (visages, arrière-plans, sensations) qui composent le style par défaut.

Avantages : C'est facile à utiliser, vous n'avez plus besoin de prompt le style.

Inconvénients : Mais vous ne pouvez pas non plus le remplacer. Si vous demandez quelque chose qui ne correspond pas au style par défaut, le modèle l'ignorera. Si vous empilez plusieurs styles, le style par défaut va toujours chevaucher/contaminer/limiter les autres styles.

"pas de style par défaut" signifie pas de biais, et vous devez spécifier le style que vous voulez pour guider le modèle, via tags ou LoRAs. Mais il n'y aura pas de chevauchement/contamination de style venant de ce modèle. Vous obtiendrez le style que vous avez empilé exactement comme il doit être.

Effets :

Maintenant le modèle peut générer précisément le style que vous avez indiqué, plutôt qu'une image anime trop simplifiée. Pas de chevauchement/déplacement de style, pas de visages IA, seulement de meilleurs détails. Voir comparaison :

https://civitai.com/images/84145167 (styles généraux)

https://civitai.com/images/84256995 (styles artistes, remarquez le visage)

Si vous voulez savoir ce qu'est le "déplacement de style et visages IA". Voir :

ce modèle : https://civitai.com/images/107381516

autre modèle : https://civitai.com/images/107647042. visage féminin et arrière-plan brillant terrible.

Voir plus de graphes xy dans les images de couverture. Un graphe xy vaut mille mots.

Pourquoi ce "modèle de base affiné" est un LoRA ?

Je ne suis pas un gigachad et je n'ai pas des millions d'images d'entraînement. Affiner tout le modèle de base n'est pas nécessaire, un LoRA suffit.

Je dois seulement uploader, et vous devez seulement télécharger, un petit fichier de 40 Mio, au lieu d'un checkpoint gros de 7 Gio, ce qui économise 99,4 % de données et d'espace de stockage.

Donc je peux spammer les mises à jour.Ce LoRA peut paraître petit, il est toujours puissant. Car il utilise une nouvelle architecture appelée DoRA de Nvidia, plus efficace que le LoRA traditionnel.

Alors comment obtenir ce "modèle de base affiné" ?

Chargez ce LoRA sur le modèle de base pré-entraîné avec la force complète. Alors le modèle de base pré-entraîné deviendra le modèle de base affiné. Voir ci-dessous "Comment utiliser".

Le partage de merges utilisant ce modèle est interdit. Pour info, il y a des mots déclencheurs cachés pour imprimer un watermark invisible. J'ai codé moi-même le watermark et le détecteur. Je ne veux pas l'utiliser, mais je peux.

Ce modèle est uniquement publié sur Civitai et TensorArt. Si vous voyez "moi" et cette phrase sur d'autres plateformes, tous sont faux et la plateforme que vous utilisez est une plateforme pirate.

Merci de laisser vos retours dans la section commentaires. Afin que tout le monde puisse les voir. N'écrivez pas de retour dans le système d'avis Civitai, il est mal conçu, littéralement personne ne peut retrouver ni voir les avis.

Comment utiliser

Versions :

nbvp10 (pour NoobAI v-pred v1.0).

Couleurs précises et détails nets.

nbep10 (pour NoobAI eps v1.0).

Moins de saturation et de contraste comparé aux modèles v-pred. La prédiction epsilon standard limite le modèle à une gamme de couleurs plus restreinte. C'est pourquoi nous avons le v-pred plus tard.

illus01 (entraîné sur Illustrious v0.1, mais recommande toujours NoobAI eps v1.0).

Si vous utilisez ce modèle au-dessus d'un autre modèle de base affiné. Sachez que la plupart (90%) des modèles de base anime étiquetés "illustrious" de nos jours sont en fait NoobAI (ou principalement). Recommandé d'essayer les deux versions (il01 et nbep10) pour voir laquelle est la meilleure.

Chargez ce LoRA en premier dans votre pile de LoRA.

Ce LoRA utilise une nouvelle architecture appelée DoRA de Nvidia, qui est plus efficace que le LoRA traditionnel. Cependant, contrairement au LoRA traditionnel qui a un poids de patch statique, le poids de patch de DoRA est calculé dynamiquement selon le poids du modèle de base actuellement chargé (qui change lorsque vous chargez des LoRAs). Pour minimiser les changements inattendus, chargez ce LoRA en premier.

Deux façons d'utiliser ce modèle :

1). Utilisez-le comme modèle de base affiné (recommandé) :

Si vous voulez les détails naturels les plus fins et construire la combinaison de styles que vous voulez, avec un contrôle total.

Appliquez le LoRA sur le modèle de base pré-entraîné. Note : modèle pré-entraîné signifie le modèle original, non affiné. Exemples : NoobAI v-pred v1.0, NoobAI eps v1.0

2). Utilisez-le comme LoRA sur un autre modèle de base affiné.

C'est un LoRA après tout.

Mais attention :

Ce n'est pas un LoRA de style, littéralement vous allez fusionner deux modèles de base. Le résultat n'est pas toujours ce que vous souhaitez.

Il ne fonctionne pas sur les modèles hyper fusionnés pollués par style IA, type 1 fille overfit 50 versions de Nova furry 3D anime WAI ou autre. Ce modèle ne peut pas réparer ces styles IA brillants plastiques. Utilisez un modèle pré-entraîné si vous voulez vous débarrasser du style IA.

Ceci est ce que Craft Lawrence (de Spice and Wolf) devrait être, si vous avez vu l'anime : https://civitai.com/images/107381516

Ceci est ce que génèrent ces modèles pollués par style IA sur 1 fille overfit : https://civitai.com/images/107647042

FAQ :

Les images de couverture sont des sorties brutes du modèle pré-entraîné, en résolution 1MP. Il n'y a pas de plugin magique, pas de mise à l'échelle, pas de retouches sur mains/visages, même pas de prompt négatif. Certains utilisateurs disent qu'ils ne peuvent pas reproduire, c'est un problème de compétence. (Modèle de base non adapté ou trop d'"optimisations" ajoutées)

Si cela a détruit votre modèle de base même à faible force (ex. <0.5). C'est un problème avec votre modèle de base. Votre modèle de base a déjà fusionné ce LoRA (et vous l'avez fusionné deux fois). Et les poids du modèle se sont multipliés et sont effondrés. Méfiez-vous des faux créateurs de modèles de base, aka. voleurs. Certains "créateurs" ne font jamais l'entraînement, ils prennent juste les modèles des autres, les fusionnent, effacent tous les métadonnées et crédits, et les vendent comme leurs propres modèles de base.

Autres outils

Quelques idées qui allaient ou ont été partie intégrante de Stabilizer. Maintenant ce sont des LoRAs séparés. Pour une meilleure flexibilité. Lien de la collection : https://civitai.com/collections/8274233.

Dark : Un LoRA biaisé vers un environnement plus sombre. Utile pour corriger le biais de haute luminosité dans certains modèles de base. Entraîné sur des images à faible luminosité. Pas de biais de style, donc pas de pollution de style.

Contrast Controller : Un LoRA fait main. Contrôle le contraste comme en utilisant un curseur sur votre moniteur. Contrairement à d'autres "améliorateurs de contraste" entraînés, l'effet de ce LoRA est stable, linéaire mathématiquement, et n'a aucun effet secondaire sur le style.

Utile quand votre modèle de base a un problème de sursaturation, ou si vous voulez quelque chose de vraiment coloré.

Exemple :

Style Strength Controller : Ou réducteur d'effet d'overfitting. Peut réduire tous types d'effets d'overfitting (biais sur objets, luminosité, etc.), mathématiquement. Ou amplifier si vous voulez.

Différences avec Stabilizer :

Différences avec Stabilizer :

Stabilizer a été entraîné sur des données réelles. Il peut seulement "réduire" les effets d'overfitting concernant texture, détails et arrière-plans, en les réintégrant.

Style Controller n'est pas issu de l'entraînement. Il ressemble plus à un "undo" de l'entraînement pour le modèle de base, donc il sera moins surajusté. Peut réduire mathématiquement tous les effets d'overfitting, comme le biais sur la luminosité, les objets.

Anciennes versions :

Vous pouvez trouver plus d'infos dans le "journal des mises à jour". Méfiez-vous, les anciennes versions peuvent avoir des effets très différents.

Chronologie principale :

Maintenant ~ : Détails et textures naturels, compréhension stable des prompts et plus de créativité. Plus limité au style anime 2D pur.

illus01 v1.23 / nbep11 0.138 ~ : Meilleur style anime avec couleurs vives.

illus01 v1.3 / nbep11 0.58 ~ : Meilleur style anime.

Journal des mises à jour

(21/10/2025) : Noobai v-pred v0.280a

Version spéciale, "a" signifie anime. Il y a un style anime 2D par défaut. Donc ça devrait être plus facile à utiliser si vous ne voulez pas indiquer de style. Le dataset a aussi beaucoup changé, l'effet peut être assez différent de la version précédente.

(31/08/2025) NoobAI ep10 v0.273

Cette version a été entraînée depuis le début sur NoobAI eps v1.0.

Comparé à l'illus01 v1.198 précédente :

Meilleure et équilibrée luminosité en conditions extrêmes. (même effet que nbvp v0.271)

Meilleures textures et détails. Plus d'étapes d'entraînement sur des timesteps à SNR élevé. (les versions illus01 sautaient ces timesteps pour une meilleure compatibilité. Maintenant que tous les modèles de base sont NoobAI, il n'est plus nécessaire de sauter ces timesteps.)

(24/08/2025) NoobAI v-pred v0.271 :

Comparé à la version précédente v0.264 :

Meilleur éclairage équilibré en conditions extrêmes, moins de biais.

Contraste élevé, noir pur 0 et blanc pur 255 dans la même image, même au même endroit, sans débordement ni sursaturation. Maintenant vous pouvez avoir tous ces éléments à la fois.

(la vieille v0.264 essayait de restreindre l'image entre 10~250 pour éviter les débordements, mais avait encore des problèmes de biais, l'image globale pouvait être trop sombre ou claire)

Comme pour v0.264, préférez une force élevée ou maximale (0.9~1).

(17/08/2025) NoobAI v-pred v0.264 :

Première version entraînée sur NoobAI v-pred.

Elle apporte un meilleur éclairage, moins de débordements.

Note : préférez une force élevée ou maximale (0.9~1).

(28/07/2025) illus01 v1.198

Principalement comparé à v1.185c :

Fin de la version "c". Bien que "visuellement frappante" soit bien, elle posait des problèmes de compatibilité. Par exemple quand votre modèle de base a déjà un renforcement du contraste similaire. Empiler deux améliorations de contraste est vraiment mauvais. Donc, plus d'effets post-traitement extrêmes (contraste et saturation élevés, etc.).

À la place, plus de textures et détails. Éclairage de niveau cinématographique. Meilleure compatibilité.

Cette version a beaucoup changé, y compris une refonte du dataset, donc l'effet sera assez différent des versions précédentes.

Pour ceux qui veulent récupérer les effets fous de v1.185c, vous pouvez trouver des styles d'art purs et dédiés sur cette page. Si le dataset est assez grand pour un LoRA, je pourrais en entraîner un.

(21/06/2025) illus01 v1.185c :

Comparé à v1.165c.

+100% de netteté et clarté.

-30% d'images trop chaotiques (difficiles à décrire). Vous constaterez que cette version ne produit plus de niveaux de contraste extrêmes, mais devrait être plus stable dans les cas d'utilisation normaux.

(10/06/2025) : illus01 v1.165c

Version spéciale. Ce n'est pas une amélioration de v1.164. "c" signifie "coloré", "créatif", parfois "chaotique".

Le dataset contient des images très visuellement frappantes, mais parfois difficiles à décrire, ex. : Très colorées. Contrastes élevés. Conditions d'éclairage complexes. Objets, motifs complexes partout.

Vous aurez donc un rendu "visuellement frappant", au prix d'un côté "naturel". Peut affecter les styles avec des couleurs douces, etc. Par exemple cette version ne peut pas générer parfaitement une texture "dessin au crayon" comme v1.164.

(04/06/2025) : illus01 v1.164

Meilleure compréhension des prompts. Maintenant chaque image a 3 légendes naturelles, sous différents angles. Les tags Danbooru sont vérifiés par un LLM, seuls les tags importants sont sélectionnés et fusionnés dans la légende naturelle.

Anti surexposition. Ajout d'un biais pour empêcher le modèle de produire du blanc pur #ffffff. Le blanc pur est souvent synonyme de surexposition, perte de détails.

Changement de certains réglages d'entraînement. Meilleure compatibilité avec NoobAI, à la fois e-pred et v-pred.

(19/05/2025) : illus01 v1.152

Continuité dans l'amélioration de l'éclairage, textures et détails.

5000 images supplémentaires, plus d'étapes d'entraînement, résultant en un effet renforcé.

(09/05/2025) : nbep11 v0.205 :

Correction rapide des problèmes de luminosité et couleur dans la v0.198. Maintenant ça ne devrait plus changer dramatiquement la luminosité et les couleurs comme une vraie photo. La v0.198 n'était pas mauvaise, juste trop créative.

(07/05/2025) : nbep11 v0.198 :

Ajout d'images sombres. Moins de corps déformés, arrière-plan en environnement sombre.

Suppression de l'amélioration de couleur et contraste. Plus nécessaire. Utilisez Contrast Controller à la place.

(25/04/2025) : nbep11 v0.172.

Mêmes nouveautés que illus01 v1.93 ~ v1.121. Résumé : Nouveau dataset photo "Touching Grass". Meilleure texture naturelle, arrière-plan, éclairage. Effets de personnage moins prononcés pour meilleure compatibilité.

Meilleure précision et stabilité des couleurs. (Comparé à nbep11 v0.160)

(17/04/2025) : illus01 v1.121.

Retour à illustrious v0.1. Les versions illustrious v1.0 et plus récentes ont été entraînées avec délibérément des images IA (peut-être 30% du dataset). Ce qui est mauvais pour l'entraînement de LoRA. Je ne l'avais pas remarqué jusqu'à la lecture du papier.

Effet de style de personnage moindre. Retour au niveau v1.23. Les personnages auront moins de détails avec ce LoRA, mais meilleure compatibilité. C'est un compromis.

Autres éléments identiques à la version ci-dessous (v1.113).

(10/04/2025) : illus11 v1.113 ❌.

Mise à jour : n'utilisez cette version que si vous savez que votre modèle de base est basé sur Illustrious v1.1. Sinon, utilisez illus01 v1.121.

Entraîné sur Illustrious v1.1.

Nouveau dataset "Touching Grass" ajouté. Meilleure texture naturelle, éclairage et profondeur de champ. Meilleure stabilité structurale en arrière-plan. Moins d'arrière-plan déformé, comme pièces, bâtiments déformés.

Légendes complètes en langage naturel issues du LLM.

(30/03/2025) : illus01 v1.93.

v1.72 était trop fortement entraîné. J'ai donc réduit sa force globale. Devrait avoir une meilleure compatibilité.

(22/03/2025) : nbep11 v0.160.

Mêmes éléments que dans illus v1.72.

(15/03/2025) illus01 v1.72

Même nouveau dataset texture et éclairage mentionné dans ani40z v0.4 ci-dessous. Éclairage et textures plus naturels.

Ajout d'un petit dataset d'environ 100 images pour amélioration des mains, focalisé sur les mains avec diverses tâches, comme tenir un verre ou une tasse.

Suppression de toutes les images à "arrière-plan simple" du dataset. -200 images.

Changement de l'outil d'entraînement de kohya à onetrainer. Changement de l'architecture LoRA à DoRA.

(04/03/2025) ani40z v0.4

Entraîné sur Animagine XL 4.0 ani40zero.

Ajout d'environ 1k images axées sur éclairage dynamique naturel et textures réelles.

Plus d'éclairage naturel et de textures naturelles.

ani04 v0.1

Version initiale pour Animagine XL 4.0. Principalement pour corriger les problèmes de luminosité d'Animagine 4.0. Meilleur et plus fort contraste.

illus01 v1.23

nbep11 v0.138

Ajout de quelques images furry/non-humaines/autres pour équilibrer le dataset.

nbep11 v0.129

Mauvaise version, effet trop faible, ignorez-la.

nbep11 v0.114

Mise en œuvre des "couleurs à gamme complète". Cela équilibre automatiquement les choses vers le "normal et beau". Pensez à cela comme au bouton "auto amélioration photo" dans la plupart des outils de retouche photo. Un inconvénient : empêche les biais élevés. Par ex. vous voulez que 95% de l'image soit noire, et 5% brillante, au lieu de 50/50%.

Ajout de données un peu plus réalistes. Détails plus vifs, éclairage, couleurs moins plates.

illus01 v1.7

nbep11 v0.96

Plus d'images d'entraînement.

Puis affiné à nouveau sur un petit dataset "wallpaper" (fonds d'écran de vrais jeux, la meilleure qualité que j'ai pu trouver. ~100 images). Améliorations sur les détails (notamment peau, cheveux) et le contraste.

nbep11 v0.58

Plus d'images. Changement de paramètres d'entraînement le plus proche possible du modèle de base NoobAI.

illus01 v1.3

nbep11 v0.30

Plus d'images.

nbep11 v0.11 : Entraîné sur NoobAI epsilon pred v1.1.

Amélioration des tags du dataset. Amélioration de la structure LoRA et de la distribution des poids. Devrait être plus stable et avoir moins d'impact sur la composition de l'image.

illus01 v1.1

Entraîné sur illustriousXL v0.1.

nbep10 v0.10

Entraîné sur NoobAI epsilon pred v1.0.

Détails du modèle

Type de modèle

Modèle de base

Version du modèle

Hash du modèle

Créateur

Discussion

Veuillez vous log in pour laisser un commentaire.

Collection de modèles - Stabilizer IL/NAI

Stabilizer IL/NAI - illus01 v1.23

Stabilizer IL/NAI - illus01 v1.121

Stabilizer IL/NAI - illus01 v1.185c

Stabilizer IL/NAI - nbep11 v0.138

Stabilizer IL/NAI - illus01 v1.152

Stabilizer IL/NAI - illus01 v1.165c

Stabilizer IL/NAI - nbep11 v0.205

Stabilizer IL/NAI - illus01 v1.72

Stabilizer IL/NAI - illus01 v1.198

Stabilizer IL/NAI - nbep11 v0.114