Stabilizer IL/NAI - ani40 v0.1

Parole Chiave e Tag Correlati

Prompt Consigliati

<lora:ani40_stabilizer_v0.1:0.8>1girl, fox ears, upper body, masterpiece, best quality, high score, great score, [Trained by reakaakasky @civitai.com/user/reakaakasky and only published on civitai::0]

Parametri Consigliati

samplers

steps

cfg

resolution

other models

Parametri Consigliati per Alta Risoluzione

upscaler

upscale

denoising strength

Suggerimenti

Carica prima lo Stabilizer LoRA nella tua pila di LoRA per minimizzare cambiamenti di peso inattesi dovuti al peso dinamico dell'architettura DoRA.

Usalo come modello base fine-tuned sopra modelli pretrained (NoobAI v-pred v1.0 o NoobAI eps v1.0) per il miglior controllo di dettagli naturali e stile.

Evita di unire Stabilizer LoRA con altri modelli base già fine-tuned che hanno inquinamento di stile AI o overfitting per prevenire risultati indesiderati.

Questa LoRA non è una LoRA di stile; non fornisce bias di stile predefinito, quindi specifica lo stile tramite tag o altre LoRA per guidare il modello.

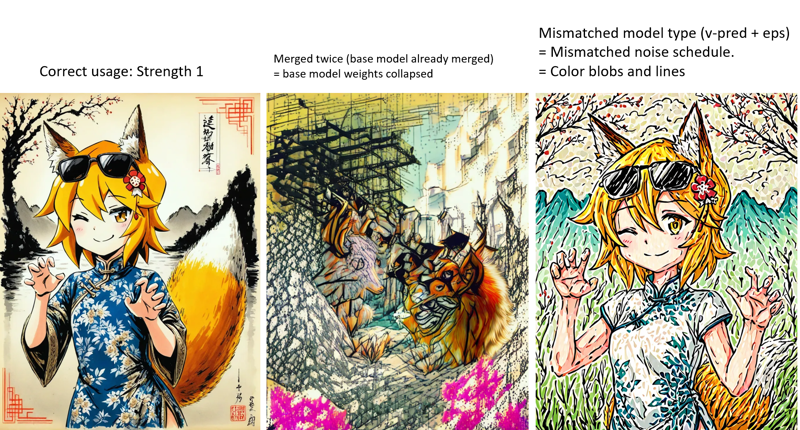

Attenzione a modelli base falsi che potrebbero aver unito questa LoRA due volte, causando degrado del modello e comportamenti inaspettati.

Usa LoRA specializzate come Dark, Contrast Controller e Style Strength Controller dello stesso autore per ulteriori effetti e controlli sull'immagine.

Sponsor del Creatore

Prova il nuovo modello Lumina 2 con architettura DiT avanzata, solo 2B parametri, dimensione modello efficiente e text encoder superiore (Google Gemma 2) che supporta lingue versatili.

- "Enhancement bundle" LoRA dell'autore

- Accedi ai modelli Lumina 2 online su TensorArt senza setup locale.

- Accelerazione hardware e ottimizzazioni: Guida Torch compile e modalità FP16, TeaCache, Lightning LoRA, Modello base scaled FP8.

Le immagini di copertina sono il output grezzo dal modello pretrained, a risoluzione 1MP. Quello che vedi è ciò che ottieni. Non c'è upscaling, né correzioni di mani/volti con inpainting, neppure prompt negativi.

(21/10/2025): È ora di guardare avanti...

Questo modello non sarà aggiornato attivamente. SDXL è ormai troppo... vecchio, è stato rilasciato due anni fa (giugno 2023).

Perché non provare nuovi modelli? Hanno architetture più recenti, prestazioni migliori e possono essere molto più efficienti. Per esempio: Lumina 2. Se hai appena sentito parlare di Lumina 2, ecco alcune info rapide:

Rilasciato a gennaio 2025. Open source. Licenza Apache 2.0.

Architettura DiT (l'architettura più popolare al giorno d'oggi, la stessa di Flux.1 ecc.).

Piccolo ed efficiente. Solo 2B parametri. Modello completo (fp16) 5GB, modello Q8 solo 2.5GB, quindi puoi anche caricarlo ed eseguirlo su una GTX1050 senza perdita di qualità.

Usa lo stesso Flux 16ch VAE, matematicamente 4 volte migliore del SDXL 4ch VAE.

Usa Google Gemma 2 2b come text encoder (sì, anche un LLM di chat completamente funzionale). 10 volte meglio dei vecchi CLIP in SDXL che possono solo capire tag. Come chat LLM capisce quasi tutto... inglese, cinese, giapponese, errori di battitura, slang, poesie... Per esempio puoi fare così semplicemente promptando: (Nota: questa è una singola immagine, non quattro, vedi immagine completa e prompt qui, idea presa da qui).

Ho addestrato un "Enhancement bundle" LoRA. Nome cambiato, meno fuorviante, ma il dataset è lo stesso.

Ho addestrato un "Enhancement bundle" LoRA. Nome cambiato, meno fuorviante, ma il dataset è lo stesso.

Inoltre, non credo che Civitai supporterà Lumina 2. Ho anche caricato il modello su TensorArt. Puoi trovarmi su qui. E prova i modelli Lumina 2 online se non hai un setup locale.

Link utili:

Modelli:

Neta Lumina: Modello base, fine-tuned in stile anime addestrato su dataset danbooru ed e621.

NetaYume Lumina: Modello base, ulteriormente fine-tuned con dataset più recente.

Ottimizzazioni:

Accelerazioni hardware: torch.compile per GPU più recenti (rtx 3xxx e successive), 30% più veloce. Abilita modalità fp16 per GPU vecchie senza supporto bf16 (rtx 2xxx e precedenti), 3 volte più veloce, poiché di default le GPU vecchie usano fp32, molto lento. https://civitai.com/articles/22251

TeaCache: https://github.com/spawner1145/CUI-Lumina2-TeaCache

Lightning LoRA, 2 volte più veloce (sperimentale): https://civitai.com/models/2115586

Modello base scaled fp8 (DiT+TE), solo 3GB: https://civitai.com/models/2023440

Stabilizer

Cos'è?

Un modello fine-tuned su scala media con 7k immagini.

Molti sottodataset specializzati, come abbigliamento in primo piano, mani, illuminazione ambientale complessa, arti tradizionali ...

Solo texture naturali, illuminazione e dettagli più fini. Nessuno stile plastico lucido tipico AI. Perché nel dataset non ci sono immagini AI. Ho selezionato manualmente ogni singola immagine. Non sono un fan dell'addestrare con immagini AI. È come giocare al "telefono senza fili"; addestrare AI con immagini AI causa solo perdita d'informazioni, rendendo le immagini peggiori (plastiche, lucide).

Migliore comprensione del prompt. Addestrato con didascalie in linguaggio naturale.

Focus sulla creatività, non uno stile fisso. Il dataset è molto vario. Quindi questo modello non ha uno stile predefinito (bias) che limiti la creatività.

(v-pred) Illuminazione migliore e bilanciata, senza traboccamenti o eccessi di saturazione. Vuoi nero puro 0 e bianco 255 nella stessa immagine, anche nello stesso punto? Nessun problema.

Perché nessuno stile predefinito?

Cosa significa "stile predefinito": se un modello ha uno stile predefinito (bias), vuol dire che qualsiasi prompt usi, il modello genererà sempre le stesse cose (volti, sfondi, atmosfera) che definiscono quello stile.

Pro: è facile da usare, non devi più specificare lo stile.

Contro: non puoi neanche sovrascriverlo. Se dai un prompt che non si adatta allo stile predefinito, il modello lo ignorerà. Se aggiungi più stili, lo stile predefinito prevarrà/sovrapporrà/inquinerà gli altri stili.

"Nessuno stile predefinito" significa nessun bias, e devi specificare lo stile che vuoi per guidare il modello, tramite tag o LoRA. Ma non ci sarà inquinamento o sovrapposizione da questo modello. Ottieni esattamente lo stile che hai costruito.

Effetti:

Ora il modello può generare accuratamente lo stile richiesto, non più immagini anime semplificate. Niente sovrapposizioni o cambiamenti di stile, niente volti AI, solo dettagli migliori. Vedi confronto:

https://civitai.com/images/84145167 (stili generali)

https://civitai.com/images/84256995 (stili artistici, nota il volto)

Se vuoi sapere cosa sono "cambiamenti di stile e volti AI". Vedi:

questo modello: https://civitai.com/images/107381516

altro modello: https://civitai.com/images/107647042. volto femminile e sfondo lucido terribile.

Guarda più grafici xy nelle immagini di copertina. Un grafico xy vale più di mille parole.

Perché questo "modello base fine-tuned" è un LoRA?

Non sono un gigachad e non ho milioni di immagini per addestramento. Non è necessario fine-tunare tutto il modello base, un LoRA basta.

Devo solo caricare un piccolo file da 40MiB, e tu devi solo scaricarlo, invece che un checkpoint grosso 7GiB, risparmiando il 99,4% di dati e spazio.

Così posso aggiornare spesso.Questo LoRA può sembrare piccolo, ma è potente. Perché usa una nuova architettura chiamata DoRA di Nvidia, più efficiente dei tradizionali LoRA.

Come ottengo questo "modello base fine-tuned"?

Carica questo LoRA sul modello base pretrained a piena forza. Allora il modello base pretrained diventerà il modello base fine-tuned. Vedi sotto "Come usare".

È proibito condividere merge che usano questo modello. Per tua informazione, ci sono parole trigger nascoste per stampare watermark invisibile. Io ho programmato io stesso il watermark e il rilevatore. Non voglio usarli, ma posso.

Questo modello è pubblicato solo su Civitai e TensorArt. Se vedi "me" e questa frase su altre piattaforme, sono falsi e quella piattaforma è pirata.

Per favore lascia un feedback nei commenti. Così tutti possono vederlo. Non scrivere feedback nel sistema recensioni di Civitai, è mal progettato, praticamente nessuno trova e vede le recensioni.

Come usare

Versioni:

nbvp10 (per NoobAI v-pred v1.0).

Colori accurati e dettagli nitidi.

nbep10 (per NoobAI eps v1.0).

Meno saturazione e contrasto rispetto ai modelli v-pred. La predizione epsilon standard limita il modello nell'espandere la gamma colori. Per questo abbiamo v-pred dopo.

illus01 (addestrato su Illustrious v0.1, ma si consiglia ancora NoobAI eps v1.0).

Se usi questo modello sopra altri modelli base fine-tuned. Attenzione che la maggior parte (90%) dei modelli base anime etichettati "illustrious" sono in realtà NoobAI (o principalmente). Raccomandato provare entrambe le versioni (il01 e nbep10) per vedere quale è migliore.

Carica prima questo LoRA nella tua pila di LoRA.

Questo LoRA usa una nuova architettura chiamata DoRA di Nvidia, più efficiente della LoRA tradizionale. Però, a differenza della LoRA tradizionale che ha un peso statica di patch, il peso della patch di DoRA è calcolato dinamicamente in base al peso del modello base caricato (che cambia quando carichi altre LoRA). Per minimizzare cambiamenti inaspettati, carica questo LoRA per primo.

Due modi di usare questo modello:

1). Usalo come modello base fine-tuned (Raccomandato):

Se vuoi i dettagli più fini e naturali e costruire la combinazione di stili che vuoi, con pieno controllo.

Applica la LoRA sopra al modello base pretrained. Nota: modello pretrained significa modello originale, senza fine-tuning. Esempio: NoobAI v-pred v1.0, NoobAI eps v1.0

2). Usalo come LoRA su altri modelli base fine-tuned.

È comunque una LoRA.

Ma attenzione:

Non è una LoRA di stile, praticamente stai unendo due modelli base. Il risultato non è sempre quello che vuoi.

Non funziona su modelli iper-merged sovraccarichi di stile AI o overfitting su 1girl di Nova furry 3D anime WAI o simili. Questo modello non può correggere quello stile plastico lucido creativo AI. Usa un modello base pretrained se vuoi eliminare lo stile AI.

Questo è quello che Craft Lawrence (da Spice and Wolf) dovrebbe essere, se hai visto l'anime: https://civitai.com/images/107381516

Questo è quello che i modelli sovraccarichi di stile AI hanno generato: https://civitai.com/images/107647042

FAQ:

Le immagini di copertina sono output grezzi dal modello pretrained, a risoluzione 1MP. Non ci sono plugin magici, né upscaling, né correzioni manos/volti con inpainting, neppure prompt negativi. Alcuni utenti dicono di non riuscire a replicare, è problema di abilità. (Modello base non corrispondente o troppe "ottimizzazioni" aggiunte)

Se ha distrutto il tuo modello base anche a bassa forza (es. <0.5). È un problema del tuo modello base. Il tuo modello base ha già unito questa LoRA (e l'hai unita due volte). I pesi del modello si sono moltiplicati e hanno collassato. Attenzione a creatori di modelli falsi, ovvero ladri. Alcuni "creatori" non fanno addestramento, prendono modelli altrui, li uniscono, cancellano tutti i metadati e crediti e li vendono come propri modelli base.

Altri strumenti

Alcune idee che stavano per o sono state parte dello Stabilizer. Ora sono LoRA separati. Per maggiore flessibilità. Link alla collezione: https://civitai.com/collections/8274233.

Dark: Una LoRA bias verso ambienti più scuri. Utile per correggere la tendenza ad alta luminosità in alcuni modelli base. Addestrata su immagini a bassa luminosità. Nessun bias di stile, quindi niente inquinamento di stile.

Contrast Controller: Una LoRA artigianale. Controlla il contrasto come uno slider sul monitor. A differenza di altri "potenziatori di contrasto" addestrati, l'effetto di questa LoRA è stabile, linearmente matematico e senza effetti collaterali sullo stile.

Utile quando il modello base ha problemi di sovrasaturazione o vuoi qualcosa di molto colorato.

Esempio:

Style Strength Controller: O riduttore di effetti da overfitting. Può ridurre ogni tipo di effetto da overfitting (bias su oggetti, luminosità, ecc.), matematicamente. Oppure amplificarlo, se vuoi.

Differenze con Stabilizer:

Differenze con Stabilizer:

Stabilizer è addestrato su dati reali. Può solo "ridurre" effetti di overfitting su texture, dettagli e sfondi, aggiungendoli indietro.

Style Controller non viene dall'addestramento. È più come "annullare" l'addestramento del modello base, così sarà meno overfitted. Può ridurre matematicamente tutti gli effetti da overfitting, come bias su luminosità, oggetti.

Versioni vecchie:

Puoi trovare più info nel "registro aggiornamenti". Attenzione, le versioni vecchie possono avere effetti molto diversi.

Linea temporale principale:

Ora ~: Dettagli e texture naturali, comprensione stabile del prompt e maggiore creatività. Non più limitato allo stile anime 2D puro.

illus01 v1.23 / nbep11 0.138 ~: Stile anime migliorato con colori vividi.

illus01 v1.3 / nbep11 0.58 ~: Miglior stile anime.

Registro aggiornamenti

(21/10/2025): Noobai v-pred v0.280a

Versione speciale, "a" significa anime. C'è uno stile anime 2D predefinito. Quindi dovrebbe essere più facile da usare se non vuoi dare prompt di stile. Anche il dataset è cambiato molto, l'effetto può essere diverso dalla versione precedente.

(31/08/2025) NoobAI ep10 v0.273

Questa versione è addestrata da zero su NoobAI eps v1.0.

Rispetto a illus01 v1.198 precedente:

Illuminazione migliore e bilanciata in condizioni estreme. (come nbvp v0.271)

Texture e dettagli migliori. Ha più passi di addestramento su timestep ad alto SNR. (le versioni illus01 saltavano questi timestep per compatibilità. Ora che tutti i modelli base sono NoobAI non serve più saltarli.)

(24/08/2025) NoobAI v-pred v0.271:

Rispetto a v0.264 precedente:

Illuminazione migliore e bilanciata in condizioni estreme, meno bias.

Alto contrasto, nero puro 0 e bianco 255 nella stessa immagine e posizione, senza traboccamenti o sovrasaturazione. Ora puoi avere tutto assieme.

(la vecchia v0.264 cercava di limitare l'immagine tra 10~250 per evitare traboccamenti, ma aveva ancora problemi di bias, immagine complessivamente troppo scura o chiara)

Come v0.264, si preferiscono valori di forza alti o pieni (0.9~1).

(17/08/2025) NoobAI v-pred v0.264:

Prima versione addestrata su NoobAI v-pred.

Offre illuminazione migliore, meno traboccamenti.

Nota: si preferisce forza alta o piena (0.9~1).

(28/07/2025) illus01 v1.198

Principalmente rispetto a v1.185c:

Fine della versione "c". Sebbene "visivamente impressionante" fosse buono, aveva problemi di compatibilità. Es. se il tuo modello base ha già miglioramenti di contrasto simili. Sovrapporre due potenziamenti di contrasto è molto negativo. Quindi, niente più effetti post-crazies (contrasto e saturazione alta, ecc.).

Invece, più texture e dettagli. Illuminazione cinematografica. Maggiore compatibilità.

Questa versione ha cambiato molte cose, incluso il rinnovamento del dataset, quindi l'effetto sarà diverso dalle versioni precedenti.

Per chi vuole gli effetti "crazy" di v1.185c indietro, puoi trovare stili artistici puri e dedicati in questa pagina. Se il dataset è abbastanza grande per un LoRA, potrei addestrarne uno.

(21/06/2025) illus01 v1.185c:

Rispetto a v1.165c.

+100% chiarezza e nitidezza.

-30% immagini troppo caotiche (impossibile descrivere bene). Quindi potresti notare che questa versione non dà più contrasti estremi, ma è più stabile negli usi normali.

(10/06/2025): illus01 v1.165c

Versione speciale. Non è un miglioramento di v1.164. "c" sta per "colorato", "creativo", a volte "caotico".

Il dataset contiene immagini molto visivamente impressionanti, ma a volte difficili da descrivere, es.: molto colorate, alto contrasto, illuminazione complessa, oggetti e pattern ovunque.

Quindi avrai immagini "visivamente impressionanti" ma a costo di "naturalezza". Può influenzare stili con colori delicati, ecc. Es. questa versione non può generare la texture "arte a matita" perfettamente come v1.164.

(04/06/2025): illus01 v1.164

Migliore comprensione del prompt. Ora ogni immagine ha 3 didascalie naturali da prospettive diverse. I tag danbooru sono controllati da LLM, solo quelli importanti sono estratti e integrati nel testo naturale.

Anti-sovraesposizione. Aggiunto bias per prevenire output a #ffffff bianco puro. Nella maggior parte dei casi #ffffff = sovraesposizione, che fa perdere dettagli.

Cambiati parametri di addestramento. Più compatibile con NoobAI, sia e-pred che v-pred.

(19/05/2025): illus01 v1.152

Continua miglioramento di illuminazione, texture e dettagli.

5k immagini in più, più passi di addestramento, quindi effetto più forte.

(09/05/2025): nbep11 v0.205:

Correzione rapida di problemi di luminosità e colore in v0.198. Ora non dovrebbe cambiare luminosità e colori in modo così drammatico come una foto reale. v0.198 non è male, solo troppo creativa.

(07/05/2025): nbep11 v0.198:

Aggiunte più immagini scure. Meno corpi deformati, sfondo in ambienti bui.

Rimosso potenziamento di colore e contrasto. Non serve più. Usa Contrast Controller invece.

(25/04/2025): nbep11 v0.172.

Stessi nuovi elementi in illus01 v1.93 ~ v1.121. Riepilogo: nuovo dataset fotografico "Touching Grass". Migliori texture naturali, sfondo, illuminazione. Effetti minori su personaggi per compatibilità.

Migliore accuratezza e stabilità del colore. (Rispetto a nbep11 v0.160)

(17/04/2025): illus01 v1.121.

Tornato a illustrious v0.1. illustrious v1.0 e versioni successive sono state addestrate con immagini AI volutamente (forse 30% del dataset). Non ideale per training LoRA. Non me ne ero accorto finché non ho letto il paper.

Effetto stile minore sui personaggi. Tornato al livello di v1.23. I personaggi avranno meno dettagli da questa LoRA, ma migliore compatibilità. È un compromesso.

Altre cose uguali a sotto (v1.113).

(10/04/2025): illus11 v1.113 ❌.

Aggiornamento: usa questa versione solo se il tuo modello base è basato su Illustrious v1.1. Altrimenti, usa illus01 v1.121.

Addestrato su Illustrious v1.1.

Aggiunto nuovo dataset "Touching Grass". Migliori texture naturali, illuminazione ed effetto profondità di campo. Maggiore stabilità strutturale dello sfondo. Meno sfondi deformati, come stanze o edifici deformati.

Didascalie in linguaggio naturale generate da LLM.

(30/03/2025): illus01 v1.93.

v1.72 era addestrato troppo. Ho quindi ridotto la forza complessiva. Dovrebbe avere migliore compatibilità.

(22/03/2025): nbep11 v0.160.

Stesse cose in illus v1.72.

(15/03/2025): illus01 v1.72

Stesso nuovo dataset di texture e illuminazione menzionato in ani40z v0.4 sotto. Più illuminazione naturale e texture naturali.

Aggiunto piccolo dataset ~100 immagini per miglioramento mani, focalizzato su mano/e con diversi compiti, come tenere bicchiere o tazza o altro.

Rimossi tutti i dati con "sfondo semplice" dal dataset. -200 immagini.

Switch da tool di addestramento kohya a onetrainer. Cambiata architettura LoRA a DoRA.

(04/03/2025) ani40z v0.4

Addestrato su Animagine XL 4.0 ani40zero.

Aggiunto ~1k dataset focalizzato su illuminazione dinamica naturale e texture reali.

Più illuminazione naturale e texture naturali.

ani04 v0.1

Versione iniziale per Animagine XL 4.0. Principalmente per correggere problemi di luminosità di Animagine 4.0. Migliore e contrasto più alto.

illus01 v1.23

nbep11 v0.138

Aggiunte immagini furry/non umane/altre per bilanciare il dataset.

nbep11 v0.129

Versione cattiva, effetto troppo debole, ignorala.

nbep11 v0.114

Implementato "colori a gamma completa". Bilancerà automaticamente le cose verso "normale e bello da vedere". Pensa a questo come al pulsante "auto enhance foto con un click" nei software di fotoritocco. Un lato negativo: impedisce bias forte. Es. vuoi il 95% immagine nera e 5% luminosa, invece di 50/50%.

Aggiunti dati un po' realistici. Dettagli più vividi, illuminazione, colori meno piatti.

illus01 v1.7

nbep11 v0.96

Più immagini per addestramento.

Poi fine-tuning su piccolo dataset "wallpaper" (wallpaper di giochi reali, massima qualità trovata. ~100 immagini). Migliorato dettagli (notabile su pelle e capelli) e contrasto.

nbep11 v0.58

Più immagini. Modificati parametri d'addestramento più vicini al modello base NoobAI.

illus01 v1.3

nbep11 v0.30

Più immagini.

nbep11 v0.11: Addestrato su NoobAI epsilon pred v1.1.

Tag del dataset migliorati. Struttura e distribuzione del peso LoRA migliorati. Più stabile e meno impatto sulla composizione immagine.

illus01 v1.1

Addestrato su illustriousXL v0.1.

nbep10 v0.10

Addestrato su NoobAI epsilon pred v1.0.

Dettagli del Modello

Tipo di modello

Modello base

Versione del modello

Hash del modello

Creatore

Discussione

Per favore log in per lasciare un commento.

Collezione di Modelli - Stabilizer IL/NAI

Stabilizer IL/NAI - illus01 v1.23

Stabilizer IL/NAI - illus01 v1.121

Stabilizer IL/NAI - illus01 v1.185c

Stabilizer IL/NAI - nbep11 v0.138

Stabilizer IL/NAI - illus01 v1.152

Stabilizer IL/NAI - illus01 v1.165c

Stabilizer IL/NAI - nbep11 v0.205

Stabilizer IL/NAI - illus01 v1.72

Stabilizer IL/NAI - illus01 v1.198

Stabilizer IL/NAI - nbep11 v0.114