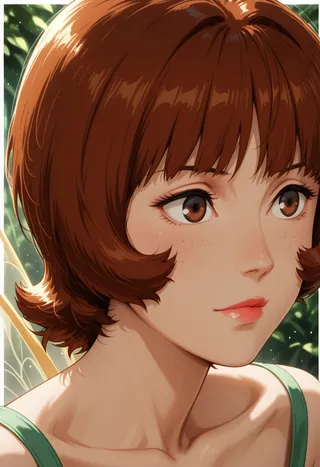

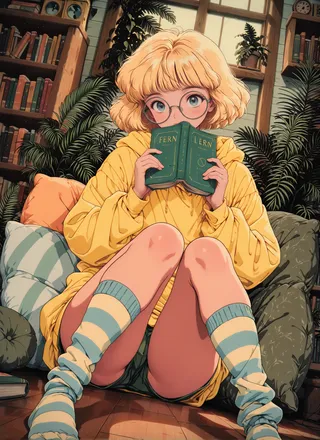

SPO-SDXL_4k-p_10ep_LoRA_webui - v1.0

ヒント

このモデルはLoRAで微調整されたチェックポイントです。

訓練では4,000のプロンプトを10エポック使用しました。

Step-by-step Preference Optimizationにより各ステップでの細かな視覚的改善が可能となり、美的感覚を効果的に向上させます。

Step-by-step Preferenceによる一般的な好みからの美的ポストトレーニングDiffusionモデル

概要

視覚的に魅力的な画像の生成は現代のテキストから画像への生成モデルの基本です。美的感覚を向上させる潜在的な解決策は直接的好み最適化(DPO)であり、これはプロンプトの整合性や美的感覚を含む一般的な画像品質を改善するためにDiffusionモデルに適用されています。一般的なDPO手法は、きれいな画像ペアからの好みラベルを2つの生成経路のすべての中間ステップに伝播させます。しかし、既存のデータセットで提供される好みラベルはレイアウトや美的意見と混ざり合っており、美的好みと矛盾する場合があります。たとえ美的ラベルが提供されていても(かなりのコストをかけて)、2経路手法では異なるステップでの微妙な視覚差異を捉えることは困難です。

美的感覚を経済的に改善するために、本論文では既存の一般的な好みデータを使用し、伝播戦略を廃止して詳細な画像ディテールを評価可能にするStep-by-step Preference Optimization(SPO)を導入します。具体的には、各ノイズ除去ステップで1)共有ノイズ潜在変数から複数の候補をサンプリングし、2)ステップ対応の好みモデルを用いて適切な勝敗ペアを見つけてDiffusionモデルの監督を行い、3)次のノイズ除去ステップの初期化に候補プールからランダムに1つ選びます。この戦略により、Diffusionモデルはレイアウトの側面ではなく、微細な視覚差異に集中できます。これらの改良された小さな差異を積み重ねることで美的感覚は大きく向上します。

Stable Diffusion v1.5およびSDXLを微調整した際、SPOは既存のDPO手法と比べて美的感覚を大幅に改善し、バニラモデルに比べて画像とテキストの整合性を損ないません。さらに、SPOは細かな視覚差異のステップごとの整合によりDPOよりもはるかに速く収束します。コードとモデルはこちら:https://rockeycoss.github.io/spo.github.io/

モデル説明

このモデルはstable-diffusion-xl-base-1.0から微調整されています。4,000のプロンプトで10エポックの訓練を行っています。このチェックポイントはLoRAチェックポイントです。詳細はこちらをご覧ください。

引用

本研究が有用だと感じたら、スターを付けて引用していただけると幸いです。

@article{liang2024step,

title={Step-by-step Preference Optimizationによる一般的な好みからの美的ポストトレーニングDiffusionモデル},

author={Liang, Zhanhao and Yuan, Yuhui and Gu, Shuyang and Chen, Bohan and Hang, Tiankai and Cheng, Mingxi and Li, Ji and Zheng, Liang},

journal={arXiv preprint arXiv:2406.04314},

year={2024}

}モデル詳細

ディスカッション

コメントを残すには log in してください。