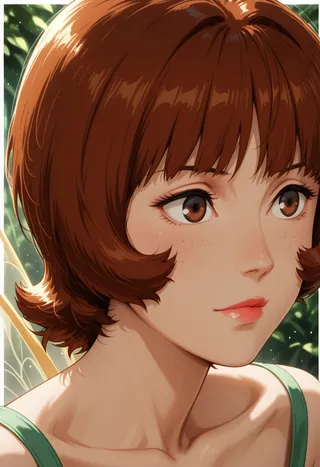

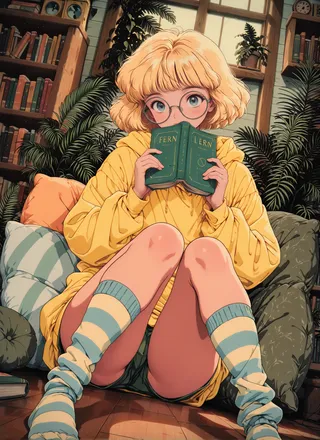

SPO-SDXL_4k-p_10ep_LoRA_webui - v1.0

팁

이 모델은 LoRA로 미세 조정한 체크포인트입니다.

훈련은 4,000개의 프롬프트로 10 에폭 동안 진행되었습니다.

Step-by-step Preference Optimization은 각 단계에서 세밀한 시각적 개선을 가능하게 하여 미학을 효과적으로 향상시킵니다.

Step-by-step Preference를 이용한 일반 선호도 기반 미학적 사후 훈련 확산 모델

초록

시각적으로 매력적인 이미지를 생성하는 것은 현대 텍스트-이미지 생성 모델의 기본입니다. 미학을 개선하는 하나의 잠재적 해법은 직접 선호 최적화(DPO)로, 프롬프트 정렬 및 미학을 포함한 일반 이미지 품질을 향상시키기 위해 확산 모델에 적용되어 왔습니다. 대중적인 DPO 방법은 깨끗한 이미지 쌍에서 선호 라벨을 두 생성 경로 전반의 모든 중간 단계로 전파합니다. 그러나 기존 데이터셋의 선호 라벨은 레이아웃 및 미학적 의견과 혼합되어 미학적 선호와 일치하지 않을 수 있습니다. 설령 상당한 비용을 들여 미학 라벨이 제공되더라도 두 경로 방법은 다양한 단계에서 미묘한 시각적 차이를 포착하기 어렵습니다.

미학을 경제적으로 개선하기 위해 본 논문은 기존의 일반 선호 데이터를 사용하고 전파 전략을 폐기하여 세밀한 이미지 디테일 평가를 가능하게 하는 Step-by-step Preference Optimization(SPO)을 소개합니다. 구체적으로 각 노이즈 제거 단계에서, 1) 공유된 노이즈 잠재공간에서 후보군을 샘플링하고, 2) 단계 인지 선호 모델을 사용해 확산 모델을 감독할 적합한 승-패 쌍을 찾으며, 3) 다음 노이즈 제거 단계를 초기화할 후보를 무작위로 선택합니다. 이 전략은 확산 모델이 레이아웃 대신 미묘하고 세밀한 시각적 차이에 집중하도록 합니다. 이러한 개선된 미세 차이를 누적함으로써 미학이 크게 향상됨을 확인했습니다.

Stable Diffusion v1.5와 SDXL을 미세 조정할 때, SPO는 기존 DPO 방법보다 미학 면에서 상당한 향상을 이루면서도 일반 모델과 비교해 이미지-텍스트 정렬을 저해하지 않습니다. 또한 SPO는 세밀한 시각적 디테일의 단계별 정렬 덕분에 DPO 방법보다 훨씬 빠르게 수렴합니다. 코드 및 모델: https://rockeycoss.github.io/spo.github.io/

모델 설명

이 모델은 stable-diffusion-xl-base-1.0에서 미세 조정되었습니다. 4,000개의 프롬프트로 10 에폭 동안 훈련되었습니다. 이 체크포인트는 LoRA 체크포인트입니다. 자세한 정보는 여기를 방문해 주세요.

인용

본 작업이 유용하다면 별점과 인용을 부탁드립니다.

@article{liang2024step,

title={Step-by-step Preference Optimization을 통한 일반 선호 기반 미학적 사후 훈련 확산 모델},

author={Liang, Zhanhao and Yuan, Yuhui and Gu, Shuyang and Chen, Bohan and Hang, Tiankai and Cheng, Mingxi and Li, Ji and Zheng, Liang},

journal={arXiv preprint arXiv:2406.04314},

year={2024}

}