Colossus Project Flux - v10_int4_SVDQ

Powiązane słowa kluczowe i tagi

Zalecane negatywne podpowiedzi

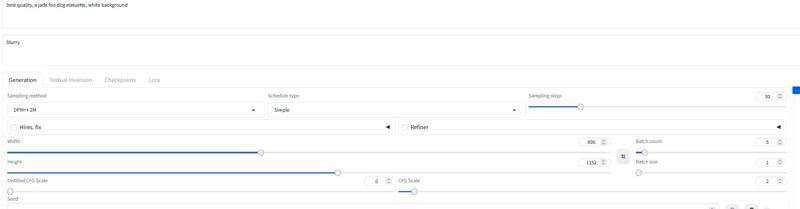

blurry

Zalecane parametry

samplers

steps

cfg

resolution

vae

Wskazówki

Używaj negatywnego promptu z słowem 'blurry', aby poprawić jakość wyjścia.

Dla wersji FP4 używaj wyłącznie kart graficznych Nvidia serii 50xx; wersje int4 obsługują 40xx i niższe (minimum seria 20xx).

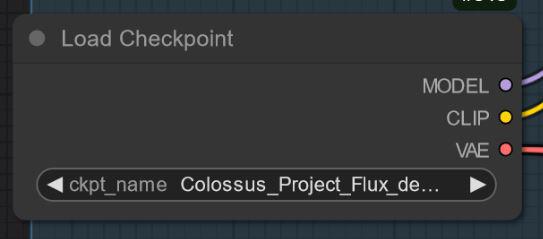

Modele "All in One" zawierają wbudowane Clip_l, T5xxl i VAE dla uproszczenia użytkowania.

Wypróbuj różne samplery takie jak Euler, Heun, DPM++2M, deis, DDIM; zalecany scheduler to 'Simple'.

Eksperymentuj z skalą guidance (cfg) w zakresie od 1.5 do 3, domyślnie około 2.2 do 2.3 dla najlepszych rezultatów.

Wersja FP8 oferuje dobry balans między jakością a wydajnością.

Dla specjalnych wersji ‚de-distilled’ wyłącz Flux Guidance scale i polegaj na cfg.

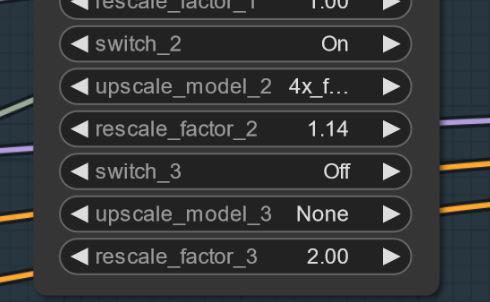

Jeśli pojawią się artefakty, spróbuj małego powiększenia (np. 1.14x zamiast 1.2x), aby złagodzić problemy.

Przewodniki i szczegółowe instrukcje dostępne są poprzez linki do artykułów Civitai.

Najważniejsze informacje o wersji

Wersja V10_int4_SVDQ „Nunchaku”

Instalacja: Odwiedź mój poradnik workflow/instalacji: https://civitai.com/articles/15610

Na początek chcę podziękować theunlikely https://huggingface.co/theunlikely, który przekonwertował FP16_Unet na int4_SVDQ. Odwiedź jego stronę i zostaw like.

Ta wersja jest mniej więcej równa wersji FP8. Nawet w normalnym trybie w moim workflow ta rzecz jest 2-3 razy szybsza niż zwykły model.. W "trybie szybkim" workflow mogę wyrenderować obraz 2MP w około 19 sekund na mojej 3090ti.

Czym jest SVDQ „Nunchaku”?

Ta nowa metoda kwantyzacji pozwala zmniejszyć modele Flux (tu natywny model FP16) z 24GB do około 6.7GB. Ale to nie wszystko: możesz generować szybciej niż kiedykolwiek wcześniej bez dużej utraty jakości. Oczywiście zauważysz niewielką różnicę w stosunku do mojego 32GB_Behemoth, ale do uruchomienia tego potrzebujesz znacznie więcej VRAM/RAM.

Po więcej informacji odwiedź: https://github.com/mit-han-lab/ComfyUI-nunchaku?tab=readme-ov-file

Sponsorzy twórcy

Wesprzyj twórcę na Ko-Fi: https://ko-fi.com/afroman4peace

Pobierz skwantyzowane modele od Muyang Li z Nunchakutech: https://huggingface.co/nunchaku-tech/nunchaku-flux.1-dev-colossus

Przewodniki workflow na Civitai:

https://civitai.com/articles/17313

https://civitai.com/articles/17358

https://civitai.com/articles/17163

https://civitai.com/articles/15610

https://civitai.com/articles/11950/workflow-for-colossus-project-flux-50

https://civitai.com/articles/8419

https://civitai.com/articles/7946

GitHub dla kwantyzacji Nunchaku SVDQ: https://github.com/mit-han-lab/ComfyUI-nunchaku?tab=readme-ov-file

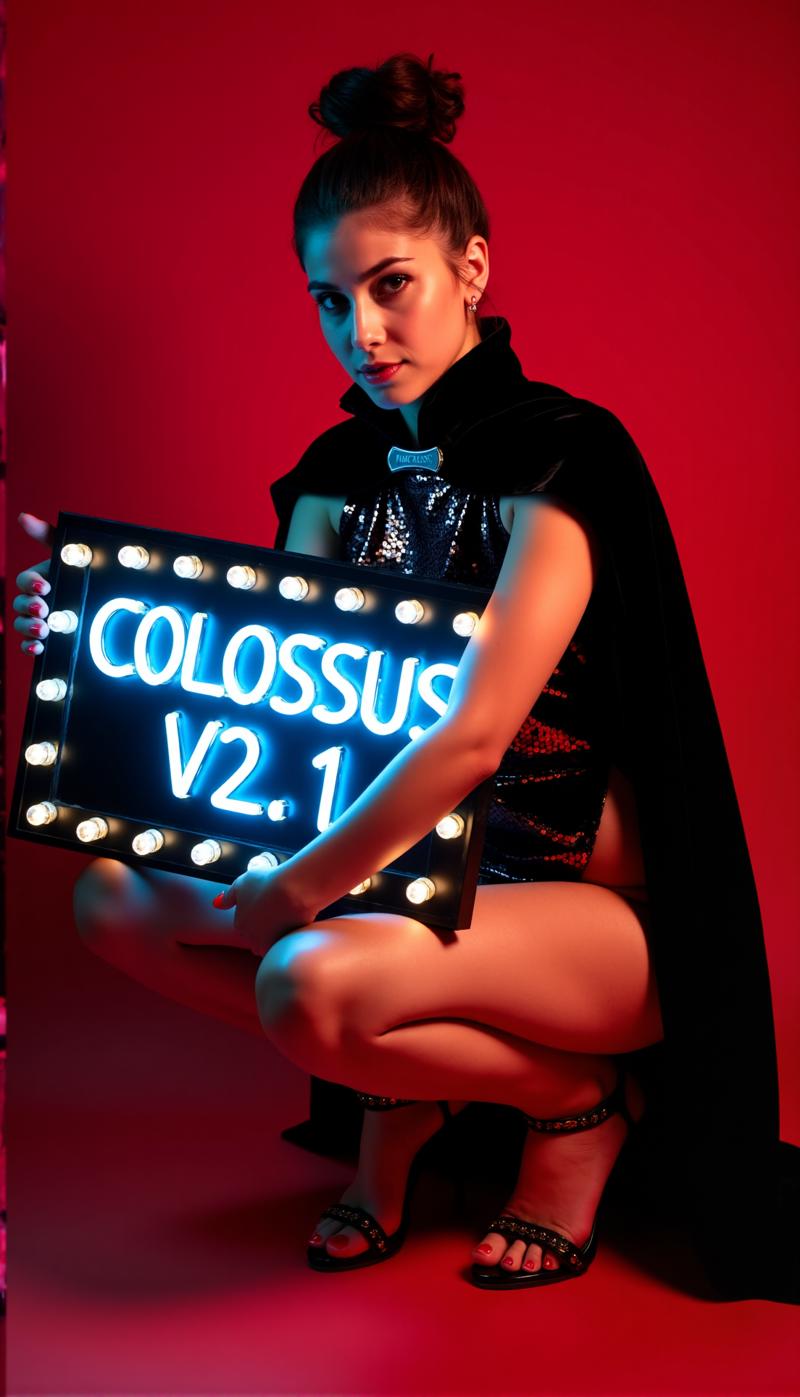

Głęboko pod górą mieszka śpiący gigant, zdolny zarówno pomóc ludzkości, jak i sprowadzić zniszczenie...

Powstaje Kolos...

Po mojej serii SDXL czas na serię FLUX tego Projektu... Tym razem trenowałem to od podstaw. Do treningu użyłem własnych obrazów. Stworzyłem je moim modelem schnell Flux DemonFlux/Colossus Project schnell + moim SDXL Colossus Project 12 jako refine'em.

Ten checkpoint SD Flux potrafi wygenerować niemal wszystko.. Colossus świetnie tworzy bardzo realistyczne obrazy, anime i sztukę.

Jeśli ci się podoba, śmiało daj mi znać swoje opinie. Jeśli chcesz mnie wesprzeć, możesz to zrobić tutaj. Włożyłem sporo pieniędzy, aby zbudować komputer zdolny faktycznie trenować modele Flux.. Trening i testowanie pochłania też dużo czasu i energii elektrycznej..

https://ko-fi.com/afroman4peace

Wersja V12 „Hephaistos”

Publikacja tego checkpointu daje mi mieszane uczucia.. V12 będzie ostatnim checkpointem tej serii.. Głównym powodem są nadchodzące unijne przepisy dotyczące AI... Kolejnym powodem jest licencja Flux .1 DEV. Dziękuję wszystkim za wsparcie! Poświęciłem temu Projektowi dużo czasu przez ostatni rok. Teraz czas przejść do innego projektu.

Mimo to zakończę tę serię na wysokim poziomie...

V12 opiera się na V10B „BOB”, ale w zasadzie zawiera najlepsze elementy z całej serii, zespolone w jednym checkpointie. (To efekt nowej metody mergowania, która zajęła około 1:30h i zużyła całą moją pamięć RAM 128GB). Również ulepszyłem tekstury twarzy i skóry w porównaniu do V10. Oczy są znacznie bardziej realistyczne i „żywe” niż wcześniej.

Wypróbuj i podziel się opinią o V12. Dzięki mojemu wolnemu łączu internetowemu najpierw wgram FP8_UNET. Potem wersję FP8 „all in one”, a następnie FP16_unet i FP16_BEHEMOTH. Spróbuję też przekonwertować na int4 i fp4 (trzymaj kciuki).

Jak zawsze daj znać, co sądzisz o V12..

Wersja V12 „Behemoth” (AIO)

Model „all in one” to najlepszy z mojej serii V12.. no i największy rozmiarowo oczywiście :-)

Behemoth zawiera w modelu wbudowane niestandardowe T5xxl i Clip_l. Jeśli cenisz jakość ponad ilość, to jest checkpoint dla Ciebie!

Wersja V12 FP4/int4

Dzięki Muyang Li z Nunchakutech, który wykonał kwantyzację V12. https://huggingface.co/nunchaku-tech i ich niesamowitym nunchaku!

Ta wersja jest naprawdę niesamowita. Łączy jakość z prędkością jak nigdy wcześniej.

UWAGA!

Są dwie wersje FP4 i int4. FP4 jest tylko dla kart NVIDIA 50xx! Int4 działa na 40xx i poniżej (potrzebujesz przynajmniej karty z serii 20xx)

Możesz też pobrać obie wersje bezpośrednio tutaj: https://huggingface.co/nunchaku-tech/nunchaku-flux.1-dev-colossus

PORADNIK INSTALACJI I PRZEBIEG PRACY

Oto szybki poradnik instalacji i WIP workflow.

https://civitai.com/articles/17313

SZCZEGÓŁOWY PORADNIK workflow

https://civitai.com/articles/17358

Wciąż pracuję nad swoimi nowymi workflow dla Nunchaku.. więc poniższy workflow jest w trakcie opracowania (WIP). Dodam szczegółowy artykuł w weekend.

Wersja V12 FP16_B_variant

Dzięki małemu błędowi, który popełniłem późno w nocy (2:00) niechcący nazwałem i wgrałem „zły” checkpoint. Jest to bardzo eksperymentalny checkpoint, nigdy nieprzeznaczony do publikacji. Nie był testowany dogłębnie, ale sprawował się bardzo dobrze podczas tworzenia pokazu. Może być lepszy niż standardowa wersja.

Skłania się bardziej ku azjatyckim twarzom.. To dlatego, że chciałem przetestować coś, co miksuję w bocznym projekcie nad którym wciąż pracuję. Podziel się swoimi doświadczeniami z tym checkpointem :-)

Wersja V12 AIO FP8

Ta wersja to wersja all-in-one V12. Oznacza to, że wszystkie clipy są wbudowane w model. Da ten sam output co FP8_unet z moim niestandardowym clip_l

Wersja V12 GGUF Q5_1

Ta wersja była na życzenie. Jakość jest niezła..

Wersja V10B „BOB”

To alternatywna wersja V10. Stworzyłem ją, by poprawić wersję FP8 V10. Generalnie wersja FP8 jest bardziej precyzyjna i ma lepsze kolory. Niestety ostatnio mam mało czasu.. (życie realne przede wszystkim). Dlatego to trwało tak długo.. Daj znać, jeśli wolisz tę wersję. Mam też wersję FP16 „BOB”. W zależności od feedbacku rozważę publikację wersji int4.

WORKFLOW:

Tutaj jest workflow dla V12 i V10: https://civitai.com/articles/17163

Wersja V10_int4_SVDQ „Nunchaku”

Na początek chcę podziękować theunlikely https://huggingface.co/theunlikely, który przekonwertował FP16_Unet na int4_SVDQ. Odwiedź jego stronę i zostaw like.

Ta wersja jest mniej więcej równa wersji FP8. Nawet w normalnym trybie w moim workflow ta rzecz jest 2-3 razy szybsza niż zwykły model.. W "trybie szybkim" workflow mogę wyrenderować obraz 2MP około 19 sekund na mojej 3090ti.

Czym jest SVDQ „Nunchaku”?

Ta nowa metoda kwantyzacji pozwala zmniejszyć modele Flux (tu natywny model FP16) z 24GB do około 6.7GB. Ale to nie wszystko: możesz generować szybciej niż kiedykolwiek bez dużej utraty jakości. Oczywiście zauważysz niewielką różnicę w stosunku do mojego 32GB_Behemoth, ale do uruchomienia tego potrzebujesz znacznie więcej VRAM/RAM.

Po więcej informacji odwiedź: https://github.com/mit-han-lab/ComfyUI-nunchaku?tab=readme-ov-file

Instalacja: Odwiedź mój poradnik workflow/instalacji: https://civitai.com/articles/15610

Wersja V10 „Behemoth” (FP16_AIO)

Ta wersja jest nadal eksperymentalna. Główny fokus to uzyskanie bardziej realistycznych wyników. Udało mi się też zredukować niektóre „linie Flux”. Bazuje na Colossus Project V5.0_Behemoth, V9.0 oraz projekcie nazwanego „Ouroborus Project”

FP16 jest bardzo stabilny. Niedługo wypuszczę wersję FP8. Ta również jest dobra, ale mniej stabilna..

Możesz sam eksperymentować z tym.. Powiedz mi, co sądzisz o tej wersji.

Baw się dobrze tworząc :-)

Wersja V9.0:

Muszę dużo wyjaśnić.. Czemu w ogóle V9.0?

Niedawno przeprowadziłem się do nowego mieszkania, a przez błędy dostawcy internetu nie miałem prawdziwego połączenia.. Więc podczas całej przeprowadzki zostawiłem komputer włączony. W efekcie powstało sporo (większość uszkodzonych) checkpointów. Mam kilka naprawdę dobrych wersji V8, które też mogę opublikować..

Co się zmieniło?

Wprowadziłem nowe treningi twarzy i tekstur skóry, korzystając z najlepszych wyników V5.0. Dodano też trening stóp/nóg dla lepszej anatomii. W wersjach V5.0 problemem bywało obcinanie głowy i stóp.. Myślę, że udało mi się naprawić niektóre z tych błędów..

Dodatkowo trenowałem model na większej liczbie własnych zdjęć krajobrazów.. I tak, robiłem to podczas przeprowadzki... Czas treningu to około 2 tygodnie czasu obliczeniowego, co nie jest tanie.. (każda godzina to około 25 centów za prąd)

W każdym razie mam nadzieję, że wersja Ci się spodoba.. Jeśli chcesz mnie wesprzeć: udostępnij ładne obrazy lub nawet naproś mnie na Buzz lub Ko-Fi..

Powiedz, co myślisz :-)

Wersja 5.0:

V5.0 opiera się na V4.2 i V4.4 (która też wkrótce zostanie wydana). Zyskała dodatkowy trening na szczegóły skóry i anatomię, co poprawiło elementy takie jak dłonie i sutki. Detale twarzy są znacznie lepsze. Próbowałem też naprawić drobne linie Flux..

Generalnie wersja jest bardziej realistyczna niż V4.2 i lepsza z mniejszymi detalami.. Tak jak wersja 4.2 jest to hybrydowy model de-distilled. Można używać go z tymi samymi ustawieniami co V4.2.

Poniżej nowy workflow do zabawy: https://civitai.com/articles/11950/workflow-for-colossus-project-flux-50

Powiedz, co myślisz porównując do 4.2 lub V2.1..

Wersja 4.4 „Research”:

Dodałem tę wersję dla kompletności.. Jest trochę bardziej realistyczna niż V4.2 i stanowi bazę dla wersji 5.0. Możesz ją wypróbować. Można też używać workflow dla V5.0 i V4.2..

Wersja 4.2:

Ta wersja to dalszy rozwój Demoncore Flux i Colossus Project Flux. Celem było uzyskanie stabilniejszych rezultatów z lepszymi teksturami skóry, lepszymi dłońmi i większą różnorodnością twarzy. Trenowałem na hybrydowym modelu, częściowo Demoncore Flux. Ulepszyłem też sutki i nieco NSFW. Powiedz, jeśli wolisz V4.2 od wersji 2.1 :-)

Do obrazów pokazowych używałem wyłącznie natywnych obrazów o rozdzielczości SDXL lub 2MP (np. 1216x1632). Model radzi sobie nawet z wyższymi rozdzielczościami.. Testowałem do 2500x2500, ale rekomenduję maksymalnie około 2000x2000.

Dla ustawień polecam około 30 kroków i 2-2.5 cfg. Zazwyczaj używam 2.2 lub 2.3 w workflow. Na pokazach używałem DPM++ 2M z prostym schedulerem.

Wkrótce dodam więcej wersji, ale przed świętami nie mam zbyt wiele czasu..

Ustawienia

Niebawem dodam dedykowany nowy workflow Comfy. Na razie możesz pobrać i otworzyć obrazy pokazowe..

Wersja „All in One” dobrze działa też z Forge..

W zasadzie działa z tymi samymi ustawieniami co Wersja 2.1 (poniżej)

Ustaw 20-30 kroków z około 2.2 cfg..

Wersja 2.1_de-distilled_experimental (MERGE)

Ta wersja jest zupełnie inna i działa inaczej niż zwykły model Flux!

Jest to eksperymentalne połączenie mojej wersji 2.0 i wersji de-distilled https://huggingface.co/nyanko7/flux-dev-de-distill. Stało się to trochę przypadkiem, ale wyniki są zdumiewające. Uzyskasz zadziwiające detale. Model bardzo dobrze reaguje na prompt'y... Następnym krokiem będzie trening bezpośrednio na modelu de-distilled. Mam też już testowe Lory. To bardzo eksperymentalne, daj znać, jeśli znajdziesz błędy, które nie są wymienione poniżej. Jeśli masz dobre obrazy, podziel się nimi.. również złymi, aby pomóc w poprawie : ). Możesz też spróbować wersji 2.0 i powiedzieć, który checkpoint Ci bardziej odpowiada.

!Uwaga!

Zwykły workflow Flux nie działa z tą wersją. MUSISZ pobrać mój workflow!

Możesz też wymyślić coś sam, ale proszę, nie obwiniaj mnie za złe obrazy. To bardzo eksperymentalny model... zobacz minusy poniżej..

Zalety i wady tego checkpointu:

Model generuje ekstremalne detale, ale to kosztuje czas.. Jest wolniejszy od zwykłych checkpointów Flux. Zaletą jest to, że często nie potrzebujesz dodatkowego powiększenia (upscale). Zamiast Flux Guidance używa skali cfg. Oznacza to, że nie będzie działał ze standardowymi workflow.

Można używać negatywnych promptów! Pomaga to usuwać niechciane elementy z obrazu.

Czasem pojawiają się artefakty.. Można to rozwiązać małym, prostym powiększeniem (pracuję nad tym). Oto przykład.. zdarza się to dziwnie nie z każdym seedem.. AKTUALIZACJA: To nie jest problem modelu, a workflow. Pracuję nad naprawą. Gdy to się zacznie zdarzać, spróbuj ustawić pierwsze powiększenie na 1.14 zamiast 1.2.

Ustawienia i workflow V2.1:

Workflow znajdziesz tutaj: https://civitai.com/articles/8419

Ustawienia: w przeciwieństwie do normalnego Flux nie potrzebuje skali Flux Guidance. Użyj zamiast tego cfg. Zwykle stosuję cfg 3 w workflow.. Niektóre obrazy mogą wymagać niższych wartości.

Najważniejsze jest wyłączenie flux guidance scale..

Bez workflow testowałem z 30 krokami i cfg 2-3. To mogą być też ustawienia dla Forge. Eksperymentuj.

Polecam używać słowa „blurry” w negatywach

Sampler i scheduler:

Możesz wybrać spośród kilku działających samplerów:

Euler, Heun, DPM++2m, deis, DDIM działają świetnie.

Zazwyczaj używam „simple” jako scheduler

Jeśli znajdziesz lepsze ustawienia, daj znać.. :-)

Dla Forge polecam używać modelu AIO.. oto przykładowe ustawienie do Forge

Wersja 2.0_dev_experimental

To wersja eksperymentalna. Celem było stworzenie spójniejszego i szybszego modelu. Dodałem własne dodatkowe lory i połączyłem powstałe modele specjalną metodą (Tensor merge). Ma wbudowany niestandardowy T5xxl zmodyfikowany przez "Attention Seeker". Aby zyskać prędkość i dodatkową jakość, zintegrowałem Hyper Flux lora od ByteDance. To przesunęło pole pracy.. Pokażę Ci, co to znaczy.. Oto główny obraz tytułowy..

16 kroków V 2.0

30 kroków V 1.0

30 kroków V 1.0

Minusy:

Minusy:

Ta wersja jest trochę większa niż poprzednia.. Po drugie, wciąż muszę stworzyć wersję tylko UNET. Zaktualizuję, gdy będzie gotowa..

Ustawienia i workflow V2.0:

Model możesz teraz uruchomić z mniejszą liczbą kroków.. 16 kroków odpowiada 30 krokom starego modelu.

Zwykle polecam 20-30 kroków, bo daje to lepszą jakość w większości sytuacji.

Sampler: wolę Euler z Simple jako schedulerem. Guidance można ustawić od 1.5 do 3 (oczywiście eksperymentuj poza tym zakresem). Guidance 1.8 dobrze działa dla realizmu. Możesz też przetestować inne samplery. DPM++2M i Heun też działają świetnie.

Workflow 2.0:

Stworzyłem nowy workflow dla V2.0 i V1.0, który ma nowy Flux Prompt Generator. Działa też drugi etap upscalera. https://civitai.com/articles/7946

Forge:

Testowałem też ten model z Forge i działało bardzo dobrze.. Obrazy mogą różnić się między Comfy UI a Forge..

Wersja 1.0_dev_beta:

To mój pierwszy model z serii. Proszę daj mi feedback i wrzuć jakieś obrazy. To pomaga rozwijać projekt. Jest kilka wersji do wyboru. Najlepszym modelem pod względem jakości jest wersja FP16. Jest ona duża i wymaga mocnej karty graficznej oraz dużo RAM. Wersja FP8 to dobry kompromis między jakością a wydajnością. Jeśli chcesz wersję GGUF, pobierz Q8_0. Wersja GGUF Q4_0/4.1 była na życzenie. Są małe, ale tracisz trochę jakości.

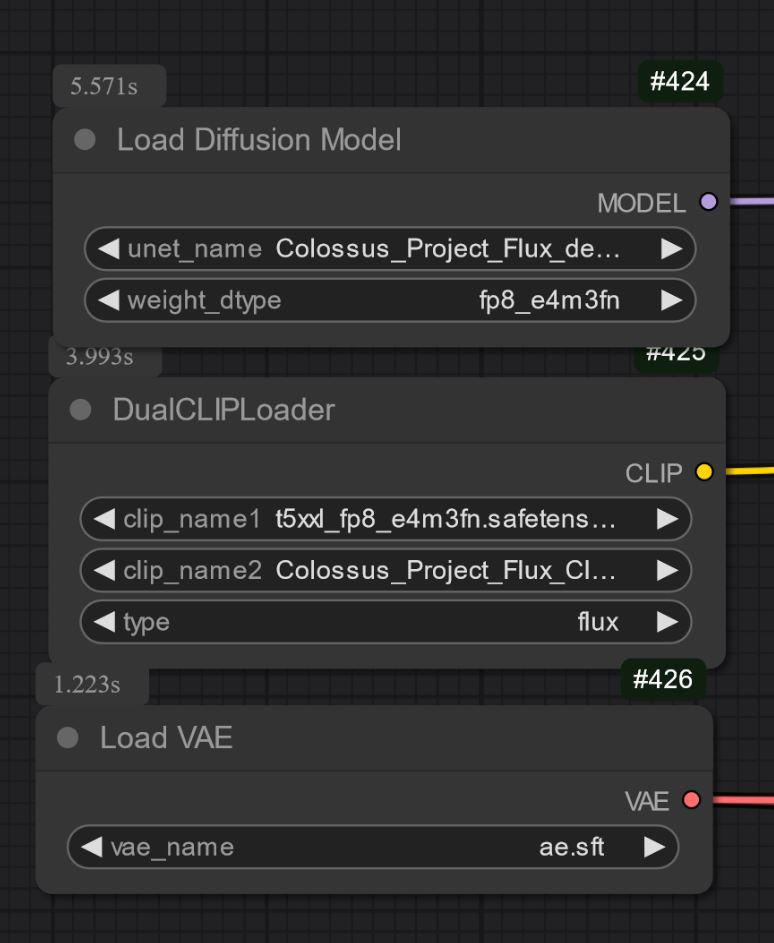

Są zasadniczo dwa typy moich modeli: "All in one", które wymagają pobrania tylko jednego pliku. Mają wbudowane Clip_l, T5xxl fp8 i VAE. (patrz niżej). Umieść je w folderze checkpoints.

Drugie to wersje tylko UNET. Musisz załadować wszystkie pliki osobno.

W każdym przypadku potrzebujesz pobrać mój Clip_L, aby dobrze działały..

Ważne jest też dobranie odpowiedniego clipa T5xxl. Dla wersji FP8 to clip fp8_e4m3fn t5xxl. Dla FP16 to clip FP16. Upewnij się, że wybrałeś domyślny typ wag. (poniżej przykład dla wersji fp8)

Do wersji GGUF potrzebujesz loadera GGUF!

Obecnie znane kwestie dla V1.0:

To tylko pierwszy model serii, więc może mieć problemy z niektórymi promptami lub stylami, np. sztuką. Następne wersje dostaną więcej treningu. Daj znać, czego model nie potrafi..

Ustawienia i workflow:

Testowałem około 30 kroków, Euler z Simple jako schedulerem. Guidance od 1.5 do 3 (możesz eksperymentować poza tym zakresem).

Guidance 1.8 dobrze działa dla realizmu.

Eksperymentuj z ustawieniami.. Jeśli masz dobre wyniki, podziel się nimi.

Dołączyłem obrazy pokazowe jako dane treningowe.. Wewnątrz jest workflow dla Comfy. Oto link do workflow do pobrania: https://civitai.com/articles/7946

Model "All in one":

Tylko UNET:

Musisz też pobrać clip_L. To plik 240MB.

Musisz też pobrać clip_L. To plik 240MB.

GGUF: Dodałem workflow dla GGUF tutaj: https://civitai.com/articles/7946

Ważne:

Model developerski nie jest przeznaczony do użytku komercyjnego. Wersję „schnell” opublikuję gdzie indziej. Ten model jest bardziej do użytku osobistego lub naukowego.

LICENCJA:

https://huggingface.co/black-forest-labs/FLUX.1-dev/blob/main/LICENSE.md

Podziękowania:

theunlikely https://huggingface.co/theunlikel (jeszcze raz dziękuję)

Wersja 2.1/V4.2/5.0: Flux_dev_de-distill od nyanko7

https://huggingface.co/nyanko7/flux-dev-de-distill

Od V2.0: Hyper Lora od ByteDance https://huggingface.co/ByteDance/Hyper-SD

Black Forrest za ich niesamowity model Flux https://huggingface.co/black-forest-labs

Szczegóły modelu

Typ modelu

Model bazowy

Wersja modelu

Hash modelu

Twórca

Dyskusja

Proszę się log in, aby dodać komentarz.

Kolekcja modeli - Colossus Project Flux

Colossus Project Flux - v12_int4_SVDQ_nunchaku

Colossus Project Flux - V12 "Hephaistos" FP8_UNET

Colossus Project Flux - v10_AIO_FP8