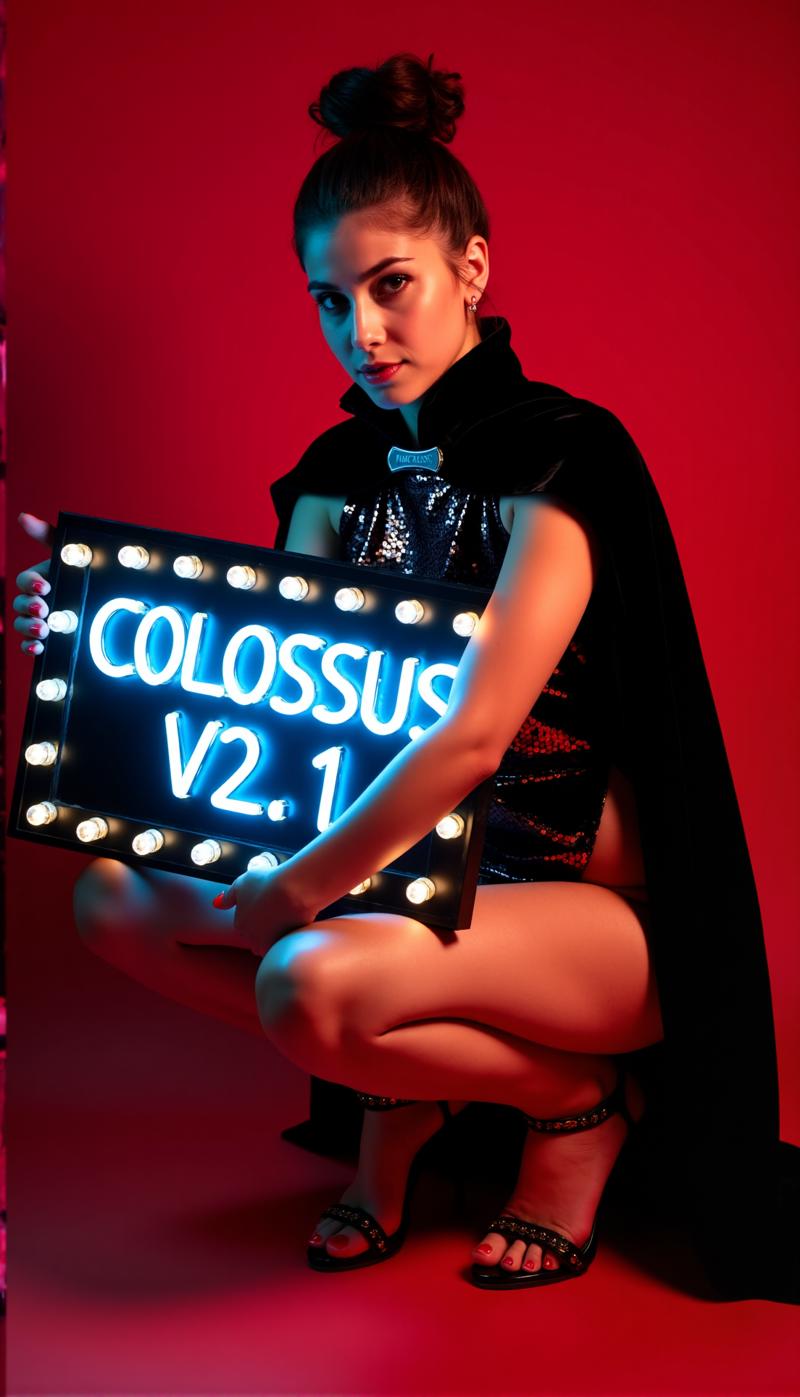

Colossus Project Flux - v10_int4_SVDQ

Palavras-chave e Tags Relacionadas

Prompts Negativos Recomendados

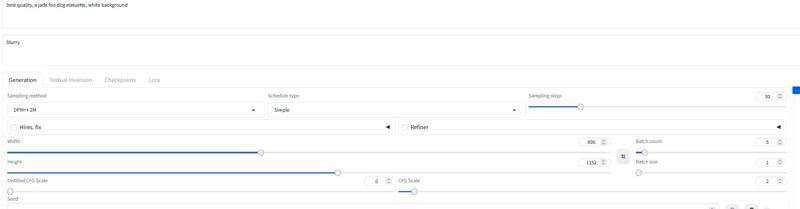

blurry

Parâmetros Recomendados

samplers

steps

cfg

resolution

vae

Dicas

Use prompt negativo com a palavra 'blurry' para melhorar a qualidade da saída.

Para versões FP4, use apenas placas gráficas Nvidia série 50xx; versões int4 suportam 40xx e abaixo (mínimo série 20xx).

Os modelos "All in One" contêm Clip_l, T5xxl e VAE embutidos para simplificar o uso.

Teste vários samplers como Euler, Heun, DPM++2M, deis, DDIM; o scheduler 'Simple' é recomendado.

Experimente a escala de orientação (cfg) de 1,5 a 3, padrão em torno de 2,2 a 2,3 para melhores resultados.

Versão FP8 oferece bom equilíbrio entre qualidade e desempenho.

Para versões especiais ‘de-distilled’, desative a escala Flux Guidance e confie no cfg.

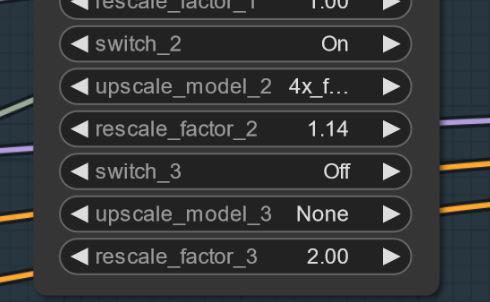

Se surgirem artefatos, tente um pequeno upscaling (ex., 1,14x ao invés de 1,2x) para mitigar problemas.

Fluxos de trabalho e guias detalhados são fornecidos via links para artigos no Civitai.

Destaques da Versão

Versão V10_int4_SVDQ "Nunchaku"

Instalação: Por favor, visite o guia de fluxo/instalação: https://civitai.com/articles/15610

Primeiro, quero agradecer ao theunlikely https://huggingface.co/theunlikely que converteu o FP16_Unet para int4_SVDQ. Visite a página dele e deixe um like.

Esta versão é mais ou menos igual à versão FP8. Mesmo no modo normal dentro do meu fluxo de trabalho, esta versão é cerca de 2X-3X mais rápida que o modelo regular. Com o "modo rápido" do fluxo, consigo renderizar uma imagem de 2MP em cerca de 19 segundos com minha 3090ti.

O que é SVDQ "Nunchaku"?

Este novo método de quantificação permite diminuir modelos Flux (neste caso um modelo nativo FP16) de 24GB para cerca de 6,7GB. Mas não é só isso: você pode gerar imagens mais rápido do que nunca sem perder muita qualidade. Claro, você verá uma pequena diferença em relação ao meu 32GB_Behemoth, mas para este modelo você precisará de muito mais VRAM/RAM para rodá-lo.

Para mais informações visite: https://github.com/mit-han-lab/ComfyUI-nunchaku?tab=readme-ov-file

Patrocinadores do Criador

Apoie o criador no Ko-Fi: https://ko-fi.com/afroman4peace

Baixe os modelos quantizados de Muyang Li de Nunchakutech: https://huggingface.co/nunchaku-tech/nunchaku-flux.1-dev-colossus

Guias de fluxo de trabalho no Civitai:

https://civitai.com/articles/17313

https://civitai.com/articles/17358

https://civitai.com/articles/17163

https://civitai.com/articles/15610

https://civitai.com/articles/11950/workflow-for-colossus-project-flux-50

https://civitai.com/articles/8419

https://civitai.com/articles/7946

GitHub para quantificação Nunchaku SVDQ: https://github.com/mit-han-lab/ComfyUI-nunchaku?tab=readme-ov-file

Nas profundezas de uma montanha vive um gigante adormecido, capaz tanto de ajudar a humanidade quanto de causar destruição...

Um Colosso surge...

Após minha série SDXL, é hora da série FLUX deste Projeto... Desta vez, treinei isso do zero. Para o treinamento, usei minhas próprias imagens. Criei-as com meu modelo schnell Flux DemonFlux/Colossus Project schnell + meu SDXL Colossus Project 12 como refinador.

Este ponto de verificação SD Flux é capaz de produzir quase tudo... Colossus é muito bom em criar imagens extremamente realistas, anime e arte.

Se gostar, fique à vontade para me dar algum feedback. Também, se quiser me apoiar, pode fazer isso aqui. Gastei um bom dinheiro para montar um computador capaz de treinar realmente modelos Flux... Além disso, treinamento e testes consomem muito tempo e eletricidade...

https://ko-fi.com/afroman4peace

Versão V12 "Hephaistos"

Publicar este ponto de verificação me deixa feliz e triste ao mesmo tempo... V12 será o último checkpoint desta série... A principal razão são as próximas leis de IA da UE... Outra razão é a licença do próprio Flux .1 DEV. Obrigado a todos pelo apoio! Dediquei muito tempo a este projeto no último ano. Agora é hora de avançar para outro projeto.

De qualquer forma... vou encerrar esta série em alta...

V12 é baseado no V10B "BOB" mas basicamente reúne as melhores partes desta série em um único checkpoint. (Foi o resultado de um novo método de merge que levou cerca de 1h30 para fundir e utilizou toda minha RAM de 128GB). Também melhorei as texturas de rosto e pele em comparação ao V10. Os olhos estão muito mais realistas e "vivos" do que antes.

Teste você mesmo e me dê feedback sobre o V12. "Graças" à minha conexão lenta, inicialmente farei o upload do FP8_UNET. Depois a versão FP8 "all in one" e então o FP16_unet e FP16_BEHEMOTH. Também tentarei converter para int4 e fp4 (torçam por mim nessa).

Como sempre, dê-me feedback sobre o V12...

Versão V12 "Behemoth" (AIO)

Este modelo "all in one" é o melhor da minha série V12... e o maior em tamanho, claro :-)

O Behemoth tem um T5xxl personalizado e Clip_l embutidos no modelo. Se você prefere qualidade em vez de quantidade, este é o checkpoint para você!

Versão V12 FP4/int4

Obrigado a Muyang Li da Nunchakutech que fez a quantificação do V12. https://huggingface.co/nunchaku-tech e seu incrível nunchaku!

Esta versão é verdadeiramente impressionante. Combina qualidade com velocidade nunca vista antes.

ATENÇÃO!

Existem duas versões FP4 e int4. FP4 é apenas para placas gráficas Nvidia 50xx! Enquanto int4 funciona com 40xx e abaixo. (você precisa de pelo menos uma placa da série 20xx)

Você também pode baixar ambas as versões diretamente aqui: https://huggingface.co/nunchaku-tech/nunchaku-flux.1-dev-colossus

GUIA DE INSTALAÇÃO e FLUXO DE TRABALHO

Aqui está um guia rápido de instalação e fluxo de trabalho em desenvolvimento.

https://civitai.com/articles/17313

GUIA DETALHADO para o Fluxo de Trabalho

https://civitai.com/articles/17358

Estou ainda trabalhando nos meus novos fluxos para Nunchaku... então o fluxo abaixo ainda está em WIP (em progresso). Adicionarei um artigo detalhado no fim de semana.

Versão V12 FP16_B_variant

Por causa de um pequeno erro que cometi tarde da noite (2h da manhã), renomeei e fiz upload do checkpoint "errado". É um checkpoint muito experimental e nunca foi destinado a ser publicado. Não foi muito testado, mas teve bom desempenho quando criei a vitrine. Pode ser melhor que a versão padrão.

Ele tende a focar mais em rostos asiáticos... Isso porque queria testar algo para misturar em um projeto paralelo ainda em desenvolvimento. Me conte sua experiência com este checkpoint :-)

Versão V12 AIO FP8

Esta versão é uma versão all-in-one do V12. Isso significa que todos os clips estão incorporados. Vai gerar o mesmo resultado do FP8_unet com meu Clip_l personalizado

Versão V12 GGUF Q5_1

Esta versão foi um pedido. A qualidade não é ruim...

Versão V10B "BOB"

Esta é uma versão alternativa do V10. Criei-a para melhorar a versão FP8 do V10. Em geral, a versão FP8 é mais precisa e as cores são melhores. Infelizmente, não tenho muito tempo recentemente (a vida real vem primeiro). Por isso demorou tanto... Me avise se preferir esta versão. Tenho também uma versão FP16 do "BOB". Dependendo do feedback, considerarei publicar uma versão int4.

FLUXO DE TRABALHO:

Aqui está o fluxo para V12 e V10: https://civitai.com/articles/17163

Versão V10_int4_SVDQ "Nunchaku"

Primeiro, quero agradecer ao theunlikely https://huggingface.co/theunlikely que converteu o FP16_Unet para int4_SVDQ. Visite a página dele e deixe um like.

Esta versão é mais ou menos igual à versão FP8. Mesmo no modo normal dentro do meu fluxo de trabalho, esta coisa é cerca de 2X-3X mais rápida que o modelo regular. Com o "modo rápido" do fluxo, consigo renderizar uma imagem de 2MP em cerca de 19 segundos com minha 3090ti.

O que é SVDQ "Nunchaku"?

Este novo método de quantificação permite diminuir modelos Flux (neste caso um modelo nativo FP16) de 24GB para cerca de 6,7GB. Mas não é só isso: você pode gerar imagens mais rápido do que nunca sem perder muita qualidade. Claro, você verá uma pequena diferença em relação ao meu 32GB_Behemoth, mas para este modelo você precisará de muito mais VRAM/RAM para rodá-lo.

Para mais informações visite: https://github.com/mit-han-lab/ComfyUI-nunchaku?tab=readme-ov-file

Instalação: por favor, visite o meu guia de instalação do fluxo de trabalho: https://civitai.com/articles/15610

Versão V10 "Behemoth" (FP16_AIO)

Esta versão ainda é experimental. O foco principal foi conseguir resultados mais realistas. Também consegui reduzir algumas "Linhas Flux". Isto é baseado no Colossus Project V5.0_Behemoth, V9.0 e outro projeto que chamo "Ouroborus Project"

A versão FP16 é muito estável. Também lançarei em breve uma versão FP8. Esta versão é muito boa, mas não tão estável...

Deixo você experimentar... Me diga o que acha desta versão.

Divirta-se criando :-)

Versão V9.0:

Bem, tenho que explicar muito... Primeiro, por que é a V9.0?

Recentemente me mudei para um apartamento novo e, devido a erros do provedor de internet, fiquei sem conexão real... Então, durante a mudança, deixei meu computador ligado. O resultado foi que criei muitos checkpoints (a maioria quebrados). Tenho algumas versões V8 muito boas que talvez publique...

O que mudou?

Treinei novas texturas de rosto e pele com base nos melhores resultados do V5.0. Também treinei pés/pernas para melhorar a anatomia. As versões V5.0 às vezes cortavam cabeça e pés... Acho que consegui corrigir alguns desses problemas..

Além disso, treinei com mais das minhas próprias imagens de paisagens... E sim, fiz tudo isso enquanto me mudava... O tempo total de treinamento foi cerca de 2 semanas de computação, o que não é barato (cada hora basicamente custa uns 25 centavos de eletricidade).

De qualquer forma, espero que goste desta versão... Se quiser me apoiar: poste imagens legais ou até me dê gorjeta no buzz ou no Ko-fi...

Me diga o que acha :-)

Versão 5.0:

O V5.0 é na verdade baseado no V4.2 e V4.4 (que também será lançado em breve). Recebeu treinamento adicional em detalhes de pele e anatomia que ajudaram a corrigir problemas com mãos e mamilos. Os detalhes do rosto ficaram muito melhores. Também tentei corrigir pequenas linhas flux...

Em geral, esta versão é mais realista que o V4.2 e melhor em pequenos detalhes... Como o V4.2, esta versão também é um modelo híbrido de-distilled. Você pode usá-lo basicamente com as mesmas configurações que o V4.2.

Aqui também está um novo Fluxo de Trabalho para experimentar: https://civitai.com/articles/11950/workflow-for-colossus-project-flux-50

Me diga o que acha desta versão comparada ao 4.2 ou V2.1...

Versão 4.4 "Research":

Adicionei esta versão só para completar... Ela é ligeiramente mais realista que a V4.2 e base para a versão 5.0. Você pode testá-la se quiser. Pode usar o fluxo para V5.0 e V4.2 também...

Versão 4.2:

Esta versão é basicamente um desenvolvimento do Demoncore Flux e Colossus Project Flux. O objetivo foi obter resultados mais estáveis com melhores texturas de pele, mãos melhores e mais variedade de rostos. Então treinei num modelo híbrido que é parcialmente Demoncore Flux. Também realcei os mamilos e conteúdo NSFW um pouco. Me diga se prefere o V4.2 sobre o V2.1 :-)

Para as imagens da vitrine: usei apenas imagens nativas com resolução SDXL ou 2MP (exemplo 1216x1632). Este modelo pode lidar com resoluções ainda maiores... Testei esse checkpoint até 2500x2500, mas recomendo ficar em torno de 2000x2000.

Para as configurações, recomendo usar cerca de 30 passos e 2-2,5 cfg. Na maioria uso 2.2 ou 2.3 no meu fluxo. Para a vitrine eu usei DPM++ 2M com Simple scheduler.

Em breve adicionarei mais versões, mas não tenho muito tempo antes do Natal...

Configurações

Em breve adicionarei um fluxo dedicado para Comfy. Por enquanto, você pode baixar e abrir as imagens da vitrine...

A versão "All in One" também funciona bem com Forge...

Basicamente funciona com as mesmas configurações da versão 2.1 (veja abaixo)

Use 20-30 passos com cerca de 2.2 cfg...

Versão 2.1_de-distilled_experimental (MERGE)

Esta versão é completamente diferente e funciona de forma diferente de um modelo Flux normal!

É uma fusão experimental entre minha versão 2.0 e uma versão de-distilled https://huggingface.co/nyanko7/flux-dev-de-distill. Isso aconteceu meio por acidente, mas os resultados são impressionantes. Você vai obter detalhes incríveis. Também segue muito bem os prompts... A próxima coisa que farei é treinar direto no modelo de-distilled. Já fiz alguns testes de Loras com ele. Isso é altamente experimental, então por favor me avise se encontrar erros que não estejam listados abaixo. Se tiver boas imagens, poste-as... poste também as ruins, isso ajuda a melhorar :-). Tente também a versão 2.0 e me diga qual tipo de checkpoint prefere.

!Atenção!

O fluxo normal Flux não funciona com esta versão. VOCÊ PRECISA baixar meu fluxo para usá-la!

Também pode tentar algo por conta própria, mas por favor não me culpe por imagens ruins. Este é um modelo altamente experimental... veja as desvantagens abaixo.

Vantagens e desvantagens deste checkpoint:

Este checkpoint pode criar detalhes extremos... Isso tem um preço... É lento comparado aos checkpoints normais Flux. A vantagem é que frequentemente não precisa de upscaling adicional. Em vez de usar Flux Guidance, este modelo usa escala cfg. O que também significa que não funcionará com fluxos padrão.

Você pode usar Prompts negativos! Isso ajuda a remover coisas indesejadas da imagem.

Às vezes podem aparecer artefatos... Você pode resolver isso com um pequeno upscaling simples (estou trabalhando nisso). Aqui está um exemplo... isso estranhamente não acontece com todas as seeds... ATUALIZAÇÃO: isto não é problema do modelo, mas sim do fluxo... estou trabalhando numa correção. Se acontecer, tente definir o primeiro upscaling para 1,14 em vez de 1,2.

Configurações e Fluxo de Trabalho V2.1:

Aqui está o fluxo para ele: https://civitai.com/articles/8419

Configurações: diferente do Flux normal, não precisa da escala Flux Guidance. Use o cfg em vez disso. Eu geralmente uso 3 cfg. Algumas imagens podem requerer cfg menor.

A coisa mais importante é desligar a escala Flux Guidance...

Sem o fluxo, testei com 30 passos e 2-3 cfg. Essa pode ser também a configuração para Forge. Experimente.

Recomendo usar a palavra "blurry" nos negativos.

Sampler e scheduler:

Pode escolher entre vários samplers que funcionam:

Euler, Heun, DPM++2m, deis, DDIM funcionam bem.

Eu usei principalmente "simple" como scheduler.

Se encontrar melhores configurações, me diga... :-)

Para Forge recomendo usar o modelo AIO.. aqui está uma configuração exemplo para Forge

Versão 2.0_dev_experimental

Bem... esta é uma versão experimental... O objetivo era criar um modelo mais coerente e rápido. Treinei alguns loras adicionais próprios e então fiz a fusão dos modelos resultantes de forma especial (tensor merge). Tem um T5xxl personalizado que modifiquei com "Attention Seeker". Para ganhar velocidade e qualidade adicional, mergei o Hyper Flux lora do ByteDance. Isso deslocou a área de trabalho... Aqui está a imagem principal de título...

16 passos V 2.0

30 passos V 1.0

30 passos V 1.0

Desvantagens:

Desvantagens:

Bem, primeiro... Esta versão é um pouco maior que a anterior... segundo, ainda preciso criar a versão só UNET. Vou atualizar quando estiver pronta...

Configurações e Fluxo de Trabalho V2.0:

Agora você pode rodar o modelo com menos passos... 16 passos equivalem a 30 passos do modelo antigo.

Mas ainda recomendo usar em torno de 20-30 passos para melhor qualidade na maioria dos casos.

Sampler: prefiro Euler com Simple como scheduler. A orientação pode ser ajustada de 1,5 a 3 (pode testar fora desta faixa também). O valor 1,8 funciona bem para imagens realistas. Pode testar outros samplers como DPM++2M e Heun também, que funcionam muito bem.

Fluxo de Trabalho 2.0:

Criei um novo fluxo para V2.0 e V1.0. Ele tem o novo Flux Prompt Generator. Além disso, consegui fazer funcionar a segunda etapa de upscaling. https://civitai.com/articles/7946

Forge:

Também testei este modelo com Forge e funcionou muito bem... As imagens podem diferir entre Comfy UI e Forge, porém...

Versão 1.0_dev_beta:

Este modelo foi minha primeira entrada da série. Por favor, dê feedback e poste imagens. Isso ajuda a melhorar o projeto. Existem várias versões para escolher. O modelo com melhor qualidade é o FP16. Esta versão é enorme e precisa de uma placa gráfica potente e bastante RAM. A versão FP8 é o bom equilíbrio entre qualidade e desempenho. Se quiser uma versão GGUF, baixe a Q8_0. A versão GGUF Q4_0/4.1 foi um pedido, são pequenas mas perdem um pouco de qualidade.

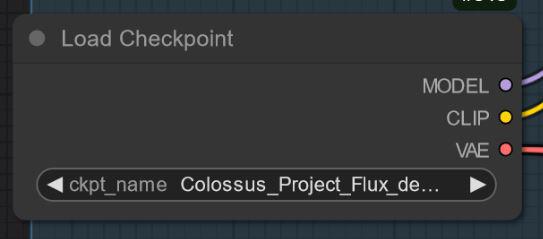

Basicamente existem dois tipos dos meus modelos: os "All in One" que precisam apenas de um arquivo, e que possuem Clip_l, T5xxl fp8 e VAE embutidos (veja abaixo). Coloque este arquivo na sua pasta de checkpoints.

As outras versões são apenas UNET. Nelas, você precisa carregar cada arquivo separadamente.

Em qualquer caso, você precisa baixar meu Clip_L para que funcionem corretamente..

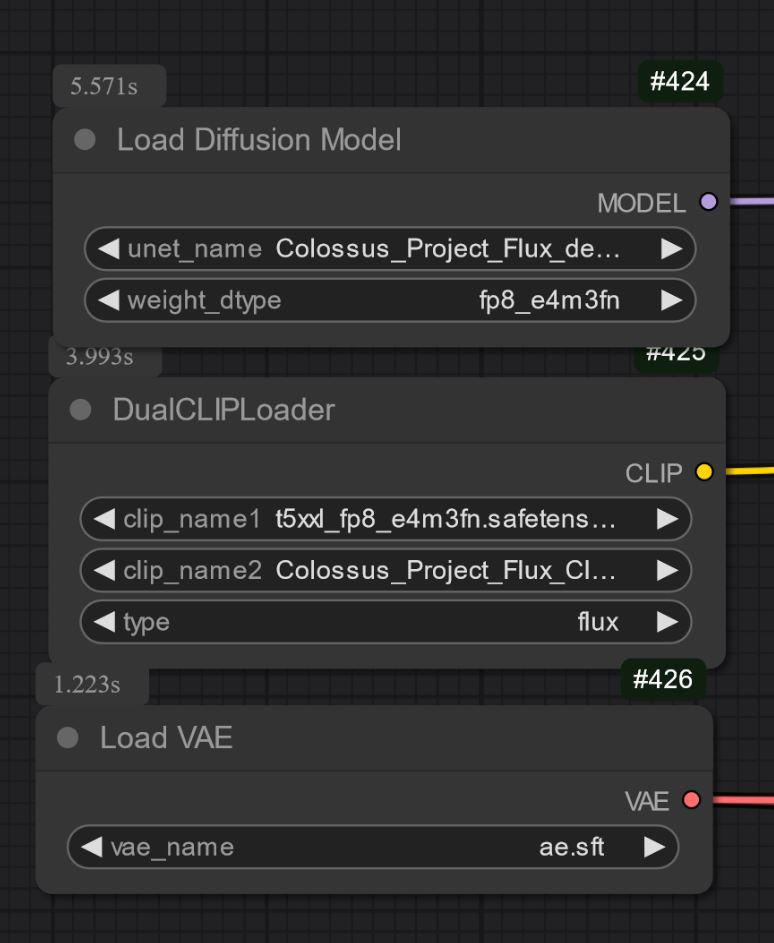

Também é importante escolher o T5xxl clip certo. Para a versão FP8, use o fp8_e4m3fn t5xxl clip. Para FP16, use o clip FP16. Certifique-se de selecionar o tipo de peso padrão. (abaixo há uma imagem exemplo para a versão fp8)

Para a versão GGUF você precisa do carregador GGUF!

Algumas coisas conhecidas por enquanto sobre o V1.0:

Este é só o primeiro modelo da série, então pode apresentar dificuldades com alguns prompts ou estilos como arte. A próxima versão terá mais treinamento. Me diga o que o modelo não consegue fazer...

Configurações e Fluxo de Trabalho:

Testei com cerca de 30 passos, Euler com Simple como scheduler. A orientação pode ser ajustada de 1,5 a 3 (pode experimentar fora dessa faixa também).

O valor 1,8 funciona bem para imagens realistas.

Fique à vontade para experimentar essas configurações... Se conseguir bons resultados, poste-os.

Adicionei as imagens de vitrine como dados de treinamento... Dentro delas está o fluxo para Comfy. Aqui está o fluxo para download: https://civitai.com/articles/7946

Modelo "All in one":

Apenas UNET:

Você precisa também baixar o clip_L. É um arquivo de 240MB.

Você precisa também baixar o clip_L. É um arquivo de 240MB.

GGUF: Adicionei o fluxo para GGUF aqui: https://civitai.com/articles/7946

Importante:

O modelo dev não é destinado a uso comercial. Para isso, publicarei o modelo "schnell" em outro local. É mais destinado ao uso pessoal ou científico.

LICENÇA:

https://huggingface.co/black-forest-labs/FLUX.1-dev/blob/main/LICENSE.md

Créditos:

theunlikely https://huggingface.co/theunlikel (obrigado novamente)

Versão 2.1/V4.2/5.0: Flux_dev_de-distill de nyanko7

https://huggingface.co/nyanko7/flux-dev-de-distill

Desde V2.0: Hyper Lora de ByteDance https://huggingface.co/ByteDance/Hyper-SD

Black Forrest pelo seu incrível modelo Flux https://huggingface.co/black-forest-labs

Detalhes do Modelo

Tipo de modelo

Modelo base

Versão do modelo

Hash do modelo

Criador

Discussão

Por favor, faça log in para deixar um comentário.

Coleção de Modelos - Colossus Project Flux

Colossus Project Flux - v12_int4_SVDQ_nunchaku

Colossus Project Flux - V12 "Hephaistos" FP8_UNET

Colossus Project Flux - v10_AIO_FP8