Stabilizer IL/NAI - nbep11 v0.205

Palavras-chave e Tags Relacionadas

Prompts Recomendados

masterpiece

Parâmetros Recomendados

samplers

steps

cfg

resolution

other models

Dicas

Carregue este LoRA primeiro na sua pilha de LoRAs para minimizar mudanças inesperadas.

Use como modelo base refinado carregando em modelo base pré-treinado com força total para melhores detalhes naturais e controle de estilo.

Se usar um modelo base "illustrious", verifique seu modelo base pré-treinado para evitar degradação de qualidade.

Este modelo não pode adicionar detalhes naturais a modelos base com overfitting de estilo AI.

Ajuste outros pesos cuidadosamente ao empilhar múltiplos LoRAs para evitar resultados quebrados.

Deixe feedback na seção de comentários para visibilidade, não no sistema de avaliações do Civitai.

Evite compartilhar merges com este modelo devido a gatilhos de marca-d'água invisível embutidos.

Patrocinadores do Criador

Última atualização:

(07/09/2025) Você pode me encontrar em TensorArt.

Última atualização:

(07/09/2025) Você pode me encontrar em TensorArt.

Stabilizer

Este é meu modelo base refinado, mas em forma de LoRA.

Este modelo base refinado:

Foca na criatividade, ao invés de um estilo fixo. O conjunto de dados é muito diversificado. Então este modelo não tem estilo padrão (viés) que limite sua criatividade.

Apenas texturas naturais, iluminação e os melhores detalhes. Sem estilo AI plástico. (Mesmos rostos AI, estilo de cabelo, superfícies lisas sem textura, etc...). Eu selecionei manualmente todas as imagens no conjunto de dados. Zero imagens AI no conjunto de dados.

Menos imagens deformadas. Mais lógico. Melhor fundo e composição.

Melhor compreensão de prompt. Treinado com legendas em linguagem natural.

(v-pred) Iluminação melhor e equilibrada, alto contraste. Preto puro 0 e branco 255 podem estar na mesma imagem, até no mesmo lugar, mas sem vazamentos ou saturação excessiva.

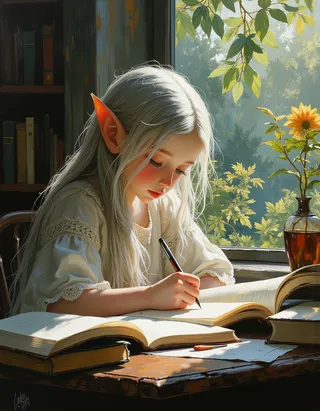

As imagens da capa são as saídas brutas, na resolução padrão de 1MP. Sem upscale, sem plugins, sem correções por inpainting. Possuem metadados, 100% reproduzíveis.

Os estilos nas imagens da capa são do modelo base pré-treinado, ativados pelo prompt. Eles não estão no meu conjunto de dados. Você pode ver que o modelo pré-treinado conhece esses estilos, mas simplesmente não consegue gerá-los adequadamente porque está superajustado a dados de anime. Este modelo corrigiu o problema de overfitting. Veja a seção "como e por que funciona" abaixo.

Por que não há estilo padrão?

O que é "estilo padrão": Se um modelo tem um estilo padrão (viés), isso significa que não importa o que você peça, o modelo deve gerar as mesmas coisas (rostos, fundos, sensações) que compõem o estilo padrão.

Prós: É fácil de usar, você não precisa mais especificar o estilo no prompt.

Contras: Mas você também não pode sobrescrevê-lo. Se você pedir algo que não se encaixa no estilo padrão, o modelo simplesmente ignora. Se empilhar mais estilos, o estilo padrão sempre sobreporá/poluirá/limitará os outros estilos.

"sem estilo padrão" significa sem viés, e você precisa especificar o estilo desejado por tags ou LoRAs. Mas não haverá sobreposição/poluição de estilo deste modelo. Você pode obter exatamente o estilo que combinou.

Por que este "modelo base refinado" é um LoRA?

Eu não sou um gigachad e não tenho milhões de imagens para treino. Refinar o modelo base inteiro não é necessário, um LoRA é suficiente.

Posso economizar muita VRAM para usar tamanhos de lote maiores.

Só preciso enviar, e você só precisa baixar, um arquivo pequeno de 40MiB, em vez de um grande checkpoint de 7GiB, economizando 99,4% de dados e armazenamento.

Então posso atualizar frequentemente.Este LoRA pode parecer pequeno, mas é poderoso. Porque usa uma nova arquitetura chamada DoRA da Nvidia, que é mais eficiente que o LoRA tradicional.

Então como obtenho este "modelo base refinado"?

Simples.

modelo base pré-treinado + Este LoRA = o "modelo base refinado"

Basta carregar este LoRA no modelo base pré-treinado com força total. Então o modelo base pré-treinado se tornará o modelo base refinado. Veja abaixo "Como usar".

Compartilhar merges usando este modelo é proibido. Para sua informação, há palavras gatilho ocultas para imprimir marca-d'água invisível. Eu mesmo codifiquei a marca-d'água e o detector. Eu não quero usá-la, mas posso.

Este modelo é publicado apenas no Civitai e TensorArt. Se você vir "eu" e esta sentença em outras plataformas, todas são falsas e a plataforma que você está usando é uma plataforma pirata.

Por favor, deixe feedback na seção de comentários para que todos possam ver. Não escreva feedback no sistema de avaliações do Civitai, que é mal projetado, ninguém encontra ou vê as avaliações.

Como usar

Últimas versões:

nbvp10 v0.271 (treinado em NoobAI v-pred v1.0).

Cores precisas e detalhes finos. Este é o melhor modelo até agora.

nbep10 v0.273 (treinado em NoobAI eps v1.0). Descontinuado.

Menos saturação e contraste comparado aos modelos v-pred. Devido a uma "pequena falha de design" na predição epsilon padrão. Isso limita o alcance de cores do modelo. Por isso temos o v-pred depois.

illus01 v1.198 (treinado no Illustrious v0.1). Descontinuado.

Simplesmente muito antigo...

Atenção: carregue este LoRA primeiro na sua pilha de LoRAs.

Este LoRA usa uma nova arquitetura chamada DoRA da Nvidia, que é mais eficiente que o LoRA tradicional. Porém, ao contrário do LoRA tradicional que tem um peso fixo, o peso do patch do DoRA é calculado dinamicamente baseado no peso do modelo base carregado (que muda quando você carrega LoRAs). Para minimizar mudanças inesperadas, carregue este LoRA primeiro.

Duas formas de usar este modelo:

1). Usá-lo como modelo base refinado (Recomendado):

Se você quiser os melhores detalhes naturais e construir a combinação de estilos que deseja, com controle total.

Basta carregar este LoRA primeiro no modelo base pré-treinado com força total. Então o modelo base pré-treinado se tornará o modelo base refinado.

2). Usá-lo como LoRA em outro modelo base refinado.

Porque por que não, afinal é um LoRA.

Coisas a notar:

Importante: Se você estiver usando um modelo base "illustrious". Você precisa verificar qual modelo base pré-treinado seu modelo base realmente usa. Os modelos base "illustrious" populares são baseados (ou próximos) ao NoobAI, não illustrious. Leia mais (por que esses modelos base estão rotulados incorretamente e como testar seu modelo base) em "Discussão". O LoRA precisa corresponder ao modelo base pré-treinado. Usar um modelo base incompatível degrada a qualidade da imagem.

Você está prestes a mesclar dois modelos base. Se seu modelo base já tem um estilo padrão muito forte, simplesmente adicionar este LoRA geralmente não dará o resultado esperado. Talvez você precise ajustar outros pesos (LoRAs, blocos U-net, etc).

Este modelo não pode adicionar detalhes naturais a modelos base com estilo AI (treinados com imagens AI, onde tudo parece liso, brilhante, sem textura e plástico). Sei que alguns escolhem este modelo para eliminar a suavidade do estilo AI no modelo base atual. Infelizmente, não funcionará, pois o estilo AI é extremamente superajustado (você aprende instantaneamente o que fez, igual a um modelo AI treinado com imagens AI). E porque imagens AI têm menos detalhes que imagens do mundo real, o modelo também aprendeu a suprimir detalhes. Isso é um problema. Uma vez que o estilo AI está presente, não há como eliminá-lo.

Este modelo não é uma ferramenta mágica que permite empilhar mais LoRAs em um modelo base sem quebrar o resultado. Sei que o nome do modelo pode induzir ao erro.

Por que e como isso funciona:

O problema do overfitting:

Modelos de anime são treinados em imagens de anime. Imagens de anime são simples e contêm apenas "conceitos" em alto nível, geralmente abstratos. Não há fundos, detalhes e texturas.

Queremos que o modelo aprenda apenas "conceitos" em alto nível. A realidade é que o modelo aprende o que vê, não o que você quer.

Depois de ver mais de 10 milhões de imagens simples e abstratas de anime, o modelo aprende que 1) não precisa gerar detalhes porque o conjunto de dados nunca pediu isso, e 2) deve gerar imagens simples com conceitos abstratos, mesmo que não entenda. Isso leva a imagens deformadas, ou "overfitting".

A solução:

Treinar o modelo com imagens de anime e do mundo real. Assim ele aprende conceitos enquanto preserva detalhes e texturas naturais, ou seja, menos overfitting.

NoobAI fez isso misturando algumas imagens reais de cosplay no conjunto de dados. (se não me engano, os desenvolvedores mencionaram isso em algum lugar)

Este modelo vai além, foi treinado com de tudo um pouco. Arquitetura, objetos do dia a dia, roupas, paisagens, ... Também com legendas em linguagem natural completas e multi-nível, para imitar o setup original de treinamento do SDXL.

O resultado:

Veja comparações sem (w/o): 1 (estilos de artistas), 2 (estilos gerais)

Menos overfitting, menos imagens deformadas. Mais texturas, iluminações e detalhes naturais. Agora você pode usar milhares de tags de estilo integradas (Danbooru, tags e621), assim como estilos gerais que o SDXL original entende, e obter uma imagem limpa e detalhada como deve ser. Não importa se é 2D, 3D, abstrato ou realista.

Ainda com máxima criatividade. Graças ao conjunto de dados diverso. Não há estilo padrão. Então não limita a criatividade do modelo pré-treinado, nem de outras LoRAs de estilo.

Conjunto de dados

versão mais recente ou recentes

~7 mil imagens no total. Não tão grande (comparado a gigachads que adoram refinar modelos com milhões de imagens), mas não pequeno. E cada imagem foi escolhida a mão por mim.

Apenas coisas normais e bonitas. Sem estilos de arte loucos que não podem ser descritos. Sem imagens AI, sem marcas d’água, etc.

Apenas imagens em alta resolução. A média de pixels do conjunto é de 3,37 MP, ~1800x1800.

Todas as imagens têm legendas naturais do LLM mais recente do Google.

Todos os personagens de anime foram marcados primeiro pelo wd tagger v3 e depois pelo LLM do Google.

Contém natureza, ambientes externos e internos, animais, objetos do dia a dia, muitas coisas, exceto humanos reais.

Contém todos os tipos de condições de iluminação. Muito escuro, muito claro, muito escuro e claro.

Outras ferramentas

Algumas ideias que iam ou eram parte do Stabilizer. Agora são LoRAs separadas para maior flexibilidade. Link da coleção: https://civitai.com/collections/8274233.

Dark: Um LoRA que favorece ambientes mais escuros. Útil para corrigir viés de alta luminosidade em alguns modelos base. Treinado com imagens de baixa iluminação. Sem viés de estilo, sem poluição de estilo.

Contrast Controller: Um LoRA artesanal. Controla o contraste como um slider no seu monitor. Ao contrário de outros "realçadores de contraste" treinados, o efeito deste LoRA é estável, matematicamente linear, e sem efeito colateral no estilo.

Útil quando seu modelo base tem problemas de saturação excessiva, ou quando você quer algo realmente colorido.

Exemplo:

Style Strength Controller: Ou redutor de efeito de overfitting. Pode reduzir todos os tipos de efeitos de overfitting (viés em objetos, brilho, etc) matematicamente. Ou amplificá-los, se desejar.

Diferenças entre Stabilizer:

Diferenças entre Stabilizer:

Stabilizer foi treinado com dados do mundo real. Ele pode apenas "reduzir" efeitos de overfitting relacionados a textura, detalhes e fundos, adicionando-os de volta.

Style Controller não vem do treinamento. É mais como "desfazer" o treinamento do modelo base, então ele fica menos superajustado. Pode reduzir matematicamente todos os efeitos de overfitting, como viés em brilho, objetos.

Versões antigas:

Você pode encontrar mais informações em "Registro de atualizações". Cuidado que versões antigas podem ter efeitos bem diferentes.

Linha do tempo principal:

Agora ~: Detalhes e texturas naturais, compreensão estável de prompt e mais criatividade. Não limitado ao estilo puro 2D anime.

illus01 v1.23 / nbep11 0.138 ~: Melhor estilo de anime com cores vivas.

illus01 v1.3 / nbep11 0.58 ~: Melhor estilo de anime.

Registro de atualizações

(31/08/2025) NoobAI ep10 v0.273

Esta versão foi treinada desde o início no NoobAI eps v1.0.

Comparado à versão anterior illus01 v1.198:

Brilho melhor e equilibrado em condições extremas. (igual ao nbvp v0.271)

Melhores texturas e detalhes. Tem mais etapas de treinamento em timesteps com alto SNR. (versões illus01 pulavam esses timesteps para melhor compatibilidade. Agora todos os modelos base são NoobAI, não precisa mais pular.)

(24/08/2025) NoobAI v-pred v0.271:

Comparado à versão anterior v0.264:

Iluminação melhor e equilibrada em condição extrema, menos viés.

Alto contraste, preto puro 0 e branco 255 na mesma imagem, mesmo no mesmo lugar, sem vazamentos ou saturação excessiva. Agora você pode ter todos ao mesmo tempo.

(v0.264 antigo tentava limitar a imagem entre 10~250 para evitar vazamentos, e ainda tinha viés perceptível, imagem geral podia ficar muito escura ou clara)

Igual ao v0.264, prefere força alta ou total (0.9~1).

(17/08/2025) NoobAI v-pred v0.264:

Primeira versão treinada no NoobAI v-pred.

Te dá melhor iluminação, menos vazamentos.

Atenção: prefira força alta ou total (0.9~1).

(28/07/2025) illus01 v1.198

Principalmente comparado ao v1.185c:

Fim da versão "c". Embora "visualmente marcante" seja bom, tinha problemas de compatibilidade. Ex: quando seu modelo base já tem melhoria para contraste. Empilhar dois realces de contraste é ruim. Então, nada mais de efeitos exagerados (alto contraste e saturação, etc.).

Em vez disso, mais texturas e detalhes. Iluminação em nível cinematográfico. Melhor compatibilidade.

Esta versão mudou muitas coisas, incluindo revisão do conjunto de dados, então o efeito será bastante diferente das versões anteriores.

Para quem quer os efeitos loucos do v1.185c de volta. Você pode encontrar estilos artísticos puros e dedicados nesta página. Se o conjunto for grande o suficiente para um LoRA, posso treinar um.

(21/06/2025) illus01 v1.185c:

Comparado ao v1.165c.

+100% de nitidez e clareza.

-30% imagens muito caóticas (não podem ser descritas adequadamente). Então essa versão não consegue mais dar níveis de contraste muito altos, mas deve ser mais estável em usos normais.

(10/06/2025): illus01 v1.165c

Esta é uma versão especial. Não é uma melhoria do v1.164. "c" significa "colorido", "criativo", às vezes "caótico".

O conjunto de dados contém imagens que são muito visualmente marcantes, mas às vezes difíceis de descrever, exemplo: Muito colorido. Alto contraste. Condições complexas de iluminação. Objetos, padrões complexos por toda parte.

Então você terá "visualmente marcante", mas à custa do "natural". Pode afetar estilos com cores suaves, etc. Ex: esta versão não consegue gerar a textura "arte a lápis" perfeitamente como v1.164.

(04/06/2025): illus01 v1.164

Melhor compreensão de prompt. Agora cada imagem tem 3 legendas naturais, de perspectivas diferentes. As tags Danbooru são checadas pelo LLM, apenas as importantes são selecionadas e fundidas na legenda natural.

Anti-sobre-exposição. Foi adicionado um viés para prevenir que a saída do modelo atinja o branco puro #ffffff. Na maioria das vezes, #ffffff == superexposição, o que causa perda de detalhes.

Mudanças em configurações de treinamento. Tornou-o mais compatível com NoobAI, tanto e-pred quanto v-pred.

(19/05/2025): illus01 v1.152

Continua melhorando iluminação, texturas e detalhes.

5 mil imagens a mais, mais etapas de treinamento, como resultado, efeito mais forte.

(09/05/2025): nbep11 v0.205:

Correção rápida de problemas de brilho e cor no v0.198. Agora não deve alterar brilho e cores dramaticamente como uma foto real. v0.198 não era ruim, só criativo demais.

(07/05/2025): nbep11 v0.198:

Adicionou mais imagens escuras. Menos deformações no corpo, fundo em ambientes escuros.

Removeu realce de cor e contraste. Porque não é mais necessário. Use o Contrast Controller em vez disso.

(25/04/2025): nbep11 v0.172.

Mesmas novidades do illus01 v1.93 ~ v1.121. Resumo: Novo conjunto fotográfico "Touching Grass". Melhor textura natural, fundo, iluminação. Efeitos de personagem mais fracos para melhor compatibilidade.

Melhor precisão e estabilidade de cor. (Comparado ao nbep11 v0.160)

(17/04/2025): illus01 v1.121.

Reverteu para illustrious v0.1. illustrious v1.0 e versões mais recentes foram treinados deliberadamente com imagens AI (talvez 30% do seu conjunto). O que não é ideal para treinamento LoRA. Eu não percebi até ler o paper.

Efeito de estilo de personagem reduzido. Voltou ao nível v1.23. Personagens terão menos detalhes com este LoRA, mas devem ter melhor compatibilidade. É uma troca.

Outros aspectos iguais ao abaixo (v1.113).

(10/04/2025): illus11 v1.113 ❌.

Atualização: use esta versão somente se saber que seu modelo base é baseado em Illustrious v1.1. Caso contrário, use illus01 v1.121.

Treinado no Illustrious v1.1.

Adicionado novo conjunto "Touching Grass". Melhor textura natural, iluminação e efeito de profundidade. Estabilidade estrutural melhor do fundo. Menos deformações no fundo, como quartos e prédios deformados.

Legendas completas em linguagem natural do LLM.

(30/03/2025): illus01 v1.93.

v1.72 foi treinado demais. Então reduzi sua força geral. Deve ter melhor compatibilidade.

(22/03/2025): nbep11 v0.160.

Mesmas mudanças na illus v1.72.

(15/03/2025): illus01 v1.72

Mesmo novo conjunto de texturas e iluminação mencionado no ani40z v0.4 abaixo. Iluminação e texturas mais naturais.

Adicionado um pequeno conjunto de ~100 imagens focadas em aprimoramento de mãos, com diferentes tarefas, como segurar um copo, etc.

Removidas todas as imagens de "fundo simples" do conjunto. -200 imagens.

Troca da ferramenta de treino de kohya para onetrainer. Alteração da arquitetura LoRA para DoRA.

(04/03/2025) ani40z v0.4

Treinado no Animagine XL 4.0 ani40zero.

Adicionado ~1k de imagens focadas em iluminação dinâmica natural e texturas do mundo real.

Iluminação e texturas mais naturais.

ani04 v0.1

Versão inicial para Animagine XL 4.0. Principalmente para corrigir problemas de brilho do Animagine 4.0. Melhor e maior contraste.

illus01 v1.23

nbep11 v0.138

Adicionadas algumas imagens furry/não humanas/outras para equilibrar o conjunto de dados.

nbep11 v0.129

Versão ruim, efeito muito fraco, ignore.

nbep11 v0.114

Implementado "Cores em alcance total". Ele irá automaticamente equilibrar as coisas para "normal e bom aspecto". Pense nisso como o botão "auto aprimorar foto com um clique" da maioria das ferramentas de edição. Uma desvantagem dessa otimização: impede viés alto. Por exemplo, querer 95% da imagem preta e 5% clara, em vez de 50/50%.

Adicionado um pouco de dados realistas. Detalhes mais vivos, iluminação, cores menos chapadas.

illus01 v1.7

nbep11 v0.96

Mais imagens para treino.

Depois refinado novamente com um pequeno conjunto "wallpaper" (papéis de parede reais de jogos, a melhor qualidade que achei, ~100 imagens). Mais melhorias nos detalhes (notável em pele, cabelo) e contraste.

nbep11 v0.58

Mais imagens. Mudança dos parâmetros de treino para ficar próximo do modelo base NoobAI.

illus01 v1.3

nbep11 v0.30

Mais imagens.

nbep11 v0.11: Treinado no NoobAI epsilon pred v1.1.

Tags do conjunto de dados melhoradas. Estrutura e distribuição dos pesos no LoRA melhoradas. Deve ser mais estável e impactar menos na composição da imagem.

illus01 v1.1

Treinado no illustriousXL v0.1.

nbep10 v0.10

Treinado no NoobAI epsilon pred v1.0.

Detalhes do Modelo

Tipo de modelo

Modelo base

Versão do modelo

Hash do modelo

Criador

Discussão

Por favor, faça log in para deixar um comentário.

Coleção de Modelos - Stabilizer IL/NAI

Stabilizer IL/NAI - illus01 v1.23

Stabilizer IL/NAI - illus01 v1.121

Stabilizer IL/NAI - illus01 v1.185c

Stabilizer IL/NAI - nbep11 v0.138

Stabilizer IL/NAI - illus01 v1.152

Stabilizer IL/NAI - illus01 v1.165c

Stabilizer IL/NAI - nbep11 v0.205

Stabilizer IL/NAI - illus01 v1.72

Stabilizer IL/NAI - illus01 v1.198

Stabilizer IL/NAI - nbep11 v0.114