Colossus Project Flux - v10_int4_SVDQ

相關關鍵字和標籤

推薦反向提示詞

blurry

推薦參數

samplers

steps

cfg

resolution

vae

提示

使用包含 'blurry' 一詞的負面提示詞,以提升輸出品質。

FP4 版本僅適用 Nvidia 50xx 系列顯卡;int4 版本支援 40xx 及以下(最低需 20xx 系列)。

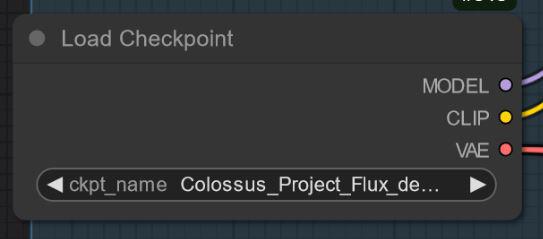

"All in One" 模型內嵌 Clip_l、T5xxl 和 VAE,使用更簡便。

嘗試使用各種採樣器,如 Euler、Heun、DPM++2M、deis、DDIM,推薦使用 "Simple" 調度器。

嘗試於 1.5 至 3 之間調整引導比例(cfg),預設約為 2.2 至 2.3,以獲得最佳結果。

FP8 版本在品質和性能間提供良好平衡。

針對特殊『de-distilled』版本,請關閉 Flux Guidance 比例,改用 cfg 控制。

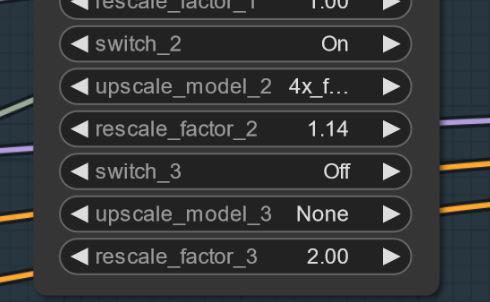

若出現異常(artefacts),嘗試小幅升級(如 1.14 倍而非 1.2 倍)以減輕問題。

工作流程與詳細指南可參考 Civitai 文章中的鏈接。

版本亮點

版本 V10_int4_SVDQ "Nunchaku"

安裝:請參考我的工作流程/安裝指南: https://civitai.com/articles/15610

首先感謝 theunlikely https://huggingface.co/theunlikely 將 FP16_Unet 轉換成 int4_SVDQ。請訪問他的頁面並點贊支持。

此版本與 FP8 版本大致相同。即使在我工作流程的普通模式下,此模型速度約為常規模型的兩到三倍。使用工作流程的「快速模式」,我用 3090ti 可以在約 19 秒內渲染一張 2MP 圖片。

什麼是 SVDQ "Nunchaku"?

這種新量化技術能將 Flux 模型(此處為原生 FP16 模型)大小從 24GB 壓縮至約 6.7GB。但不僅如此:它能比以往更快生成圖像,且損失質量極少。當然,相較我的 32GB_Behemoth 模型會有細微差異,但後者需要更多 VRAM/RAM 才能運行。

更多資訊請訪問:https://github.com/mit-han-lab/ComfyUI-nunchaku?tab=readme-ov-file

創作者贊助

於 Ko-Fi 支持創作者:https://ko-fi.com/afroman4peace

下載由 Nunchakutech 的 Muyang Li 量化的模型:https://huggingface.co/nunchaku-tech/nunchaku-flux.1-dev-colossus

Civitai 的工作流程指南:

https://civitai.com/articles/17313

https://civitai.com/articles/17358

https://civitai.com/articles/17163

https://civitai.com/articles/15610

https://civitai.com/articles/11950/workflow-for-colossus-project-flux-50

https://civitai.com/articles/8419

https://civitai.com/articles/7946

Nunchaku SVDQ 量化 GitHub:https://github.com/mit-han-lab/ComfyUI-nunchaku?tab=readme-ov-file

在山脈深處沉睡著一位巨人,能夠協助人類亦或帶來毀滅……

Colossus 醒來了……

繼 SDXL 系列之後,現在是此專案的 FLUX 系列時候……這次我從零開始訓練。訓練使用我自己的圖片,這些圖像是利用我的 schnell Flux 模型 DemonFlux/Colossus Project schnell 加上我的 SDXL Colossus Project 12 作為優化器創造而成。

此 SD Flux 檢查點幾乎能生成所有內容……Colossus 非常擅長創造極具真實感的圖片、動漫及藝術作品。

如果你喜歡,可以隨時給我一些回饋。如果你想支持我,也可以在此處贊助。我花了不少錢建構能夠真正訓練 Flux 模型的電腦,訓練及測試也耗費大量時間與電力……

https://ko-fi.com/afroman4peace

版本 V12 "Hephaistos"

發布此檢查點讓我既開心又難過……V12 將是本系列最後一個檢查點,主要原因是即將實施的歐盟 AI 法規,另一個原因是 Flux .1 DEV 本身的授權限制。感謝大家一直以來的支持!過去一年我投入了大量時間於此專案,現在是時候轉向新的專案了。

無論如何,我會為本系列畫下完美句點……

V12 基於 V10B "BOB",基本上將此系列中最優秀的部分區塊合併到這個檢查點。(這是透過一種新合併方法完成,耗時約 1 小時 30 分,使用了我全部的 128GB 記憶體。)相比 V10,我增強了臉部與皮膚紋理,眼睛更為真實且更具生命感。

歡迎自行測試並回饋關於 V12 的意見。由於我的網速較慢,我會先上傳 FP8_UNET,接著是 FP8 "all in one" 版本,然後是 FP16_unet 和 FP16_BEHEMOTH。我也會嘗試將其轉換為 int4 及 fp4(請為我加油)。

一如既往,請給予我對 V12 的反饋……

版本 V12 "Behemoth" (一體化版)

此 "all in one" 模型是我 V12 系列中最優秀的,當然也是體積最大的一款 :-)

Behemoth 內嵌了自訂 T5xxl 及 Clip_l。若你重視品質勝過數量,此檢查點非常適合你!

版本 V12 FP4/int4

感謝 Nunchakutech 的 Muyang Li 對 V12 進行量化。https://huggingface.co/nunchaku-tech 及其驚人的 nunchaku!

這版本真是令人讚嘆,前所未有地將品質與速度結合。

注意!

有兩個版本 FP4 與 int4。FP4 僅適用於 Nvidia 50xx 系列顯卡!而 int4 支援 40xx 及以下系統。(需至少 20xx 系列顯卡)

您也可以在此直接下載兩個版本:https://huggingface.co/nunchaku-tech/nunchaku-flux.1-dev-colossus

安裝指南與工作流程

這裡有一份快速安裝指南和正在進行的工作流程。

https://civitai.com/articles/17313

詳細的工作流程指南

https://civitai.com/articles/17358

我仍在為 Nunchaku 開發新的工作流程,所以下述工作流程目前仍屬進行中,週末會補充詳細文章。

版本 V12 FP16_B_variant

謝謝我凌晨兩點犯的一個小錯誤,我錯誤地命名並上傳了「錯誤」的檢查點。這是個非常實驗性的檢查點,原本不打算發布。未經充分測試,但在展示時表現出色,可能優於標準版本。

它偏好亞洲臉孔,因為我想測試將此與我仍在研究的側專案混合的可能性。請告訴我你使用此檢查點的體驗 :-)

版本 V12 AIO FP8

此版本為 V12 的一體化版本,所有 Clip 均嵌入其中。其輸出與帶有我自訂 clip_l 的 FP8_unet 相同。

版本 V12 GGUF Q5_1

此版本為應要求製作,品質不錯。

版本 V10B "BOB"

這是 V10 的另一版本。我製作它是為了提升 V10 的 FP8 版本。整體而言,FP8 版本更精確且色彩更佳。最近時間有限(現實優先),所以耗時較久。若你喜歡這版本,請告訴我。我也有一個 "BOB" 的 FP16 版本,視回饋考慮是否發布 int4 版本。

工作流程:

這是 V12 和 V10 的工作流程:https://civitai.com/articles/17163

版本 V10_int4_SVDQ "Nunchaku"

首先感謝 theunlikely https://huggingface.co/theunlikely 將 FP16_Unet 轉換為 int4_SVDQ。請去他的頁面支持一下。

此版本與 FP8 版本大致相當。即使在我流程中的普通模式下,它的速度比常規模型快約2至3倍。透過工作流程的「快速模式」,我用 3090ti 可以在約 19 秒內渲染一張 2MP 圖片。

什麼是 SVDQ "Nunchaku"?

此新量化方法可將 Flux 模型(此案例為原生 FP16 模型)由24GB壓縮至約6.7GB。但不僅如此:你能更快地生成圖像,且幾乎不失品質。當然,相比我 32GB_Behemoth 模型會有小幅差異,但後者需要更多的 VRAM/RAM 才能運行。

更多資訊請見:https://github.com/mit-han-lab/ComfyUI-nunchaku?tab=readme-ov-file

安裝:請參考我的工作流程/安裝指南:https://civitai.com/articles/15610

版本 V10 "Behemoth" (FP16_AIO)

此版本仍屬實驗中,主要目標為取得更真實的結果,同時減少「Flux 線條」。基於 Colossus Project V5.0_Behemoth、V9.0 及另一專案 "Ouroborus Project"。

FP16 版本非常穩定,近期也會發布 FP8 版本,FP8 不錯但穩定性不及 FP16。

歡迎你嘗試並告訴我對此版的看法。

祝創作愉快 :-)

版本 V9.0:

先說說為何叫 V9.0?

我近期搬新家,網路供應商造成一些問題,導致沒真正的網路連線。搬家的同時,我讓電腦持續運轉。結果製作了許多(大部分損壞的)檢查點。不過我依然有一些不錯的 V8 版本,未來可能會發布。

變更內容?

我訓練了臉部與皮膚紋理,基本上吸取 V5.0 最佳成果。也加入腳與腿部訓練以強化解剖構造。V5.0 有時會裁減頭部與腳部,我認為已修正部分問題。

此外,我加入更多自己的風景圖像訓練,而且這一切都是在搬家同時完成,總計約兩週的運算時間,也花費不少電費(每小時約 25 分電費)。

希望你會喜歡這版本。如欲支持,可上傳美圖,或於 Buzz 或 Ko-fi 小額贊助。

請告訴我你的看法 :-)

版本 5.0:

V5.0 基於 V4.2 和 V4.4(後者也會很快發布),額外針對皮膚細節與解剖進行訓練,修正手部與乳頭等問題。臉部細節更佳,嘗試修復些微 Flux 線條。

整體而言,此版本比 V4.2 更寫實,細節更細膩。與 V4.2 類似,此版本亦為混合型 de-distilled 模型,基本使用相同設定。

以下為新工作流程試用:https://civitai.com/articles/11950/workflow-for-colossus-project-flux-50

比較此版本與 4.2 或 V2.1,請告訴我你的想法。

版本 4.4 "Research":

此版本純屬補全,略優於 V4.2,也是版本 5.0 的基礎。可搭配 V5.0 及 V4.2 的工作流程使用。

版本 4.2:

此版本為 Demoncore Flux 與 Colossus Project Flux 的進一步開發,目標為穩定輸出、改善皮膚細節,優化手部與多樣化臉型。訓練基於混合模型,部分來自 Demoncore Flux。乳頭與 NSFW 細節略有加強。請告訴我你是否偏好 V4.2 而非版本 2.1 :-)

展示圖片僅使用原生 SDXL 解析度或 2MP(如 1216x1632)圖片。此模型可處理更高解析度,我測試過最高至 2500x2500,建議使用約 2000x2000。

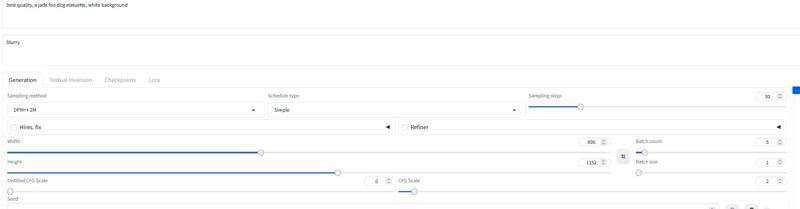

建議設定約 30 步,cfg 2-2.5,我多用 2.2-2.3。展示中使用 DPM++ 2M 配 Simple 調度器。

近期將加入更多版本,但聖誕節前時間有限。

設定

我將很快補充專門的 Comfy 工作流程。你目前可下載並打開展示圖片。

"All in One" 版本也適用 Forge。

基本設定與版本 2.1 相同(詳見下文)。

使用 20-30 步,cfg 約 2.2。

版本 2.1_de-distilled_experimental (合併版)

此版本截然不同,實際運作也與一般 Flux 模型有別!

這是我版本 2.0 與一個 de-distilled 版本 https://huggingface.co/nyanko7/flux-dev-de-distill 的實驗性合併。偶然產生但結果令人震驚,細節極為豐富,且對提示詞響應非常好。接下來我將直接訓練 de-distilled 模型,並已做過若干 Lora 測試。此模型高度實驗性,若發現未列出的錯誤請告知,亦歡迎分享優劣作品,助其改進。也可嘗試版本 2.0,告訴我你喜歡哪種檢查點類型。

注意!

普通 Flux 工作流程不適用此版本。必須下載我提供的專用工作流程!

你也可自行嘗試,但請勿責怪我造成的畫質問題。此外此模型屬高度實驗性,請參閱下方缺點。

此檢查點的優缺點:

此檢查點可生成極致細節,但代價是比一般 Flux 檢查點慢。優點是常常可省去額外升級,模型使用 cfg 控制,不依賴 Flux Guidance,故不適用標準工作流程。

可使用負面提示詞!幫助剔除不想要的元素。

有時會產生 artefacts,可透過簡單小幅升級(將升級倍率設為 1.14 而非 1.2)改善。(我正努力修復)以下為示例,此狀況並非每個 seed 均出現。更新:這是工作流程問題非模型本身缺陷。

設定與工作流程 V2.1:

工作流程地址:https://civitai.com/articles/8419

設定:與普通 Flux 不同,此版本不需 Flux Guidance scale,改用 cfg 控制。我工作流程多設為 3 cfg,部分圖片可能需較低設定。

最重要的是關閉 Flux Guidance scale。

未使用專用工作流程,我測試為30步,2-3 cfg。此亦適用於 Forge,歡迎試驗。

建議在負面提示詞加入 "blurry"。

採樣器與調度器:

可使用以下多種採樣器:

Euler、Heun、DPM++2m、deis、DDIM 表現優異。

我多用 "simple" 作為調度器。

如發現更佳設定,請分享給我 :-)

Forge 推薦使用 AIO 模型,以下為示例設定:

版本 2.0_dev_experimental

這是實驗版,目標為打造更連貫且更快的模型。我融入自訓 Lora 並以特殊方法(Tensor merge)合併。搭配自訂的 T5xxl 與 "Attention Seeker" 優化。為提升速度與品質,我合併了 ByteDance 的 Hyper Flux Lora。這改變了模型工作範圍,以下為主標題圖片示意。

16 步 V 2.0

30 步 V 1.0

30 步 V 1.0

缺點:

缺點:

首先,此版本比之前稍大;其次,我仍需製作僅 UNET 版本,完成後會更新。

設定與工作流程 V2.0:

現可用較少步數操作模型,16 步等於舊版的 30 步。

我仍建議約 20-30 步,以取得更佳品質。

採樣器喜歡 Euler 且搭配 Simple 調度器。指導強度介於 1.5-3,自行嘗試範圍外亦可。1.8 的指導強度適合寫實圖像。DPM++2M 與 Heun 也效果佳。

工作流程 2.0:

創建了 V2.0 與 V1.0 的新工作流程,具備 Flux Prompt Generator 與第二階段升級功能。https://civitai.com/articles/7946

Forge:

我測試該模型於 Forge 上運作良好,但 Comfy UI 與 Forge 輸出圖片或略有差異。

版本 1.0_dev_beta:

此為系列首個模型,請提供回饋並分享作品,有助於改進專案。版本眾多,質量最佳的是FP16 版本,其體積較大,需高階顯卡與大量記憶體。FP8 版本在質量與性能間有良好平衡。若想要 GGUF 版本可下載 Q8_0。GGUF Q4_0/4.1 版本應需求製作,體積較小,但品質稍有犧牲。

有兩種模組:「All in one」僅需下載一個檔案,內含 Clip_l、T5xxl fp8 與 VAE(詳見下方)。請將其放置於你的檢查點資料夾中。

另一種為僅 UNET,需分別載入各檔案。

無論如何,你需要下載我的 Clip_L 以保證其正常運作。

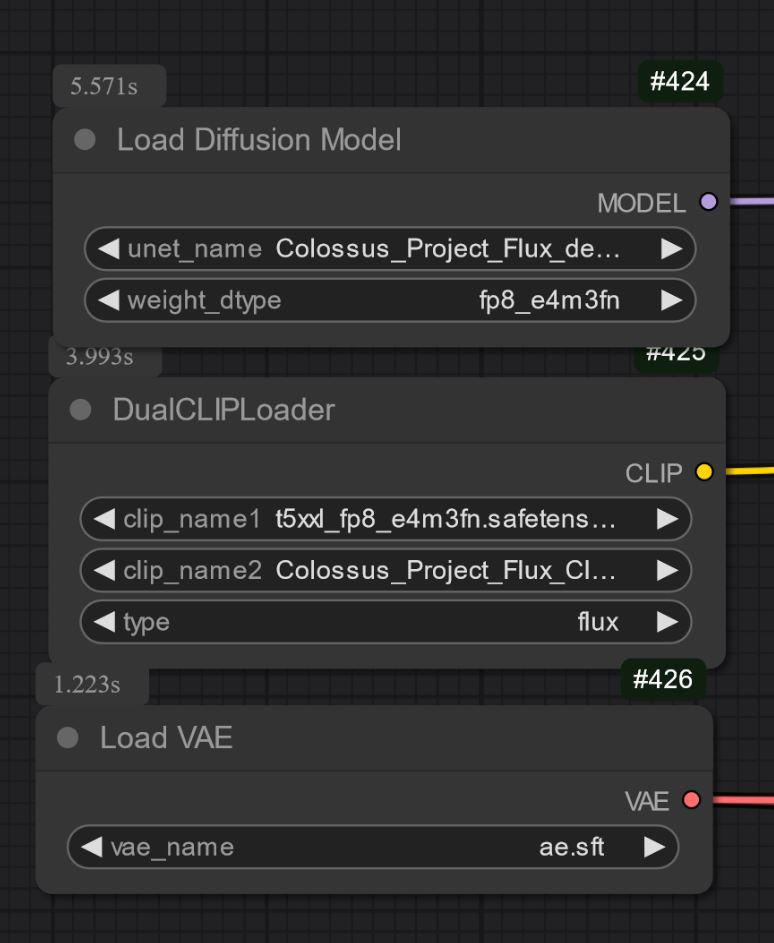

亦須正確選擇 T5xxl clip。FP8 版本使用 fp8_e4m3fn t5xxl clip,FP16 使用 FP16 clip,務必選擇預設權重類型。(以下為 fp8 版示意圖)

GGUF 版本需使用 GGUF 加載器!

目前已知此 V1.0 相關事項:

這是該系列首款模型,因此可能在某些提示詞或藝術風格下表現不佳。接下來版本將獲得更多訓練。若有無法完成的項目,請告知。

設定與工作流程:

我測試約 30 步,Euler 採樣器配 Simple 調度器。指導強度為 1.5-3,範圍外亦歡迎嘗試。

指導強度 1.8 適合寫實圖片。

歡迎嘗試這些設定,取得良好結果請分享。

我已將展示圖片用作訓練資料,內含 Comfy 工作流程。可下載工作流程: https://civitai.com/articles/7946

"All in one" 模型:

僅 UNET:

請同時下載 clip_L,約 240MB。

請同時下載 clip_L,約 240MB。

GGUF:我在此新增了 GGUF 工作流程: https://civitai.com/articles/7946

重要:

此開發模型非商業用途,我會在其它地方發布 "schnell" 模型,偏向個人或科學用途。

授權:

https://huggingface.co/black-forest-labs/FLUX.1-dev/blob/main/LICENSE.md

致謝:

theunlikely https://huggingface.co/theunlikel(再次感謝)

版本 2.1/V4.2/5.0: 來自 nyanko7 的 Flux_dev_de-distill

https://huggingface.co/nyanko7/flux-dev-de-distill

自 V2.0 起:ByteDance 的 Hyper Lora https://huggingface.co/ByteDance/Hyper-SD

感謝 Black Forrest 旗下的優秀 Flux 模型 https://huggingface.co/black-forest-labs

模型合集 - Colossus Project Flux

Colossus Project Flux - v12_int4_SVDQ_nunchaku

Colossus Project Flux - V12 "Hephaistos" FP8_UNET

Colossus Project Flux - v10_AIO_FP8

Colossus Project Flux - v10_int4_SVDQ