SD XL - v1.0

Mots-clés et tags associés

Paramètres recommandés

resolution

Conseils

Le modèle est destiné à des fins de recherche incluant la génération d’œuvres d’art, outils éducatifs, et déploiement sécurisé.

Il n’est pas destiné à générer des représentations factuelles ou vraies de personnes ou d’événements.

Les limitations incluent un photoréalisme imparfait, l’incapacité à rendre un texte lisible, des défis avec les prompts compositionnels, et une possible mauvaise génération des visages.

Le modèle utilise deux encodeurs textuels pré-entraînés : OpenCLIP-ViT/G et CLIP-ViT/L.

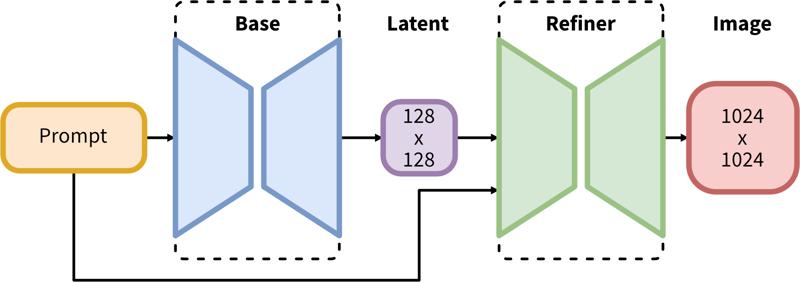

Le pipeline en deux étapes inclut la génération latente de base suivie d’un affinage haute résolution utilisant SDEdit (img2img).

Sponsors du créateur

Originalement Publié sur Hugging Face et partagé ici avec la permission de Stability AI.

Originalement Publié sur Hugging Face et partagé ici avec la permission de Stability AI.

SDXL consiste en un pipeline en deux étapes pour la diffusion latente : d'abord, nous utilisons un modèle de base pour générer les latents de la taille de sortie désirée. Ensuite, nous utilisons un modèle spécialisé haute résolution et appliquons une technique appelée SDEdit (https://arxiv.org/abs/2108.01073, également connue sous le nom de "img2img") aux latents générés à la première étape, en utilisant la même invite.

Description du Modèle

Développé par : Stability AI

Type de modèle : Modèle génératif texte-image basé sur la diffusion

Description du Modèle : Il s'agit d'un modèle qui peut être utilisé pour générer et modifier des images à partir de prompts textuels. C'est un Modèle de Diffusion Latente utilisant deux encodeurs textuels fixes et pré-entraînés (OpenCLIP-ViT/G et CLIP-ViT/L).

Ressources pour plus d'informations : Dépôt GitHub.

Sources du Modèle

Démo [optionnel] : https://clipdrop.co/stable-diffusion

Utilisations

Utilisation Directe

Le modèle est destiné uniquement à la recherche. Les domaines et tâches possibles incluent

La génération d'œuvres d'art et l'utilisation dans le design et autres processus artistiques.

Les applications dans les outils éducatifs ou créatifs.

La recherche sur les modèles génératifs.

Le déploiement sécurisé de modèles ayant le potentiel de générer du contenu nuisible.

L'exploration et la compréhension des limites et biais des modèles génératifs.

Les usages exclus sont décrits ci-dessous.

Usages hors périmètre

Le modèle n'a pas été entraîné pour représenter de manière factuelle ou vraie des personnes ou des événements, et donc l'utilisation du modèle pour générer ce type de contenu est hors périmètre pour les capacités de ce modèle.

Limitations et Biais

Limitations

Le modèle n’atteint pas un photoréalisme parfait

Le modèle ne peut pas rendre un texte lisible

Le modèle éprouve des difficultés avec des tâches plus complexes impliquant la composition, comme rendre une image correspondant à « Un cube rouge au-dessus d’une sphère bleue »

Les visages et les personnes en général peuvent ne pas être générés correctement.

La partie d’auto-encodage du modèle est avec perte.

Biais

Bien que les capacités des modèles de génération d’images soient impressionnantes, ils peuvent aussi renforcer ou exacerber des biais sociaux.

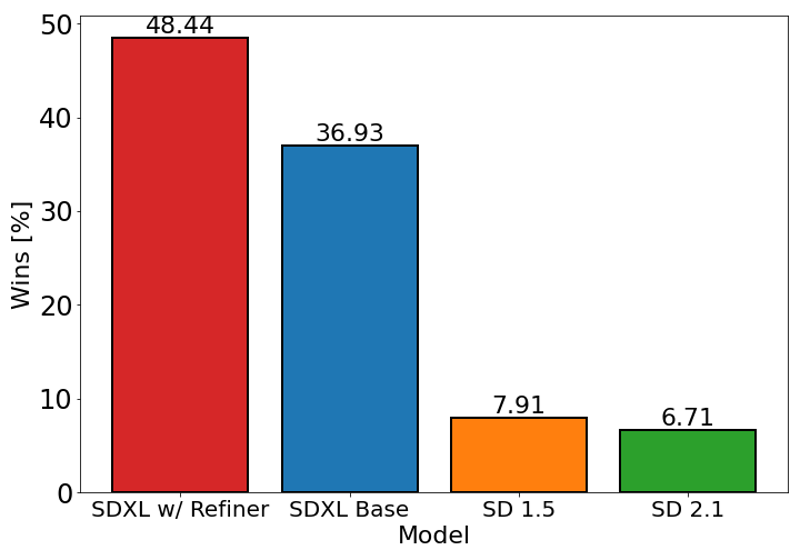

Le graphique ci-dessus évalue la préférence utilisateur pour SDXL (avec et sans affinage) par rapport à Stable Diffusion 1.5 et 2.1. Le modèle de base SDXL performe significativement mieux que les versions précédentes, et le modèle combiné avec le module de raffinage atteint la meilleure performance globale.

Détails du modèle

Type de modèle

Modèle de base

Version du modèle

Hash du modèle

Discussion

Veuillez vous log in pour laisser un commentaire.